パート2前戯

今日は、VMWare vSphereクラスターのニーズを満たすために、2台のLinuxベースのサーバーから予算フェイルセーフiSCSIストレージを作成した方法を説明します。 同様の記事(

たとえば )がありましたが、私のアプローチは多少異なり、そこで使用されているソリューション(同じハートビートとiscsitarget)はすでに古くなっています。

この記事は、「カーネルをパッチしてコンパイルする」というフレーズを恐れない経験豊富な管理者を対象としていますが、一部の部分はコンパイルせずに単純化して省くことができますが、自分でどのように書くかを説明します。 素材を膨張させないために、いくつかの簡単なことをスキップします。 この記事の目的は、すべてを段階的に概説するのではなく、一般的な原則を示すことです。

入門

私の要件は単純でした。単一障害点のない仮想マシン用のクラスターを作成しました。 また、ボーナスとして、ストレージはデータを暗号化できる必要があり、サーバーをドラッグした敵が彼らに届かないようにしました。

VSphereは、最も確立された完成品としてハイパーバイザーとして選択され、iSCSIは、FCまたはFCoEスイッチの形で追加の金融注入を必要としないため、プロトコルとして選択されました。 オープンソースのSASターゲットでは、それは悪くないにしてもかなりきついので、このオプションも拒否されました。

ストレージは残ります。 主要ベンダーのさまざまなブランドソリューションは、自社と同期レプリケーションのライセンスの両方のコストが高いために破棄されました。 したがって、私たちは自分でそれを行うと同時に、学習します。

ソフトウェアが選択されたとき:

- Debian Wheezy + LTS Core 3.10

- iSCSI ターゲットSCST

- レプリケーション用のDRBD

- クラスタリソースの管理と監視のためのPacemaker

- 暗号化のためのDM-Cryptコアサブシステム(プロセッサ内のAES-NI命令は非常に役立ちます)

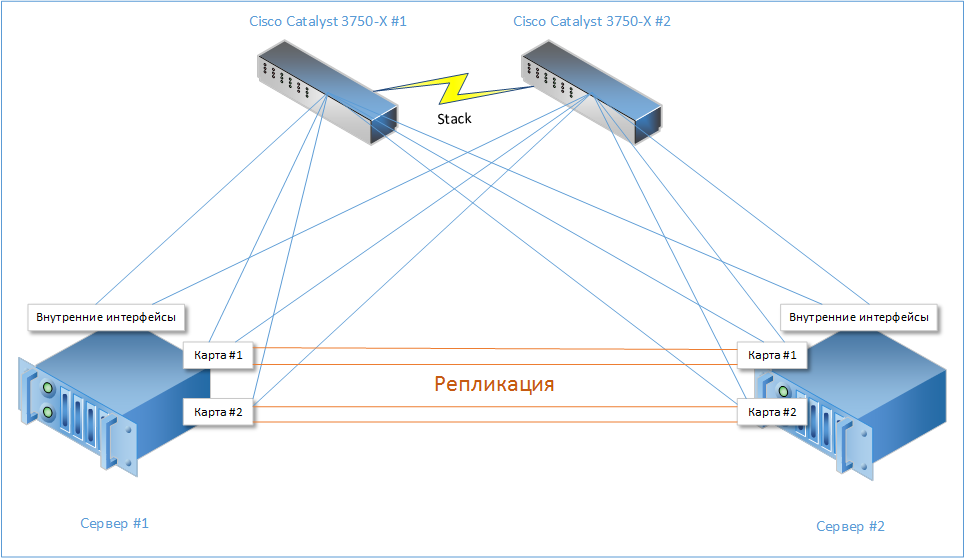

その結果、短い苦痛の中で、そのような単純なスキームが生まれました。

各サーバーに10ギガビットインターフェース(2つの組み込みと4つの追加ネットワークカード)があることを示しています。 それらのうち6つはスイッチスタックに接続され(それぞれ3つ)、残りの4つは隣接サーバーに接続されます。

また、DRBDを介したレプリケーションも行われます。 レプリケーションカードは、必要に応じて10 Gbpsに置き換えることができますが、手元に持っていたので、「それが何であるかを盲目にしました」。

したがって、いずれかのカードが突然死亡しても、どのサブシステムも完全に機能しなくなることはありません。

これらのストレージの主なタスクは、大容量データ(ファイルサーバー、メールアーカイブなど)の信頼できるストレージであるため、3.5インチディスクのサーバーを選択しました。

ビジネス向け

ディスク

各サーバーに8つのディスクの2つのRAID10アレイを作成しました。

以来RAID6を拒否することを決定 十分なスペースがあり、ランダムアクセスタスクでのRAID10のパフォーマンスが向上しています。 さらに、この場合の再構築時間と負荷を下回るのは1つのディスクのみであり、アレイ全体ではありません。

一般的に、ここでは誰もが自分で決定します。

ネットワーク部

iSCSIプロトコルでは、ボンディング/イーサチャネルを使用して速度を上げることは意味がありません。

理由は簡単です-同時に、ハッシュ関数を使用してチャネルを介してパケットを配布するため、そのようなIP / MACアドレスを選択してIP1からIP2へのパケットが1つのチャネルを通過し、IP1からIP3を別のチャネルへ通過させることは非常に困難です。

ciscoには、パケットがどのEtherchannelインターフェイスを飛行するかを確認できるコマンドもあります。

したがって、ここでは、構成するLUNへの複数のパスを使用することをお勧めします。

スイッチで、6つのVLAN(サーバーの外部インターフェイスごとに1つ)を作成しました。

stack-3750x

インターフェイスは汎用性のためにトランキングされており、他の何かは後で見られます:

interface GigabitEthernet1/0/11 description VMSTOR1-1 switchport trunk encapsulation dot1q switchport mode trunk switchport nonegotiate flowcontrol receive desired spanning-tree portfast trunk end

サーバーの負荷を減らすには、スイッチのMTUを最大に設定する必要があります(より多くのパケット-> 1秒あたりのパケット数が少ない->中断が少ない)。 私の場合、これは9198です。

(config)

ESXiは9000を超えるMTUをサポートしていないため、まだマージンがあります。

各VLANにはアドレススペースが割り当てられました。簡単にするために、10.1のようにします。

VLAN_ID .0 / 24(たとえば、10.1.24.0 / 24)。 アドレスが不足している場合、より小さなサブネット内に維持できますが、より便利です。

各LUNは個別のiSCSIターゲットで表されるため、各共通ターゲットは「共通」クラスタアドレスで選択され、現在このターゲットにサービスを提供しているノードで発生します:10.1。

VLAN_ID .10および10.1

VLAN_ID .20

また、サーバーには管理用の永続アドレスがありますが、私の場合は10.1.0.100/24および.200(別個のVLAN内)です。

ソフトウェア

そのため、ここでは両方のサーバーに最小限の形式でDebianをインストールしますが、これについては詳しく説明しません。

パッケージアセンブリ

コンパイラとソースでサーバーが乱雑にならないように、別の仮想マシンでアセンブリを行いました。

Debianでカーネルをビルドするには、ビルドに不可欠なメタパッケージを置くだけで十分です。おそらく、他の何かを正確に覚えていません。

kernel.orgから最新のカーネル3.10をダウンロードして解凍します。

次に、安定したSCSTブランチの最新リビジョンをSVNからダウンロードし、カーネルバージョンのパッチを生成して適用します。

iscsi-scstdデーモンをビルドします。

結果の

iscsi-scstdは、サーバーに配置する必要があります(例:

/ opt / scst)次に、サーバーのカーネルを構成します。

暗号化をオンにします(必要な場合)。

SCSTおよびDRBDにこれらのオプションを含めることを忘れないでください。

CONFIG_CONNECTOR=y CONFIG_SCST=y CONFIG_SCST_DISK=y CONFIG_SCST_VDISK=y CONFIG_SCST_ISCSI=y CONFIG_SCST_LOCAL=y

これを.debパッケージの形式で収集します(このためには、fakeroot、kernel-package、debhelperを同時にインストールする必要があります)。

出力で

kernel-scst-image-3.10.27_1_amd64.debパッケージを取得します次に、DRBDのパッケージを収集します。

debian / rulesファイルを次の状態に変更します(そこには標準ファイルがありますが、カーネルモジュールは収集しません)。

Makefile.inファイルでは、SUBDIRS変数を修正し、その変数から

ドキュメントを削除し

ます 。そうしないと、パッケージはドキュメントの呪いと共に収集されません。

収集するもの:

パッケージ

drbd_8.4.4_amd64.debを

取得します

それだけです。他のものを収集する必要はなく、両方のパッケージをサーバーにコピーしてインストールする必要はありません。

サーバー構成

ネットワーク

インターフェイスは、次のように

/etc/udev/rules.d/70-persistent-net.rulesに名前が変更されました。

int1-6はスイッチに

移動し、

drbd1-4は隣接サーバーに

移動します。

/ etc / network / interfacesは非常に恐ろしい外観をしており、悪夢では夢にも思わないでしょう:

auto lo iface lo inet loopback

サーバー管理のフォールトトレランスも必要なため、ミリタリートリックを使用します。

アクティブバックアップモードでのボンディングでは、インターフェイス自体ではなく、VLANサブインターフェイスを収集します。 したがって、少なくとも1つのインターフェイスが実行されている限り、サーバーは使用可能になります。 これは冗長ですが、紫斑病はpaではありません。 また、同じインターフェイスをiSCSIトラフィックに自由に使用できます。

レプリケーションのために、

bond_drbdインターフェイスが

balance-rrモードで

作成されました。このモードでは、すべてのインターフェイスにパケットが愚かに連続して送信されます。 彼は灰色のネットワーク/ 24からアドレスを割り当てられましたが、/ 30または/ 31のようにできます ホストは2つだけです。

これによりパケットが順番通りに到着しないことがあるため、/

etc/sysctl.conf内の異常なパケットのバッファを増やします。 以下に、非常に長い間、ファイル全体を示しますが、どのオプションについて説明しませんか。 必要に応じて自分で読むことができます。

net.ipv4.tcp_reordering = 127 net.core.rmem_max = 33554432 net.core.wmem_max = 33554432 net.core.rmem_default = 16777216 net.core.wmem_default = 16777216 net.ipv4.tcp_rmem = 131072 524288 33554432 net.ipv4.tcp_wmem = 131072 524288 33554432 net.ipv4.tcp_no_metrics_save = 1 net.ipv4.tcp_window_scaling = 1 net.ipv4.tcp_timestamps = 0 net.ipv4.tcp_sack = 0 net.ipv4.tcp_dsack = 0 net.ipv4.tcp_fin_timeout = 15 net.core.netdev_max_backlog = 300000 vm.min_free_kbytes = 720896

テスト結果によると、レプリケーションインターフェイスは

3.7 Gb / sを生成しますが、これはまったく問題ありません。

マルチコアサーバーがあり、ネットワークカードとRAIDコントローラーがいくつかのキュー間で割り込みの処理を分離できるため、割り込みをカーネルにリンクするスクリプトが作成されました。

ディスク

ディスクをエクスポートする前に、それらを暗号化し、すべての消防士のマスターキーを保護します。

パスワードは頭蓋骨の内側に書き込まれ、決して忘れられないようにし、キーのバックアップは地獄に隠されるべきです。

マスターキーのバックアップセクションのパスワードを変更した後、古いパスワードを復号化できることに注意してください。

次に、復号化を簡素化するためのスクリプトが作成されました。

スクリプトは、ディスクのUUIDを使用して、

/ dev / sd *にバインドせずに、システム内のディスクを常に一意に識別します。

暗号化速度はプロセッサの周波数とコアの数に依存し、記録は読み取りよりも並列化されます。 次の簡単な方法で、サーバーが暗号化する速度を確認できます。

, ,

ご覧のとおり、速度はそれほど熱くありませんが、実際にはほとんど達成されません。 通常、ランダムアクセスが優先されます。

比較のため、

Haswellコアの新しい

Xeon E3-1270 v3での同じテストの結果:

さて、ここではもっと楽しいです。 頻度は明らかに決定的な要因です。

また、AES-NIを無効にすると、数倍遅くなります。

DRBD

レプリケーションを構成します。両端からの構成は100%同一でなければなりません。

/etc/drbd.d/global_common.conf global { usage-count no; } common { protocol B; handlers { } startup { wfc-timeout 10; } disk { c-plan-ahead 0; al-extents 6433; resync-rate 400M; disk-barrier no; disk-flushes no; disk-drain yes; } net { sndbuf-size 1024k; rcvbuf-size 1024k; max-buffers 8192;

ここで最も興味深いパラメーターはプロトコルです。それらを比較してください。

ブロックが記録された場合、記録は成功したと見なされます...

- A-ローカルディスクにアクセスし、ローカル送信バッファをヒットする

- B-ローカルディスクに、リモート受信バッファに入った

- C-ローカルおよびリモートディスクへ

最も遅い(読み取り-高遅延)と同時に信頼できるのは

Cであり、私は中間地点を選択しました。

次は、DRBDとその複製に関係するノードが動作するリソースの定義です。

/etc/drbd.d/VM_STORAGE_1.res resource VM_STORAGE_1 { device /dev/drbd0; disk /dev/mapper/VM_STORAGE_1; meta-disk internal; on vmstor1 { address 192.168.123.100:7801; } on vmstor2 { address 192.168.123.200:7801; } }

/etc/drbd.d/VM_STORAGE_2.res resource VM_STORAGE_2 { device /dev/drbd1; disk /dev/mapper/VM_STORAGE_2; meta-disk internal; on vmstor1 { address 192.168.123.100:7802; } on vmstor2 { address 192.168.123.200:7802; } }

各リソースには独自のポートがあります。

次に、DRBDリソースメタデータを初期化してアクティブにします。これは各サーバーで実行する必要があります。

次に、1つのサーバー(リソースごとに1つ持つことができます)を選択し、それがメインサーバーであり、プライマリ同期がそのサーバーから別のサーバーに移動することを決定する必要があります。

すべて、行こう、同期が始まった。

アレイのサイズとネットワーク速度に応じて、長時間または非常に長い時間がかかります。

その進行は

watch -n0.1 cat / proc / drbdコマンドで観察でき、非常に穏やかで哲学的です。

原則として、デバイスはすでに同期プロセスで使用できますが、リラックスすることをお勧めします:)

最初の部分の終わり

一枚については、それで十分だと思います。 そして、非常に多くの情報がすでに吸収されています。

第2部では、この共有で動作するようにESXiクラスターマネージャーとホストを構成する方法について説明します。