親愛なる読者の皆さん、こんにちは!

今年のMicrosoft

// Buildカンファレンスでは、多くの技術的な発表と技術革新が発表されただけでなく、イベント自体でかなりの興味深い機会がありました。

HoloLensとHolographic Academy、Xbox One開発者モード、およびImagine Cup USAファイナルの興味深い技術プロジェクトの詳細-この記事でこれについてお伝えしたいと思います。

HoloLensとNASA

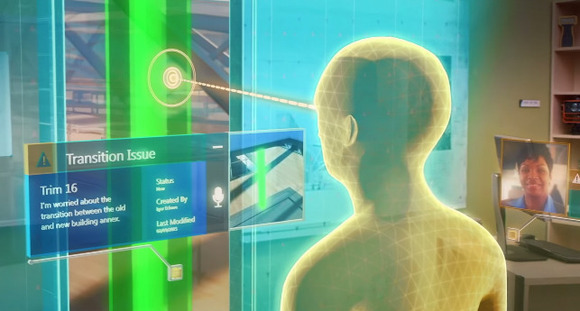

MicrosoftはNASAと共同で、「Destination:MARS」というHoloLensデバイスを使用して火星を調査する共同プロジェクトを導入しました。

この会議には、火星への着陸のデモを行う大きなスタンドがあり、デモのチケットを受け取った各訪問者は、火星探検家を装って感じることができました。

ちょっとした背景このプロジェクトのルーツは、火星探査機「Suriosity」が火星に着陸し、「赤い惑星」の探索を開始した2012年に遡ります。

数年が経ち、NASAには、火星の表面と大気のさまざまなデータ、画像、分析があります。

好奇心とその前身から得られたすべての材料は、火星の正確な表面を再現するために使用されました。 デモ「Destination:MARS」で得られるのは彼女です。

NASA自体では、HoloLensのすべての機能とツールを使用して、火星を研究し、「赤い惑星」での好奇心のルートと活動を計画しています。 これらはすべての開発者がコンピューターにインストールし、エミュレーターでホログラムを作成する作業を開始できるのと同じ

開発ツールです。

部屋に入るのは約25平方メートルです。 m。、すべての参加者は部屋の周りに配置され、短い紹介の後、火星の表面の3Dモデルに分類されます。 デモでは、地球上に立っているときに「赤い惑星」にあるものを感じます。

歩き回ったり、周りのすべてのオブジェクトを調べたり、Suriosityローバー自体を見ることができます。

これと並行して、NASAの従業員の3Dモデルが表示され、プロジェクト全体の歴史とその周辺で何が起こっているのかを説明します。

HoloLensの強力なプロセッサにより、あらゆる品質のモデルを使用できます。ヘルメットでは、モデルは作成されたとおりに表示されます。

仕様HoloLens- 2プロセッサ:Microsoft Holographic Processing Unit(HPU)およびIntel 32ビットプロセッサ

- RAM:2 GB

- フラッシュメモリ:64 GB

- Bluetooth( Bluetooth Clickerを含む )、Micro USBコネクタをサポート

- 慣性測定ユニット、周囲光センサー、および4台の一致したカメラ。 深度測定カメラ(HoloLens空間を認識するため)。

- ビデオ録画および写真撮影用の2メガピクセルHDカメラ。

- デバイス内の4つのマイク。ユーザーの音声コマンドを録音できます。

- 重量:579 g以下

- バッテリー寿命:2〜3時間のアクティブな使用、2週間のスタンバイ時間

この

サイトでは、HoloLensを構成するすべての部品を視覚化した、より詳細な画像を提供しています。

ホログラフィックアカデミー-ホログラムデザイントレーニングの進化

昨年、// Build 2015で、HoloLens-Holographic Academyの開発アカデミーが最初に発表されました。 これは、Microsoft HoloLensのゼロからの4.5時間の興味深いホログラムトレーニングです。

2015年のすべての訪問者の3日間すべて 運が私に微笑んだことを含めて、わずか180人しか乗ることができませんでした。

アカデミーでは、ホログラムの開発方法を段階的に教えられ、「個人用ホログラム」を正確に使用した経験が研究されました。

アカデミーを始める前に、誰もが写真とビデオ素材を使用する許可に署名するように求められました。 アカデミーでは、カメラが隅々に立っていました。 すべてのデバイスを金庫に引き渡し、金属探知機のフレームを通過して、ポケットに何か残っているかどうかをさらにスキャンしました。

次に重要なプロセスがあります。目の間の距離と視界の範囲を測定するからです。 各HoloLensデバイスは、個人用に個別にプログラム可能です。

アカデミーには次の段階がありました。

- Unityの短期コースと環境設定

Unityゲームエンジンは、HoloLensホログラムの作成に使用されます。 通常のシーンをホログラムの作成に適したシーンに変えるには、カメラとライトの設定を特定の方法で変更する必要があります。

HoloLensの開発は非常に簡単です。各関数の実装は、C#で文字通り数行かかります。

開発ツールをインストールすることで、HoloLensの開発を開始できます 。

特別なHoloLens SDKはありません。すべてのホログラムツールは、Visual Studio 2015 Update 2およびWindows 10 SDK(バージョン1511以降)に既に組み込まれています。

必要なもの:

次に、HoloLensのUnityプロジェクトを構成する必要があります。

構成シーン構成:- 階層で、メインカメラを選択します

- Inspectorパネルで、変換位置の値を0、0、0に設定します。これにより、ユーザーの頭の位置がUnityレベルの先頭になります

- クリアフラグを単色に変更

- 背景色をRGBA 0,0,0,0に変更します。 注:HoloLensでは、黒は透明としてレンダリングされます。

- クリッピングプレーンの変更-HoloLensのニア値は0.85(メートル)にすることをお勧めします。

プロジェクト構成:- [プレーヤーの設定]> [Windowsストア]> [公開設定]> [機能]で、適切な機能を選択して、必要なAPIをアクティブにする必要があります。

| 能力 | API |

| ウェブカメラ | PhotoCaptureおよびVideoCapture |

| SpatialPerception | SurfaceObserverおよびSpatialAnchor |

| マイク | VideoCapture、DictationRecognizer、GrammarRecognizer、およびKeywordRecognizer |

| picturesLibrary / videosLibrary / musicLibrary | PhotoCaptureおよびVideoCapture |

- ユニバーサルWindowsプラットフォームアプリとしてエクスポートするようにUnityプロジェクトを設定する必要があります

- [ファイル]> [ビルド設定]を選択します...

- プラットフォームのリストからWindowsストアを選択します

- SDK値をUniversal 10に設定します

- ビルドタイプをXAMLに設定

- HoloLensでは、パフォーマンスが非常に重要なので、品質設定を「高パフォーマンス」に設定する必要があります

- [編集]> [プロジェクト設定]> [品質]を選択します

- Windowsストアのロゴの横にあるドロップダウンメニューを選択し、[最速]を選択します。

- アプリケーションは、2Dビューではなくホログラフィックビューを使用する必要があります

- ビルド設定...ウィンドウから、プレイヤー設定を開きます...

- [Windowsストア]タブの設定を選択します

- [その他の設定]グループを展開します

- [レンダリング]セクションで、[サポートされているバーチャルリアリティ]チェックボックスをオンにして、新しいバーチャルリアリティデバイスリストを追加し、「Windows Holographic」がサポートされているデバイスのリストにあることを確認します。

- ホログラム相互作用ジェスチャーの概要

2015年、HoloLensにはキットにBluetoothクリッカーが含まれていませんでした。ボタンをクリックするだけで、クリックして他のジェスチャーを作成できます。

HoloLensには、ホログラムを操作できるいくつかの標準ジェスチャーがあります。

プレス\リリース(プレス\リリース)このジェスチャは、インタラクションをアクティブにするか、ホログラムを選択するための基本です。

そのためには、手のひらの前で手を前に上げ、握りこぶしを握り、人差し指を上げる必要があります。 次に、それを下げて(押す)、もう一度上げます(リリース)-同様に、タブレットをタップします。これだけが空中にあります。

開花(ブルーム)スタートメニューに戻ることができる特別なシステムジェスチャ(キーボードの[スタート]ボタンまたはジョイスティックの[Xbox]ボタンを押すのと同じ)

そのためには、手のひらを上に伸ばし、すべての指を一緒に握りしめて(握りこぶしができます)、完全に元に戻します。

アプリケーションでこのジェスチャーに対する反応をプログラムできないことに注意してください。 それは全身です。

次のより複雑なジェスチャは、動きと標準のジェスチャの組み合わせを提供できます。

ホールドプレス(プレス)のジェスチャーを押したままにすると(リリースしない)、そのようなジェスチャーはシステムによってホールド(ホールド)として認識されます。 オブジェクトを発生させるなど、マイナーアクションに使用できます。

操作3Dワールドでのその後の手の動きでクリックします。

これらのジェスチャを使用して、手の動きに対して1対1の反応が必要な場合に、ホログラムを移動、拡大縮小、および回転させることができます。

ナビゲーションこのジェスチャを使用するには、「クリック」ジェスチャを作成し、押したポイントを中心とした正規化された3Dキューブ内で手を動かす必要があります。

これらのジェスチャーは仮想ジョイスティックのようなもので、放射状メニューなどのUIウィジェットをナビゲートするために使用できます。

- Unityで最初のホログラムを作成(「折り紙」)

現在の段階では、必要なオブジェクトの配置とカメラの接続のみが存在していました。 ここで、新聞の折り畳み(スクリーンショットの右側のボール)でさえ本物のように見えることに注意してください。 あなたはそれを調べ、新聞のすべての手紙、すべての数字を見ることができます。

マイクロソフトは、昨年のリソースを既に公開しています。エミュレータを使用して、プロジェクトをダウンロードして自分で作成し直すことができます。

- カーソルとジェスチャーの追加

閲覧しているテーマを理解しやすくするために、Microsoftは特別なカーソルを開発しました。 カーソルは特別な資産を使用して配置され、その操作のために、コードに「人」の「頭」から(「プレーヤー」のメインカメラからのラインに沿って)ビームキャストを登録する必要があります。

Unityは、低レベルのアクセス(座標と速度に関する純粋な情報)と、より複雑なジェスチャーイベント(タップ、ダブルタップ、ホールド、操作、ナビゲーションなど)を提供する高レベルのジェスチャーレコグナイザーの両方を提供します。

ジェスチャー入力

名前空間: UnityEngine.VR.WSA.Input

タイプ: GestureRecognizer、GestureSettings、InteractionSourceKind

高レベルのジェスチャーは、入力ソースを使用して生成されます。 各ジェスチャーイベントは、イベントのアクティブ化中のヘッドビーム(上記)の位置決めを含む、入力用のSourceKindを提供します。 一部のイベントは、追加のコンテキスト情報を提供します。

Gesture Recognizerを使用してジェスチャをキャプチャするには、わずか数ステップが必要です。

新しいジェスチャ認識ツールの作成GestureRecognizerを使用するには、GestureRecognizerを作成する必要があります。

GestureRecognizer recognizer = new GestureRecognizer();

監視するジェスチャの表示SetRecognizableGestures()を使用して関心のあるジェスチャーを指定します。

recognizer.SetRecognizableGestures(GestureSettings.Tap | GestureSettings.Hold);

これらのジェスチャーのイベントサブスクリプションこれらのジェスチャーのイベントをサブスクライブしてください。

recognizer.TappedEvent += MyTapEventHandler; recognizer.HoldEvent += MyHoldEventHandler;

ジェスチャー開始デフォルトでは、GestureRecognizerはStartCapturingGestures()が呼び出されるまで入力を監視しません。 StopCapturingGestures()の処理フレームの前に入力が行われた場合、StopCapturingGestures()を呼び出した後にジェスチャイベントが生成される可能性があります。 そのため、プレイヤーが現在見ているオブジェクトに応じて、ジェスチャーの監視を開始および停止することが常に望ましいのです。

recognizer.StartCapturingGestures();

ジェスチャー停止 recognizer.StopCapturingGestures();

削除するGestureRecognizerオブジェクトを削除する前に、署名済みイベントの登録を忘れないでください。

void OnDestroy() { recognizer.TappedEvent -= MyTapEventHandler; recognizer.HoldEvent -= MyHoldEventHandler; }

インタラクション入力

名前空間: UnityEngine.VR.WSA.Input

タイプ: InteractionManager、SourceState、Source、InteractionSourceProperties、InteractionSourceKind、InteractionSourceLocation

前述のように、低レベルの入力は、世界の位置座標や速度など、入力オブジェクトに関する詳細情報を取得する機会を提供します。

相互作用イベントの処理を停止する方法必要です:

InteractionManager.SourcePressed -= InteractionManager_SourcePressed;

入力ソース変更イベント- 検出-検出(アクティブになった)

- 失われた-失われた(非アクティブになった)

- 更新-変更(状態の移動または変更)

- が押されている-押されている(タップ、ボタンを押す、または選択を開始)

- リリース済み-リリース済み(タップの終了、ボタンのリリース、または選択の終了)

例 using UnityEngine.VR.WSA.Input; void Start () { InteractionManager.SourceDetected += InteractionManager_SourceDetected; InteractionManager.SourceUpdated += InteractionManager_SourceUpdated; InteractionManager.SourceLost += InteractionManager_SourceLost; InteractionManager.SourcePressed += InteractionManager_SourcePressed; InteractionManager.SourceReleased += InteractionManager_SourceReleased; } void OnDestroy() { InteractionManager.SourceDetected -= InteractionManager_SourceDetected; InteractionManager.SourceUpdated -= InteractionManager_SourceUpdated; InteractionManager.SourceLost -= InteractionManager_SourceLost; InteractionManager.SourcePressed -= InteractionManager_SourcePressed; InteractionManager.SourceReleased -= InteractionManager_SourceReleased; } void InteractionManager_SourceDetected(SourceState state) {

また、小さなコードの助けを借りて、新聞の折り畳みや折り紙の作品との相互作用を追加しました。 オブジェクトを見てから「クリック」すると、次のことが起こりました。

オブジェクトは仮想の紙飛行機に落ち、実際のテーブルに転がり落ち、このテーブルに転がり、実際の床に落ちて、動きのすべての物理学を考慮してさらに回転し続けました! また、最後に、オブジェクトのパスをブロックすると、オブジェクトが足にぶつかる可能性があります。

- 音と音楽を追加する

HoloLensには、完全な3Dサウンドを聞くことができる内蔵の振動ステレオヘッドフォンがあります。 この事実は、信頼できる媒体の音を再現するための無限の可能性を開きます。

結局のところ、オブジェクトが可視範囲外にあるとき、私たちの周りで何が起こっているのかを知覚できる方法の1つは音です。 最高の複合現実体験のために、HoloLensオーディオエンジンは、方向、距離、および環境モデリングを使用して3Dサウンドをシミュレートすることでサウンドを提供します。

プロジェクトに空間サウンドを追加する方法:

Unityで空間サウンドを有効にするUnityでは、特別なオーディオプラグイン(Spatializer)を使用して空間サウンドを有効にします。 プラグインファイルは既にUnityに組み込まれているので、編集>オーディオ> Spatializerに移動して、Microsoft HRTFを有効にするだけです。

以上で、UnityプロジェクトでSpatial Soundを使用できるようになりました。

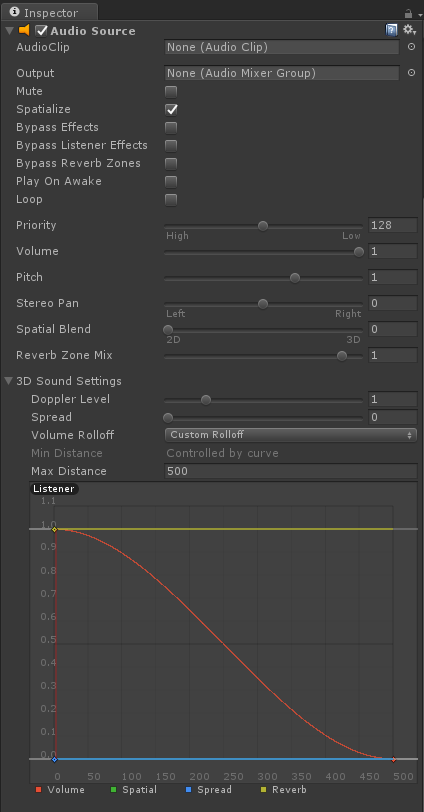

Unityで空間サウンドを使用する次の手順は、Spatial Sound用にオーディオソースコンポーネントを構成するのに役立ちます。

- [階層]パネルで、オーディオソースが接続されているゲームオブジェクトを選択します。

- インスペクターの[オーディオソース]コンポーネントの下で:

- [空間化]オプションの横にあるチェックボックスをオンにします。

- Spatial Blendを3D(数値1)に設定します。

- 最良の結果を得るには、3Dサウンド設定を開き、ボリュームロールオフをカスタムロールオフに設定します。

以上で、UnityプロジェクトでSpartial Soundを使用できるようになりました。

サラウンドサウンド設定Microsoft Spatial Soundプラグインは、各ベースオーディオソースで設定できる多くの追加パラメーターを提供し、オーディオシミュレーションの追加設定を有効にします。

最小ゲイン最小ゲインは、任意の距離で適用可能です(-96〜+12デシベル)。 初期値:-96デシベル。

最大ゲイン最大ゲインは、どの距離でも適用可能です(-96〜+12デシベル)。 初期値:+12デシベル。

ユニティゲイン距離ゲインが0デシベルになる距離(メートル単位(0.05から無限大))。 初期値:1メートル。

部屋の大きさプラグインを使用してシミュレートできる部屋のサイズ。 部屋のおおよそのサイズは、小さい(事務室から小さな会議室まで)、中程度(大きい会議室)、大きい(聴衆)です。 また、値をnoneに設定して、外部環境(建物の外部)をシミュレートすることもできます。 デフォルトでは、部屋は狭いです。

例 The HoloToolkit for Unity provides a static class that makes setting the Spatial Sound settings easy. This class can be found in the HoloToolkit\SpatialSound folder and can be called from any script in your project. It is recommended that you set these parameters on each Audio Source component in your project. The following example shows selecting the medium room size for an attached Audio Source. AudioSource audioSource = gameObject.GetComponent<AudioSource>() if (audioSource != null) { SpatialSoundSettings.SetRoomSize(audioSource, SpatialMappingRoomSizes.Medium); } </source lang> <b> Unity</b> . SetHRTF.cs, HRTF AudioSource. . <source lang="cs"> using UnityEngine; using System.Collections; public class SetHRTF : MonoBehaviour { public enum ROOMSIZE { Small, Medium, Large, None }; public ROOMSIZE room = ROOMSIZE.Small;

- 音声制御を追加する

音声は、HoloLensの3つの入力方法の1つです。 HoloLensでは、Cortanaのすべての機能、完全な音声制御を使用できます。 あなたはただホログラムを見てコマンドを言うだけです-これが主な原則です。

音声入力にはいくつかのオプションがあります。

選択コマンドアプリケーションに音声制御のサポートを追加していない場合でも、ユーザーは「select」コマンドを使用してホログラムをアクティブにできます。 このコマンドは、HoloLensを使用していつでも使用でき、最小限のエネルギーを消費します。

コルタナHoloLensの特別なコマンドでCortanaを使用できます(コマンドは「Hey、Cortana」という言葉の後に読みます):

- 家に帰る-スタートメニューを呼び出す

- 起動-app-

- 写真を撮る

- 録音を開始

- 記録を停止

- 明るさを上げる

- 輝度を下げる

- 音量を上げる

- 音量を下げる

- デバイスをシャットダウンします

- デバイスを再起動します

- デバイスを再起動します

- 寝る

- 今何時?

- 私のIPアドレスは何ですか?

- ネットワークに接続していますか?

- 聞いていますか?

- バッテリーはどれくらい残っていますか?

- 電話-contact-(HoloSkypeが必要)

- ウェブ検索

ディクテーションテキストを入力する場合、口述は空中タパスよりもはるかに効果的です。 ホログラフィックキーボードがアクティブな場合、マイクアイコンをクリックしてディクテーションモードに切り替えることができます。

これを行うには、HoloLensが何らかの音を期待するように数行を登録するだけで十分で、英語で応答する必要があるコマンドと反応を入力します。

音声入力を実装する方法を分析します。

マイクを有効にするUnity設定ヘッド入力を有効にするには、アプリケーションの「マイク」機能を宣言する必要があります。

- Unityエディターで、「編集」>「プロジェクト設定」>「プレーヤー」ページに移動します

- [Windowsストア]タブをクリックします

- [公開設定]> [機能]で、[マイク]のチェックボックスをオンにします。

フレーズ認識フレーズを認識するには、KeywordRecognizerとGrammarRecognizerの2つの方法があります。 どのフレーズをリッスンするかを選択し、OnPhraseRecognizedイベントを処理し、フレーズのアクションを追加する必要があります。

- KeywordRecognizer

つなぐ

using UnityEngine.Windows.Speech; using System.Collections.Generic; using System.Linq;

次に、クラスにいくつかのフィールドを追加して、認識エンジンと辞書のキーワード->アクションを保存します。

KeywordRecognizer keywordRecognizer; Dictionary<string, System.Action> keywords = new Dictionary<string, System.Action>();

次に、キーワードを辞書に追加します(たとえば、Start()メソッド内)。 この例では、キーワード「アクティベート」を追加します。

KeywordRecognizerを作成し、認識したいものに設定します。

keywordRecognizer = new KeywordRecognizer(keywords.Keys.ToArray());

OnPhraseRecognizedイベントをサブスクライブします。

keywordRecognizer.OnPhraseRecognized += KeywordRecognizer_OnPhraseRecognized;

例:

private void KeywordRecognizer_OnPhraseRecognized(PhraseRecognizedEventArgs args) { System.Action keywordAction;

最後に、認識を実行します。

keywordRecognizer.Start();

- GrammarRecognizer

GrammarRecognizerは、 SRGSを使用して独自の認識文法を設定する場合を対象としています。

SRGS文法を作成し、それをStreamingAssetsフォルダー内のプロジェクトに配置した後:

<PROJECT_ROOT>/Assets/StreamingAssets/SRGS/myGrammar.xml

GrammarRecognizerを作成し、SRGSファイルを渡します:

private GrammarRecognizer grammarRecognizer; grammarRecognizer = new GrammarRecognizer(Application.streamingDataPath + "/SRGS/myGrammar.xml");

OnPhraseRecognizedイベントにサブスクライブします。

grammarRecognizer.OnPhraseRecognized += grammarRecognizer_OnPhraseRecognized;

SRGS文法に従って情報を受け取り、問題なく処理できます。 必要な情報のほとんどは、semanticMeanings配列で提供されます。

private void Grammar_OnPhraseRecognized(PhraseRecognizedEventArgs args) { SemanticMeaning[] meanings = args.semanticMeanings;

認識を開始します。

grammarRecognizer.Start();

ディクテーションDictationRecognizerを使用する場合、アプリケーションは任意の単語を予期し、後続のアクションでテキストに変換できます。

DictationRecognizerを実装するには、わずか数ステップが必要です。

- DictationRecognizerを作成する

dictationRecognizer = new DictationRecognizer();

- ディクテーションイベントの処理

合計4つのディクテーションイベントがあり、サブスクライブして追加のアクションを処理できます。

- ディクテーション結果

このイベントは、ユーザーが音声を一時停止したとき、たとえば文の最後でトリガーされます。 これにより、完全に認識された文字列が返されます。

まず、DictationResultイベントにサブスクライブします。

dictationRecognizer.DictationResult += DictationRecognizer_DictationResult;

次に、DictationResultの呼び出しを処理します。

private void DictationRecognizer_DictationResult(string text, ConfidenceLevel confidence) {

- ディクテーション

このイベントは、ユーザーのスピーチ全体にわたってアクティブです。 認識エンジンは音声を聞くため、聞いた内容のテキストを返します。

まず、DictationHypothesisイベントにサブスクライブします。

dictationRecognizer.DictationHypothesis += DictationRecognizer_DictationHypothesis;

次に、DictationHypothesisの呼び出しを処理します。

private void DictationRecognizer_DictationHypothesis(string text) {

- ディクテーション完了

このイベントは、Stop()メソッドの呼び出し、タイムアウト、またはその他のエラーなど、認識エンジンが停止したときに発生します。

最初に、DictationCompleteイベントにサブスクライブします。

dictationRecognizer.DictationComplete += DictationRecognizer_DictationComplete;

次に、DictationComplete呼び出しを処理します。

private void DictationRecognizer_DictationComplete(DictationCompletionCause cause) {

- DictationError

このイベントは、エラーが発生したときに発生します。

まず、DictationErrorイベントにサブスクライブします。

dictationRecognizer.DictationError += DictationRecognizer_DictationError;

次に、DictationError呼び出しを処理します。

private void DictationRecognizer_DictationError(string error, int hresult) {

- DictationRecognizerの実行

dictationRecognizer.Start();

リゾルバーをシャットダウンするには、イベントのサブスクライブを解除し、Dispose()メソッドを使用する必要があります。

dictationRecognizer.DictationResult -= DictationRecognizer_DictationResult; dictationRecognizer.DictationComplete -= DictationRecognizer_DictationComplete ; dictationRecognizer.DictationHypothesis -= DictationRecognizer_DictationHypothesis ; dictationRecognizer.DictationError -= DictationRecognizer_DictationError ; dictationRecognizer.Dispose();

この場合、アカデミーでは、「ドロップする」という言葉の後に、見ている被写体が表面に落ちるようにプログラムしました。 (たとえば、新聞のロール)。 上記の例では、この単語は「アクティベート」でした。

- 「マトリックスに飛び込む」またはワイヤーフレームモードを有効にする

おそらく、それがすべて行われた後、HoloLensが自分自身をどのように見ているのか知りたいですか? 世界との交流にどのように役立ちますか?

この時点で、ワイヤーフレームモードをオンにして、HoloLensをオンにしました。 言葉はもう必要ありませんでした-それはすべて非常に刺激的でした。

想像してみてください。彼は世界のグリッドを構築し、各オブジェクトは(その視野角の値によって)文字通りミリ秒単位で瞬時に構築されます。 これはとても魅力的です!

それから、アカデミーホールの反対側でも、折り紙テーブルをあらゆる表面に移動できるようにしました。

- 「そして別の世界が現実になったら?」

終わりは同じくらい興味深いものでした。私たちは床に特別な資産、大きなブラックホールを置くように言われました。 打ち上げ時に失敗し、別の世界への通路が形成されました。飛行機、木、水、土地、そして素晴らしい雰囲気です。

私はこの世界に触れたいと思っていますが、悲しいかな、本当の性別はそうすることを難しくしています。

その後、彼らはこの資産を誰かの頭に置くことを提案しました。 その後、私たちが穴で見た全世界が私たちの現実の世界に移ります。 すでにあなたの周りを紙飛行機が木々の周りを飛んで過ぎ、水をはねかけているのを見て、あなたは全世界と対話することができます。

各段階の後、完了した作業の「成果」が与えられ、開発学習プロセスにさらに前向きな効果がもたらされました。

アカデミーのビデオ:

アカデミーでは、各参加者(彼の同意を得て)がインタビューされ、感情、HoloLens用に開発したいプロジェクト、および他の多くの質問について質問されました。 そして、HoloLensのさらなる研究に参加するためにサインアップできます。

アカデミーの終わりに、すべての参加者は「ホログラフィック開発者」のステータスを受け取ります。

今年は何ですか?

// Build 2016では、ホログラフィックアカデミーも開催されましたが、これは報道関係者および

HoloLens Development Editionデバイスを事前注文したメンバーのみを対象としています。 これまでのところ、先行予約プログラムは米国およびカナダの開発者のみが利用でき、デバイス自体のコストは3000ドルです。

昨年の主なテーマが「個人用ホログラム」であった場合、今回は「一般的なホログラム」、つまり すべての参加者が同時に対話できるようになります。 誰もが単一のホログラムを見、それと対話します。

マイクロソフトは、参加者に段階的にホログラムを作成し、約4時間それらと対話する方法も教えました。

その結果、単一の世界にいるすべての参加者が火の玉を介して敵を破壊し、すべてが同じホログラムと相互作用するゲームになりました。

前回同様、これはもう1つのユニークな体験であるだけでなく、Microsoftにとっても有益な研究です。

ホログラフィックアカデミーのテーマの結論として、すべてを構成し、独自のホログラムを作成してエミュレーターで表示することを強くお勧めします。 また、この

リンクを介して同様のアカデミーパスを利用します。

Xbox One開発者モード

ご存知のように、MicrosoftはついにXbox One開発者モードを導入しました。これにより、Xbox OneでUWPアプリケーション\ゲームをテストできます。

この機能はプレビューステージにあります。インストールする場合は、特別なDev Mode Activationアプリケーションをダウンロードする必要があります。

// Build 2016カンファレンスでは、The Garageのブース全体で、この方法でDevKitに変換されたコンソールを試すことができました。

Developer Previewが

Developer Previewが提供するもの:

- 448 MB RAMへのアクセス(8 GBのXbox Oneメモリから)。 プレビューを終了すると、開発者は1 GBのRAMにアクセスできます

- 1.75 GHzで2つのCPUコアへのアクセス。 プレビューを終了すると、開発者は4つのCPUコアにアクセスできます

- GPUの45%へのアクセス。 プレビューを終了した後、この数字は変わりません

- Xbox OneのUWPは現在、DirectX 11機能レベル10のみをサポートしています。DirectX12はまだサポートされていません。

同時に、Xbox OneでUWPアプリケーション/ゲームを開発およびテストするための本格的な機会が得られます。 ただし、1つの機能があります。XboxOneでゲームをリリースするか、コンソールのすべての機能を使用するには、

ID @ Xboxプログラムに登録する必要があります。

開発モードを有効にする方法

アクティブ化する前に、まず、小売モードのコンソールがあることを確認する必要があります。 残念ながら、2つのプレビュープログラムに同時に参加することはできません。

Xbox Oneプレビュープログラムを使用している場合は、Xboxプレビューダッシュボード->登録アプリケーションを使用して、プレビュープログラムを終了する必要があります。

このプロセスは遅れる場合があります プレビューの更新はリリース段階に進み、その後小売モードに切り替わります。

それでは、

開発モードに

進みましょう。

- Xbox Oneストアを開き、Dev Mode Activationアプリを見つけます

- アプリケーションをダウンロードして、それに入る

- 次に、マニュアル全体を注意深く読み、準備ができたら、[次へ]と[次へ]をクリックします

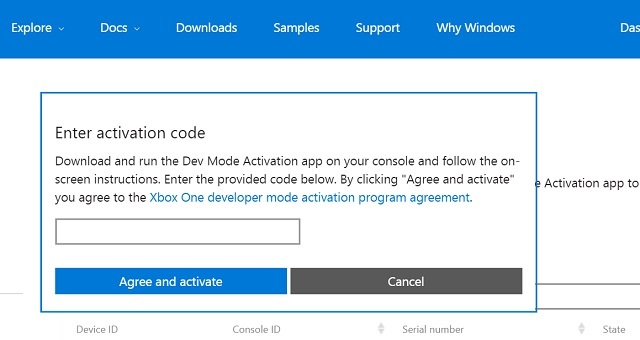

- 特別なコードが表示されます:

developer.microsoft.com/xboxactivateにアクセスして、Dev Centerアカウントにログインします。

- このページでコンソールから受け取ったコードを入力し、「同意して有効化」をクリックします。 Devモードで少数のコンソールのみを登録する機会があることに注意してください。

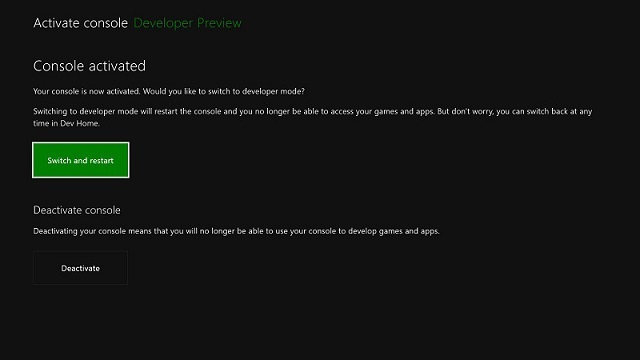

コードを入力すると、Xbox Oneがアクティベーションプロセスを開始し、その後コンソールが必要なソフトウェアのインストールを開始します。

[切り替えと再起動]をクリックします。

PCには、以下をインストールする必要があります。

- Visual Studio 2015 Update 2 。 ユニバーサルWindowsアプリ開発ツールの横にあるチェックボックスを必ずオンにしてください。

- Windows 10 SDKプレビュービルド14295以降。 Windows Insider Programを使用して入手できます。

ファイナルイマジンカップアメリカ

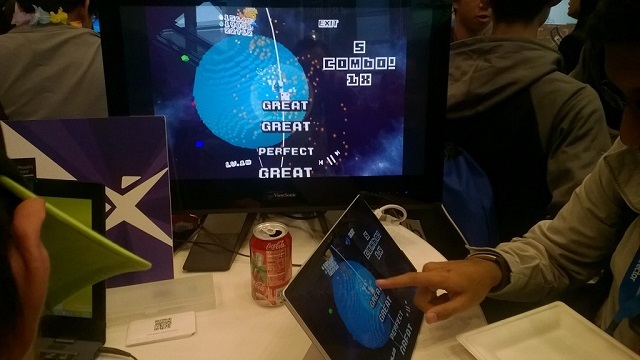

今年、カンファレンスは、学生のためのImagine Cupテクノロジーコンペティションのアメリカ決勝を開催しました。これに先立ち、地域の決勝戦が米国の都市で行われ、そこから選択されたプロジェクトが米国の決勝戦に参加しました。参加者は、4月29日の夕方にレンタルレストランでの挨拶、サティヤナンデラとのミーティング、他の日のクールなスピーカーによるマスタークラスから始まる非常に豊富なプログラムを実施しました。「心」の中でプロジェクトのショーで終わる//ビルド、ピッチ、授賞式。カンファレンスでの展示中に、いくつかのImagine Cupプロジェクトを研究することができました。カテゴリ「ゲーム」:

- “Nova” Nova – , . , .

. : Fire, Water, Wood, Number, Capacity.

C Unity Windows .

プロジェクトサイト

- “Spire of the Sullen” Spite — 2.5D . . : , , .

Trine, . , .

C Unity Windows .

プロジェクトサイト

- “Sundown” Mild Beast Games — , . – , , (.. ).

, . , .

C Unity Windows .

プロジェクトサイト

- “Gibraltar” “Grim Goblin” – , . , , . , .

“Advance Wars”. , .

C Unity Windows .

プロジェクトサイト

- Microsoft Student Partners //Build . 2 : SnakEscape — , ! ;

Lost Story: The last days of Earth — - Half-Life, , Half-Life Half-Life 2.

“ ”:

- “BEST Police Training simulator” “BoloVR” – VR - . , , .

プロジェクトサイト

“”:

- “Tactile” “Tactile” – . : '' .

, Computer Vision API Microsoft Project Oxford. API , Python.

Arduino, Arduino , .

, . , .

'' .

– , //Build , . , .

プロジェクトサイト

- “REST” “No_Sleep”

REST — Restoring Ecosystems Services Tool. , , . , .

プロジェクトサイト

最終日全体では、裁判官の前でプロジェクトのプレゼンテーションが行われました-業界の代表者。一日の終わりには、受賞者の名前だけでなく、受賞者が再び彼らのプロジェクトについて完全に話し合い、実際にそれを示した授賞式がありました。 勝者HealthXでは、この技術は眼科クリニックとその患者向けの完全なソリューションであり、一般に「レイジーアイ」として知られる弱視の診断と治療を目的としています。弱視は、子供の視力喪失の最も一般的な原因です。各優勝チームは賞金として4000ドルを受け取り、国際準決勝に進みました。そこでは、各国のプロジェクトが1つ決定され、イマジンカップの国際決勝戦に進みます。ロシアのイマジンカップ決勝戦が4月23日にモスクワのデジタル10月に開催されることは注目に値します。

勝者HealthXでは、この技術は眼科クリニックとその患者向けの完全なソリューションであり、一般に「レイジーアイ」として知られる弱視の診断と治療を目的としています。弱視は、子供の視力喪失の最も一般的な原因です。各優勝チームは賞金として4000ドルを受け取り、国際準決勝に進みました。そこでは、各国のプロジェクトが1つ決定され、イマジンカップの国際決勝戦に進みます。ロシアのイマジンカップ決勝戦が4月23日にモスクワのデジタル10月に開催されることは注目に値します。ご清聴ありがとうございました!

質問がある場合、または何かをもっと詳しく知りたい場合は、必ず書いてください、私はいつも答えます。 じゃあね!