はじめに

タスクは私のために設定されました-VMware Virtual SAN 6.2クラスターを展開して、パフォーマンスをテストし、VMwareハイパーコンバージドソフトウェアストレージの機能、機能、および動作原理を分析します。

さらに、作成されたテストベンチは、次のような分散ストレージシステムのテスト方法の開発とテストのためのプラットフォームになる必要があります。 ハイパーコンバージェンスインフラストラクチャ(HCI)用。

テストの結果と彼の方法論の説明は、この記事には含まれません。おそらく、別の出版物がこれに当てられます。

この記事は、VMware Virtual SAN 6.2クラスターの初めての展開に直面している専門家に役立ちます。 クラスターを上げるときに遭遇する可能性のある落とし穴を指摘しようとしました。これにより、それらを回避する時間と神経が大幅に削減されます。

テストベンチの説明

鉄次の構成の4つの同一ホスト:

- プラットフォーム-AIC SB302-LB(3U 16ベイストレージサーバー、vSphere 6.2の認定なし)

- プロセッサー-Intel®Xeon®CPU E5-2620 v4 @ 2.10GHz-8コア、有効なハイパースレッディング-2個

- RAM-128 GB

- NVMeフラッシュ-HGST Ultrastar SN150 HUSPR3216AHP301、1.6 TB PCIe-2個(Virtual SAN 6.2で認定、オールフラッシュのみ、HGSTによるとハイブリッドでも認定)

- HDD-HGST Ultrastar 7K6000 HUS726020AL5214 2TB 7200 rpm SAS 12Gb / s-8pcs(Virtual SAN 6.2については認定されておらず、6.5のみ)

- ブータブルメディア-60GB SSD

- ディスクコントローラー-LSI Logic Fusion-MPT 12GSAS SAS3008 PCI-Express(vSphere 6.2で認定されていますが、Virtual SAN 6.2で認定されていません)

- 2つの1GbEポート

- 2 IB 40 Gb / sポート-HCA Mellanox ConnectX-2 / IPoIBモードのConnectX-3

Mallanox SB7790 IBスイッチ

ソフトウェア:VMware vSphere 6.2vCenter Server Appliance 6.0.0.20100

ESXi 6.0.0.4600944

IPoIBモード操作用のVMware用Mallanox ConnectX-3ドライバーバージョン:MLNX-OFED-ESX-2.4.0.0-10EM-600.0.0.2494585

Virtual SANクラスタの説明vSphereトライアルライセンス-フルスタッフィング

ホストの1つの専用ローカルブート可能SSDにVMとしてデプロイされたvCenter Server Appliance

4つのホストのHAクラスター、その上にデプロイされたVirtual SAN(vSAN)クラスター

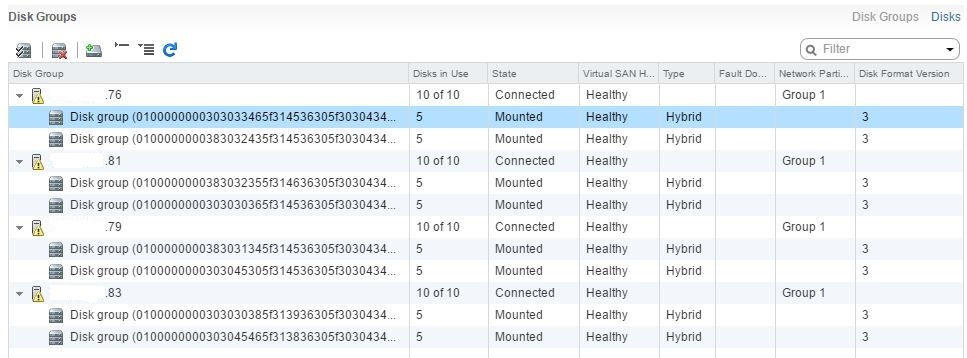

Virtual SANは、vSphereクラスターの4つのノードのすべてのメディア(ブートSSDを除く)を使用します。8つの同一のディスクグループ(DG)-ホストごとに2つ。 各DGには、キャッシュ用に1つのNVMeフラッシュと容量用に4つのHDDが含まれます。 総容量57.64TBのハイブリッドストレージを取得-1.82TBの32容量ドライブ(実際の2TBディスク容量)

ESXi、ドライバー、vCenter、およびパッチをインストールします

準備と初期展開

最初に、既存のサーバーハードウェアとVMware vSphereおよびVirtual SANソフトウェアとの互換性を確認する必要があります。 ハードウェアと目的のバージョンのvSphereとの互換性は、Virtual SANとの互換性を保証するものではないことに注意してください。 したがって、機器とvSAN(Virtual SAN)の互換性をすぐに確認する必要があります。 これを行うには、

VMware互換性ガイドリソースにアクセスし、[お探しのもの]フィールドでVirtual SANを選択し、vSAN(Virtual SAN Ready Node)での動作が認定された既製ソリューションの検索および基本構成の多くの機会を得ます。

これは、新しいVMware vSANクラスターを展開し、追加のトラブルなしに、ボリュームと負荷のために、お気に入りのベンダー認定VMwareから既製のホストを選択する場合に役立ちます。 HCIを構築するために事前にテストされた「ブロック」を選択するためのツール。

我慢したくない場合、タスクの完成したシステムは完全に最適ではなく、高価すぎるか冗長です。 ホストの各要素を個別に選択して、ターゲットの負荷に理想的にしたい場合。 vSANが既存の機器と互換性があることを確認し、必要に応じて、欠落しているノードを購入する場合。 これらのすべてのケースでは、少し下を見て、「

認定コンポーネントに基づいて独自にビルド 」リンクをクリックする必要があります。

利用可能なハードウェアがvSANと完全に(または私の場合のように完全ではなく)互換性があることを確認したら、vSphereソフトウェアをダウンロードする必要があります。 テスト目的で、VMware Webサイトに登録し、必要なバージョンのESXiおよびvCenterディストリビューションと、必要に応じて他のコンポーネントを無料でダウンロードできます。

2016年11月上旬、展開の準備時に、VMware vSphereおよびVirtual SANバージョン6.2(6.0 update2)が利用可能になりました。 11月末にバージョン6.5が登場しましたが、あまりにも新鮮でパッチが適用されていないソリューションで急いでテストを実施せず、6.2で停止しました。

VMwareは、vSAN(Enterprise Plus)のフル機能バージョンのテストを60日間使用する機会を提供します。vSANを個別にダウンロードしてインストールする必要はありませんが、vSANはハイパーバイザーディストリビューション(ESXi)の一部です。

ESXiのダウンロードとインストールは非常に簡単なタスクで、女子高生(特にadmin-enikey)はそれを処理できます。 vCenter Infrastructure Management Serverをデプロイする際、Windowsに煩わされることはありませんでした;単純さと信頼性のために、vCenter Server Appliance(vCSA)ディストリビューション、VMware for Linuxからの既製の無料デプロイメントに決めました。 Web GUIを使用したインストールと管理は非常に簡単です。

私のテストホストには60GBのブート可能なSSDがあります。 これは、ESXiをインストールするのに十分以上です。 vCenter Server Applianceは、これらのSSDの1つに「シンディスク」モードでデプロイされました-十分なスペースがありました。

vCSAを使用する場合、次のニュアンスを知っておくと便利です。

vCSAの展開中に、次を指定する必要があります。

•ルートパスワード-展開自体(vCSA)を管理します。

•管理者名vCenter SSO(管理者など)およびそのパスワード、ドメイン名(vsphere.localなど)-仮想インフラストラクチャ(VI)の集中管理用。

管理するときは、次のことを考慮する必要があります。

1. VIを集中管理するには、https:/ IPアドレス(ドメイン名)_(vCSAのインストール中に指定)にログインする必要があります。 ポートを指定する必要はありません、それは標準です。 使用されるアカウントはvCenter SSO管理者であり、administrator @ vsphere.localなどの完全修飾ドメイン名が必要です。

2.展開自体(vCSA)を管理するには、https:/ IPアドレス(ドメイン名):5480(このポートを明示的に指定)にログインする必要があります。 使用されるアカウントはルートです。

ESXiコマンドラインアクセス

パッチとドライバーをインストールし、付随する診断操作を実行するには、ESXiコマンドラインへのアクセスが必要です。

特に本番環境での仮想インフラストラクチャ更新の集中管理は、vSphere Update Manager(vUM)を介して行うと便利で便利です。 vSphereバージョン6.2以前の場合、vUMはWindowsマシンに展開する必要があります。 バージョン6.5では、状況はより良くなりました-vUMはオプションのvCenter Server Applianceサービスであり、Windowsに個別のVMをデプロイする必要はありません。 テスト目的で、特にホストの数が少ない場合(たとえば、私のプロジェクトのように4)、別のvUM-VMを展開するのは実用的ではなく、コマンドラインを使用する方が簡単です。

古いメモリ(vSphere 5.0)に基づいて、hostsコマンドラインへのリモートアクセス用にVMware-vSphere-CLIをインストールすることにしました。 ただし、これは非常に不便であることが判明しました。たとえば、「-server 172.16.21.76 --username root --thumbprint 2F:4B:65:EC:C9:FA :DF:AC:20:62:3D:5D:4B:E4:43:EC:35:74:AE:86」、ルートパスワードを入力します。

Windowsで管理PCからesxcliコマンドを正しく実行する方法を学ぶために、私は半日殺しました。 まず、VMware-vSphere-CLIがWindows 10で正しく動作しないため、正常に動作するには、このパッケージがインストールされているフォルダーからコマンドを実行するか、環境変数を使用する必要があります。 次に、各ホストが「指紋」を決定する必要があります(--thumbprint 2F:4B:65:EC:C9:FA:DF:AC:20:62:3D:5D:4B:E4:43:EC:35 :74:AE:86)、それなしでは、コマンドは機能しません。 3番目に、コマンドを--passwordパラメーターとパスワードとともにコピーすると、入力言語に関連するエラーが生成されるため、ルートパスワードを毎回個別に入力する必要があります(コマンド全体を保存してメモ帳からコピーしました)。 これらすべての微妙な点とエラー、およびそれらの排除が明らかではなかったため、半日かかりました。 突然VMware-vSphere-CLIを使用したい場合は、この段落で作業が楽になるはずです。

VMware-vSphere-CLIを打ち負かし、調理する方法を学んで、私はそれが単に不便であることに気づきました。 各ホストでSSHアクセスを許可し、Puttyを使用する方がはるかに便利です。 コマンドは短く、毎回パスワードを入力する必要はありません。Puttyにコピーする方がはるかに便利です。

これを行うには、各ホストでSSHおよびESXi Shellサービスを実行する必要があります。 これは、DCUI(ホストに直接接続)またはvSphere Client(構成-セキュリティプロファイル)を使用して実行できます。

パッチのインストール

私は、vSphere 5.0を数年にわたって展開および保守した経験があります。 パッチをインストールしたことも問題も発生したことはありません。たとえば、Win 2012 R2でVMを上げるためだけに更新プログラムをインストールしました(更新プログラム3が必要でした)。

このプロジェクトでは、パッチは非常に役立ちました。 パッチをインストールすると、次の問題が解決されました。

•VMのライブマイグレーションの時間が大幅に短縮されました。 完全にアンロードされたインフラストラクチャ、タスクが実行されていないWin7を備えたvMotion VMにパッチをインストールする前に、完了まで約1分かかりました。 パッチ適用後-数秒。

•ハイブリッドvSAN 6.2のパフォーマンスの低下に関する問題が修正されました。 この問題は、この記事「

vSAN 6.2ハイブリッドディスクグループのパフォーマンス低下(2146267) 」で説明されています。 バージョン6.0および6.1からバージョン6.2にアップグレードすると、vSANハイブリッドクラスターのパフォーマンスが低下したという。 これは、バージョン6.2で登場した重複排除メカニズムの一意のストレージブロックをスナップする低レベルバックグラウンドプロセスのスレーブが原因です。 これは、「dedup」がオンになっているオールフラッシュクラスタでのみ有用ですが、誤って起動し、ハイブリッドバージョンのリソースを使用します。 この問題は、パッチをインストールするか、特別なチームがメカニズムを無効にすることで解決されます。

このことから、最初のインストール中に、可用性を確認してパッチをインストールする必要があると結論付けました。 それは余計なものではなく、それほど害はありませんが、問題からあなたを救うことができます。 また、ESXiに追加のドライバーをインストールし、インフラストラクチャをセットアップし、VMとサービスを上げる前に、これを行う方が適切です。 なぜ、私は後で説明します。

このリンクまたは

このリンクを使用してパッチを検索する必要があり、「ESXi(組み込みおよびインストール可能)」を選択してESXiパッチを検索し、「VC」を選択してvCenterパッチを検索する必要があります。

パッチをダウンロードした後、それらをインストールします。 vCSAのパッチは、web-guiを介して簡単にインストールできます。 パッチを含むディスクイメージをvCSA-VMにマウントする必要があります。このため、このVMが回転しているローカルホストデータストアに配置することをお勧めします(ブートSSDに配置します)。 また、管理PCからネットワーク経由で画像を転送することもできます(画像は大きく、主観的で長く信頼できないと思いました)。 次に、vCSA(https:/ IPアドレス(ドメイン名):5480、ルートの下)に移動して、[更新]タブを選択し、イメージから更新する必要があります(Chesk Updates-CDROM)。 理論的には、このステップでインターネットから更新することができました(Chesk Updates-URL)。接続があれば、vCSA自体はグローバルWebから更新されると思います。

ESXiホストのアップグレードはやや複雑です。 ダウンロードしたパッチ-VIBファイルを含むzipアーカイブは、ターゲットホストのローカルデータストアに配置する必要があります(これをブート可能なSSDに配置しました。このため、ルートにUpdateフォルダーを作成しました)。 ローカルホストデータストアにパッチをダウンロードするには、古き良き「厚い」vSphereクライアントをインストールし、それをホストにフックしてから、(概要)タブで(ストレージ)セクションを探し、ターゲットデータストア-データストアの参照を右クリックして、目的のファイルまたはフォルダーをロードします。

その後、各パッチをインストールするために(4つありました)、次のコマンドを実行する必要があります。

esxcli software vib update -d /vmfs/volumes/local_datastore_name/update_folder_name/ESXi600-201605001.zip

ここで:

-d-zipアーカイブからパッケージをインストールするための引数(個々のパッケージを解凍してインストールする場合-* .VIBファイルには、-v引数が必要です)。

/vmfs/volumes/local_datastore_name/update_folder_name/ESXi600-201605001.zip-パッチへのフルパス。

アーカイブから何も抽出する必要はありません。esdcliソフトウェアのvid updateコマンドに-dオプションを指定すると、すべてが自動的に実行されます。

各パッチをインストールすると、コンソール(私の場合はPutty)にインストール結果が表示されます。このようなパッケージはインストール、削除、スキップされ、再起動が必要です。 各パッチのインストール後の再起動はオプションです。すべてをインストールしてから再起動できます。

更新とは異なり

、手動でインストールされたドライバーを削除

する同様のesxcliソフトウェアvib

インストールコマンドがあることに注意してください。 したがって、更新を使用することをお勧めします。このオプションを使用すると、非標準ドライバーを保存して再インストールを回避できます(インストール後、すべてのIBドライバーが飛んでネットワークが落ちました)。

ドライバーのインストール

重要なタスクは、vSphere 6.2をIPoIBモードのInfiniBandネットワークと友達にすることでした。これは高速ネットワークで利用できる唯一のオプションであるため、ほとんどの場合、私のプロジェクトとvSANの通常の1GbEネットワークでは十分ではありません。

最初に、テストホストには、帯域幅100 Gb / sのHCA Mellanox ConnectX-4アダプターが装備され、対応するMallanox SB7790 IBスイッチに接続されていました。 Mellanox ConnectX-4は、IBモードとイーサネットモードの両方で動作できるハイブリッドアダプターです。 問題は、既存のスイッチはIBモードでしか動作せず、イーサネットを認識しないことです。 vSphereはイーサネットのみで、InfiniBandはサポートしていません。 妥協オプション-IPoIBの引き上げ-も機能しませんでした。これは、MellanoxがvSphereのConnectX-4用のIBドライバーを作成せず、イーサネットのみを作成したためです。 これを確認するために、ESXiのMellanoxドライバー(MLNX-OFED-ESX)のさまざまなオプションをインストールする必要がありましたが、どのオプションでもホストが目的のネットワークを見ることができませんでした。

zashashnikの2ポートMellanox ConnectX-2およびConnectX-3カード(各モデルの合計2台、ホストあたり合計1台)のおかげで、問題を解決することができました。古いバージョンと遅いバージョン-それぞれ40 Gbit / sおよび56 Gbit / s実験およびvSANの場合、これで十分です。 最も重要なことは、これらのアダプターには、vSphere 6.2の正しいfire、つまりMLNX-OFED-ESX-2.4.0.0-10EM-600.0.0.2494585があります。 ホストへのインストールにより、InfiniBandネットワークを確認し、最大40 Gb / sの理論速度でIPoIBを介して相互に通信できました。

上記の名前のzipアーカイブ形式の正しいfireは、Mellanoxの公式Webサイトからダウンロードされます。 それらをインストールする前に、各ESXiホストからハイパーバイザーディストリビューションに組み込まれたInfiniBandドライバーを削除する必要があります。これらのドライバーには名前に「ib」と「mlx」の記号があります。 ホストにインストールされているドライバー(VIBパケット)のリストを表示するには、SSHを介してそれに接続し、コマンドを実行する必要があります。

esxcli software vib list

出力では、大きなリストを取得し、不要なものを破棄し、必要なパッケージのみのリストを取得するために、最適化を行います。

esxcliソフトウェアvibリスト| grep ib-名前に記号「ib」を含むパッケージのリストを表示し、

esxcliソフトウェアvibリスト| grep mlx-名前に文字「mlx」を含むパッケージのリストを表示します。

出力では、次のものが得られます。

[root@esxi-5:~] esxcli software vib list | grep mlx net-mlx-compat 2.4.0.0-1OEM.600.0.0.2494585 MEL PartnerSupported 2016-11-21 net-mlx4-core 2.4.0.0-1OEM.600.0.0.2494585 MEL PartnerSupported 2016-12-07 net-mlx4-en 2.4.0.0-1OEM.600.0.0.2494585 MEL PartnerSupported 2016-12-07 net-mlx4-ib 2.4.0.0-1OEM.600.0.0.2494585 MEL PartnerSupported 2016-11-21 [root@esxi-5:~] esxcli software vib list | grep ib net-ib-core 2.4.0.0-1OEM.600.0.0.2494585 MEL PartnerSupported 2016-11-21 net-ib-ipoib 2.4.0.0-1OEM.600.0.0.2494585 MEL PartnerSupported 2016-11-21 net-ib-mad 2.4.0.0-1OEM.600.0.0.2494585 MEL PartnerSupported 2016-11-21 net-ib-sa 2.4.0.0-1OEM.600.0.0.2494585 MEL PartnerSupported 2016-11-21 net-mlx4-ib 2.4.0.0-1OEM.600.0.0.2494585 MEL PartnerSupported 2016-11-21

この結論は、間違ったものを取り除いて正しいcorrectを取り付けた後、すでにありました;最初は異なっていました。 削除するパッケージ名のリスト(追加のlist)を受け取った後、それらを一度に削除できるコマンドを作成します(-nパラメーターを使用すると、必要なすべてのパッケージ名をセパレーターとしてリストする必要があります)。

esxcli software vib remove -n net-ib-core –n net-ib-ipoib –n net-ib-mad –n net-ib-sa –n net-mlx-compat -n net-mlx4-core –n net-mlx4-en –n net-mlx4-ib -n scsi-ib-srp -n net-ib-cm -f

ここで、-fは削除を強制するパラメーターです。そうでない場合は、パッケージを一度に1つずつ削除するための正しいシーケンスを探す必要があります。

次に、正しいfireを使用してパッケージをインストールし、ホストを再起動します。 このプロセスは、パッチのインストールと同じです-ドライバーを含むzipパッケージをターゲットホストのローカルデータストアに配置し、コマンドを実行します。

esxcli software vib install –d /vmfs/volumes/local_datastore_name/update_folder_name/driver _pack_name.zip

この手順は、テストインフラストラクチャの各ホストで実行する必要があります。

クラスターホスティング

ESXiをホストにインストールし、パッチとネットワークドライバーをそれらにインストールし、VMをvCSAで展開(およびパッチ)した後、ホストをセンター(vCenter Server)に接続し始めます。 これを行うには、vCenter SSO管理アカウントを使用してWebコンソール経由でvCenterに接続し、Datacenterオブジェクトを作成し、その中にクラスターオブジェクトを作成し、ESXiホストを追加し(私の場合は4pcs)、必要なサービスを有効にします-HA(不要、基本的なサービス)とvSAN(すべてがそのために行われたため)

各ホストおよびセンターでNTPサーバーとの時間同期を有効にすることをお勧めします。パフォーマンスを監視し、イベントに応答する方が便利です。 MS-ADドメインコントローラーから時間がかかるのはうまくいきませんでした。互換性がありません(vSphereと友達になるためにコントローラーレジストリの編集を開始しませんでした)。 インターネットからの外部NTPサーバーとの同期を設定した後、すべてが正常に機能しました。

vSANを構成する

私のスタンドでvSphereクラスターレベルでネットワークを設定するには、2つの分散スイッチ(dvSwitch)を作成しました。

•ETH_DSwitch。各ホストの2つの1GbEポートに接続されています。 VMネットワークと制御ネットワークが接続されています。

•各ホストの2 40(56)GbIPoIBポートに接続されたIPoIB_DSwitch。 vMotionネットワーク(サブネット10.10.10.0、ポートグループvMotion_dpg)とvSANネットワーク(サブネット10.10.20.0、ポートグループVSAN_dpg)が接続され、サブネットおよび分散ポートグループ(dPG)レベルで分離されています。 各ホストで、示されたdPGに対して、vmkernelインターフェイスvmk1およびvmk2が発生しました。対応するサブネットからのIPアドレスが指定され、必要なトラフィックタイプのみが許可されます-vMotionおよびProvisioningトラフィック(vMotion_dpg)、Virtual SANトラフィック(VSAN_dpg)。

InfiniBandには、ネットワーク上のSubnet Managerと呼ばれるvSphereの外部サービスが必要です。私のテストクラスターは、別個の物理Linuxマシンで発生したOpenSMサーバーを使用しました。

vSAN 6.2のネットワークのベストプラクティスは、次のドキュメントで説明されています:VMware Virtual SAN 6.2ネットワーク設計ガイド。 私のvSANは管理されていないIBスイッチを使用して構築されているため、ポートアグリゲーション、NIOC、マルチキャストを正しく構成するなど、クールなことはできませんでした。機器をサポートしていません。 したがって、すべてのdvSwitchおよびdPGの設定はデフォルトで残され、dPGの両方のアップリンクがアクティブになりました。

行われたことが判明した唯一のチューニングは、ジャンボフレームを構成することです。 vSphereのIPoIBモードでMellanoxアダプターがサポートする可能な最大MTUサイズは4092です。この最大値を達成するには、dvSwitch(IPoIB_DSwitch)およびvmkernel設定(各ホストのvMotionおよびvSANの下のすべてのvmk)でMTU = 4092を選択する必要があります。 デフォルトでは、OpenSMのMTUサイズは2044です。したがって、OpenSM構成でMTU構成を4092に増やしないと、このサイズのフレームはネットワーク上を移動できません。さらに、通常のpingはホスト間で行われますが、ネットワーク上のホスト間の生産的な相互作用は不可能になります。 私はこのニュアンスを発見するために多くの時間を費やしたので、それを非常に重要かつ有用だと考えています。

後で発見したように、VMware Virtual SAN 6.2ネットワーク設計ガイドでは、ジャンボフレームを有効にしてもvSANの最適化はあまり行われないと述べています。 ネットワークでサポートされている場合は有効にする必要がありますが、有効になっていない場合は、1500のサイズのままにしてかまいません。

ジャンボフレームの適切な動作を確認するには、クラスターホスト間(個別にvMotionサブネットとvSANサブネット用)で大きなMTUサイズ(この場合は4092)でpingまたはvmkpingを実行する必要があります。

vmkping ( ping) -d -s MTU_size__28_ IP-

ここで、-dはパケットのセグメンテーションを禁止します。-s MTU_size_minus_28_bytes-28を減算する必要があるMTUサイズ(バイト単位)。

私の場合、MTU = 4092の場合、コマンドは次のようになります。

ping -d -s 4064 10.10.20.79

ネットワークパフォーマンステスト

vSANのパフォーマンスをテストするには、ネットワークがボトルネックではなく、適切な帯域幅を提供していることを確認する必要があります。 理論的には、vSphereは、IBインターフェイスがMellanox ConnectX-2カードに対して40ギガビット/秒、ConnectX-3に対して56ギガビット/秒を発行することを示しています。

vSANには10Gbpsアダプターが推奨されることを考えると、私のカードのパフォーマンスは十分すぎるほどです。 実際に彼らの実際のパフォーマンスを検証することは残っています。 これを行うには、

iperfユーティリティを使用します。

2つの方法があります。 最初のものは悪くて不快ですが、頭に浮かぶだけです。

ネットワークパフォーマンスを測定するホストに1つまたは複数のVMのペアを展開する必要があります。 これらのVMのVMICは、テストされた物理ポートを調べるdPGに接続する必要があります。 これを行うには、dvSwitch「IPoIB_DSwitch」で「dgp_40Gbps_VMnet」というdPGを作成し、vSANが動作するのと同じ物理ポート(IPoIB)に接続しました。

このVMのペアで、iperfを起動して結果を確認します。 問題は、vSphere VM(vmxnet3)に提供できる仮想ネットワークカードの最大スループットが10ギガビット/秒であることです。 したがって、テストでは、win7の下で3組のVMを作成し、それらに対して並行してテストを実行する必要がありました。 IPoIBポートで最大16Gbit / sを圧縮できた最大値。 もう悪くない。

1対のサーバーVMにとどまり、それらにいくつかのvmxnet3(4個など)を与え、ゲストOSレベルでそれらの間のタイミングをとることを試みることができます。 これが帯域幅を組み合わせ、1つのVMで理論的な10x4 = 40Gbps(4x vmxnet3の場合)を圧縮するかどうかはわかりません。 成功した実装をグーグルで検索しなかったため、彼はチェックしませんでしたが、よりシンプルでエレガントな方法を見つけました。

実際、バージョン6.2以降、vSphereはvSANヘルスサービスの可用性を前提としています。この操作では、iperfユーティリティを含むパッケージがESXi配布パッケージに追加され、コマンドラインから起動できます。これにより、vSphereネットワークパフォーマンスをハイパーバイザーレベルで直接測定できます。

これを行うには、一対のESXiホストに接続する必要があります。その間でSSHを使用してネットワーク速度を測定します。 各ホストで、たとえば次のコマンドを使用して、ESXiファイアウォールを無効にする必要があります。

esxcli network firewall set --enabled false

ESXiのiperfパッケージは、iperfおよびiperf.copyファイル(コピーのみ)の/ usr / lib / vmware / vsan / bin /にあります。

ネットワークの負荷テストを実行するには、トラフィックプライマーとして選択されたホストでコマンドを実行する必要があります。

/usr/lib/vmware/vsan/bin/iperf.copy -s -B 10.10.20.79 -w 1M

ここで、–s-iperfサービスが受信側(サーバー)モードで開始することを意味します。

-B 10.10.20.79-指定されたIPアドレスを持つホストインターフェイスがトラフィックを受信することを意味します。私の場合は、選択したホスト上のvSANのvmkernelアドレスです。

-w 1M-TCPウィンドウサイズは1MBに設定されます。

送信側ホスト(トラフィックジェネレーター)で、次のコマンドを実行します。

/usr/lib/vmware/vsan/bin/iperf -c 10.10.10.79 -t 60 -i 3 -w 1M –P 4

-c 10.10.10.79-受信者のアドレスを設定します。

-t 60-テストの期間を秒単位で設定します。

-i 3-現在の結果を更新する間隔(秒)、

-w 1M-TCPウィンドウサイズは1MBに設定されます。

-P 4-並列スレッドの数。

最大のテスト結果は、-wおよび-Pパラメーターの最適な値を選択することで達成できます。私の場合は1Mおよび4です。IPoIBポートあたり最大22-27 Gbit / sのスループットを達成できました。 もちろん、これはIBインターフェース用のvSphere Webクライアントが書いているように、40ギガビット/秒からはほど遠いです。 それにもかかわらず、ネットワーク速度の実際的な制限は既知であり、非常に堅実です(vSANの推奨値の2.5倍)。

vSANクラスターの有効化

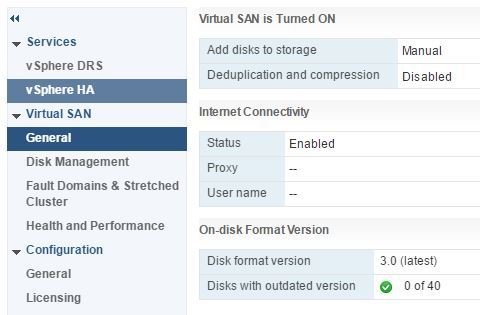

クラスターの管理に入り、「vSANを有効にする」を選択します。ディスクを追加するモードは、重複除去と圧縮なしで手動です(ハイブリッドクラスターがあります)。

VSANは「次から次へ」のダイアログモードでオンに切り替えられました(これも女子学生の場合はすべてシンプルです)。vSphere自体がどのメディアがフラッシュキャッシュにどの容量になるかを正しく判断し、ディスクグループに最適に結合しました。

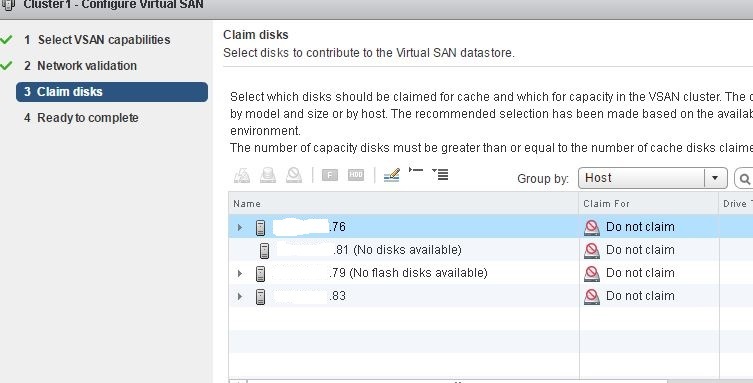

すべてが美しくなりましたが、すぐにではありません。 最初はタンバリンとのダンスがありました。 実際、すべてのホスト上のハイパーバイザーは10個のローカルメディアすべてを認識し、VMFSでフォーマットできます。

ただし、vSANクラスターの作成に関するダイアログでは、ホストからのメディアの一部しか見られませんでした:1つはすべて10、2つ目は1つではなく、2つ目は一部のみであったため、vSANを上げるために機能しませんでした、神秘主義

vSANのブルジョアVMUGブランチのメンバーは、クラスターメディアに残っているパーティションをチェックするように言ってくれました。 これらのセクションを削除すると、問題は解決しました。 これを行うには、サードパーティのブートユーティリティを使用してパーティションを操作するか、ESXiコマンドライン機能で停止します。

esxcliストレージコアデバイスリスト -コマンドはホストストレージデバイスのリストを表示しますが、このリストには多くの冗長情報があるため、最適化する必要があります。

esxcliストレージコアデバイスリスト| grep Devfs | cut -f2 -d ":" -この場合、デバイス名の付いたドレインのみが表示されます。ホストの1

つでは 、結果は次のようになります。

[root@esxi-5:~] esxcli storage core device list | grep Devfs | cut -f2 -d":" /vmfs/devices/disks/naa.5000cca2450f5854 /vmfs/devices/disks/naa.5000cca2450ee00c /vmfs/devices/disks/naa.5000cca2450efa88 /vmfs/devices/disks/t10.NVMe____HUSPR3216AHP301_________________________003F1E6000CA0C00 /vmfs/devices/disks/naa.5000cca2450f56e8 /vmfs/devices/genscsi/naa.50015b2140027a7d /vmfs/devices/disks/t10.ATA_____SPCC_Solid_State_Disk___________________F4C307651C8E00015407 /vmfs/devices/disks/naa.5000cca2450f5604 /vmfs/devices/disks/naa.5000cca2450f2d2c /vmfs/devices/disks/naa.5000cca2450f6d9c /vmfs/devices/disks/naa.5000cca2450ec6d8 /vmfs/devices/disks/t10.NVMe____HUSPR3216AHP301_________________________802C1E6000CA0C00

次に、ドライブ上のパーティションのリストを表示するコマンドを入力します。これは各デバイスに対して実行する必要があります。

partedUtil getptbl device_name 、ここで:device_nameは、たとえば次のように、デバイスの名前と上記のリストです。

[root@esxi-5:~] partedUtil getptbl /vmfs/devices/disks/naa.5000cca2450f5854 gpt 243201 255 63 3907029168 1 2048 6143 381CFCCC728811E092EE000C2911D0B2 vsan 0 2 6144 3907029134 77719A0CA4A011E3A47E000C29745A24 virsto 0

このデバイスには2つのパーティションがあります。1と2の番号の行です。これは、現在のvSANクラスターのHDDからパーティションを出力する例です。実験。 実際には、パーティションのあるメディアは表示されず、空のメディアのみが表示されました(パーティションなし)。

メディアで使用可能なパーティションの番号を確認したら、次のコマンドを使用してそれらを削除します。

partedUtil delete device_name part_num 、ここで:part_numは、前のコマンドによって発行されたセクション番号です。

この例では、メディアにそれぞれ2つのパーティションがあり、コマンドを2回実行します。

partedUtil delete /vmfs/devices/disks/naa.5000cca2450f5854 1 partedUtil delete /vmfs/devices/disks/naa.5000cca2450f5854 2

そして、セクションがあるすべてのメディアに対して。 その後、メディアが表示され、vSANクラスターに追加できます。

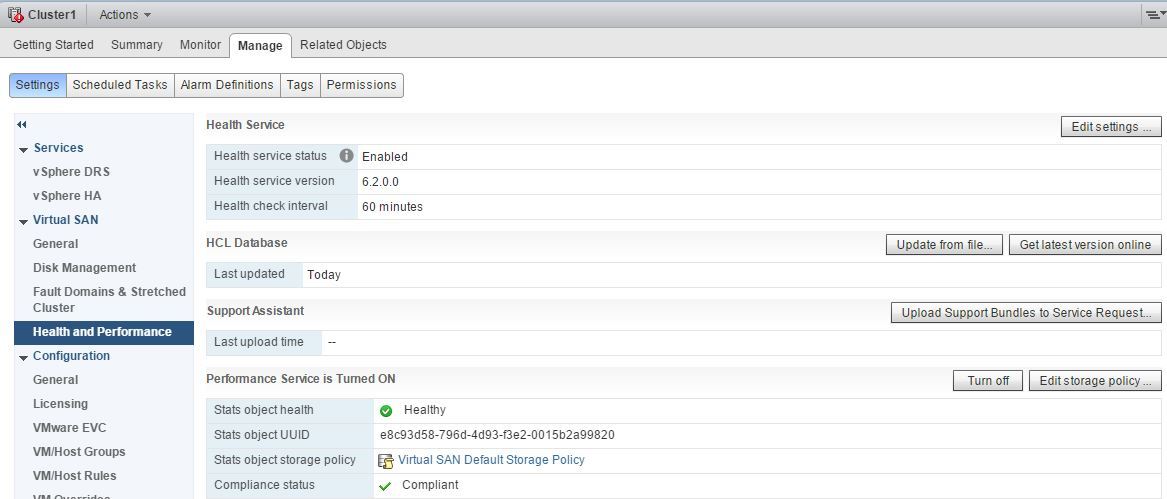

vSANの健全性を監視し、そのパフォーマンスを監視するには、[管理]-[vSAN]-[健全性とパフォーマンス]クラスタータブで健全性サービスとパフォーマンスサービスをアクティブにする必要があります。

それだけです。vSANクラスターは、テスト、VMの展開、および運用の導入の準備ができています。 ご清聴ありがとうございました!