こんにちは

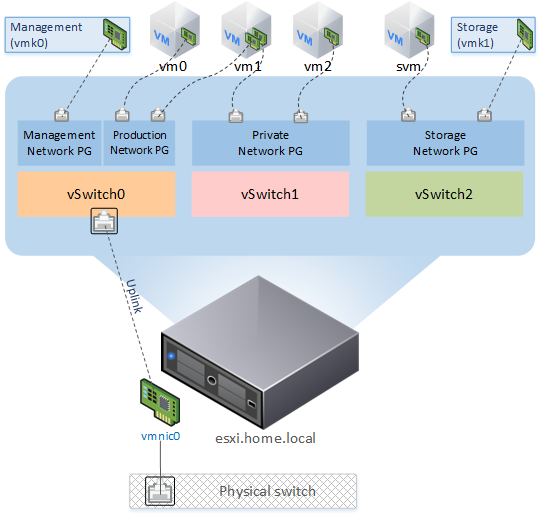

この記事では、SSDキャッシングを使用してESXiホストのパフォーマンスをわずかに向上させる方法について説明します。 職場でも自宅でも、VMwareの製品を使用しています。自宅の研究室は無料のESXi 6.5に基づいて構築されています。 ホストは、ホームインフラストラクチャと一部の作業プロジェクトのテストの両方で仮想マシンを実行します(どういうわけか、VDIインフラストラクチャを実行する必要がありました)。 徐々に、シックVMアプリケーションがディスクシステムのパフォーマンスに反して実行され始め、すべてがSDDに適合しませんでした。 ソリューションとして、lvmcacheが選択されました。 論理図は次のようになります。

スキーム全体の基本は、CentOS 7ベースのsvm VMであり、SSDデータストアからのRDM HDDと小さなVMDKディスクが彼女に提示されます。 キャッシングとデータミラーリングは、ソフトウェア-mdadmおよびlvmcacheによって実装されます。 VMディスク領域は、NFSデータストアとしてホストにマウントされます。 SSDデータストアの一部は、強力なディスクサブシステムを必要とするVM用に予約されています。

コンピューティングノードはデスクトップアイロンで組み立てられます。

MB:ギガバイトGA-Z68MX-UD2H-B3(rev。1.0)

HDD:2 x Seagate Barracuda 750Gb、7200 rpm

SSH:OCZ Vertex 3 240Gb

マザーボードには2つのRAIDコントローラーがあります。

-Intel Z68 SATAコントローラー

-Marvell 88SE9172 SATAコントローラー

ESXiで88SE9172を取得できませんでした(一部のMarvellアダプターのファームウェアにバグがあります(少なくとも88SE91xx))。両方のコントローラーをACHIモードのままにすることにしました。

Rdm

RDM(Raw Device Mapping)テクノロジーにより、仮想マシンは物理ドライブに直接アクセスできます。 通信は、別のVMFSボリューム上の特別な「マッピングファイル」ファイルを介して提供されます。 RDMは2つの互換モードを使用します。

-仮想モード-仮想ディスクファイルの場合と同じように機能し、VMFSで仮想ディスクを活用できます(ファイルロックメカニズム、インスタントスナップショット)。

-物理モード-より低いレベルの制御を必要とするアプリケーションにデバイスへの直接アクセスを提供します。

仮想モードでは、読み取り/書き込み操作が物理デバイスに送信されます。 RDMデバイスはゲストOSに仮想ディスクファイルとして提示され、ハードウェアの特性は隠されています。

物理モードでは、ほとんどすべてのSCSIコマンドがデバイスに送信されますが、ゲストOSでは、デバイスは実デバイスとして表示されます。

RDMを使用してディスクドライブをVMに接続すると、VMFSレイヤーを削除でき、物理互換モードでは、VMでそれらのステータスを監視できます(SMARTテクノロジを使用)。 さらに、ホストで何かが起こった場合、HDDを稼働中のシステムにマウントすることでVMにアクセスできます。

lvmcache

lvmcacheは、低速のHDDデバイスから高速のSSDデバイスへのデータの透過的なキャッシュを提供します。 LVMキャッシュは、最も頻繁に使用されるブロックを高速デバイスに配置します。 キャッシングのオンとオフは、作業を中断することなく実行できます。

データを読み取ろうとすると、このデータがキャッシュにあるかどうかが明らかになります。 必要なデータが存在しない場合は、HDDから読み取りが行われ、途中でデータがキャッシュに書き込まれます(キャッシュミス)。 データのさらなる読み取りはキャッシュから行われます(キャッシュヒット)。

記録

-ライトスルーモード-書き込み操作が発生すると、データはキャッシュとHDDの両方に書き込まれます。これはより安全なオプションであり、事故によるデータ損失の可能性はわずかです。

-書き戻しモード-書き込み操作が発生すると、データが最初にキャッシュに書き込まれ、次にディスクにフラッシュされます。これは、事故中にデータが失われる可能性があります。 (キャッシュでデータを受信した後、書き込み操作の完了に関する信号が制御OSに送信されるため、より高速なオプションです)。

これは、キャッシュ(ライトバック)からディスクへのデータのダンプ方法です。

システムのセットアップ

SSDデータストアがホスト上に作成されます。 使用可能なスペースを使用するこのスキームを選択しました。

220Gb — DATASTORE_SSD

149Gb —

61Gb —

10Gb — Host Swap Cache仮想ネットワークは次のとおりです。

新しいvSwitchを作成しました:

Networking → Virtual Switches → Add standart virtual switch — (svm_vSwitch, svm_), .VMkernel NICはポートグループを介してそれに接続します。

Networking → VMkernel NICs → Add VMkernel NIC

— Port group — New Port group

— New port group — — svm_PG

— Virtual switch — svm_vSwitch

— IPv4 settings — Configuration — Static — IPsvm VMが接続されるポートグループが作成されました。

Networking → Port Groups → Add port group — (svm_Network) svm_vSwitchディスクの準備

ssh経由でホストに入り、次のコマンドを実行する必要があります。

:

VMの準備

これで、これらのドライブを(既存のハードディスク)新しいVMに接続できます。 CentOS 7テンプレート、1vCPU、1024Gb RAM、2 RDMディスク、61Gb ssdディスク、2 vNIC(VMネットワークグループポート、svm_Network)-OSのインストール時には、デバイスタイプ-LVM、RAIDレベル-RAID1を使用します

NFSサーバーのセットアップは非常に簡単です。

キャッシュボリュームとメタデータボリュームを準備して、cl_svm /データボリュームのキャッシュを有効にします。

:

アレイ状態変更通知:

/etc/mdadm.confファイルの最後に、アレイに問題がある場合にメッセージが送信されるアドレスを含むパラメーターを追加し、必要に応じて送信者アドレスを指定します。

MAILADDR alert@domain.ru

MAILFROM svm@domain.ru変更を有効にするには、mdmonitorサービスを再起動する必要があります。

VMからのメールは、ssmtpを使用して送信されます。 私はRDMを仮想互換モードで使用しているため、ホスト自体がディスクのステータスをチェックします。

ホストの準備NFSデータストアをESXiに追加します。

Storage → Datastores → New Datastore → Mount NFS Datastore

Name: DATASTORE_NFS

NFS server: 10.0.0.2

NFS share: /dataVMの起動を構成します。

Host → Manage → System → Autostart → Edit Settings

Enabled — Yes

Start delay — 180sec

Stop delay — 120sec

Stop action — Shut down

Wait for heartbeat — No

Virtual Machines → svm → Autostart → Increase Priority

( , Inventory )このポリシーにより、svm VMが最初に起動し、ハイパーバイザーがNFSデータストアをマウントした後、残りのマシンがオンになります。 シャットダウンは逆の順序で発生します。 VMの起動遅延時間は、クラッシュテストの結果に基づいて選択されました。開始遅延NFSの値が小さいと、データストアにマウントする時間がなく、ホストがまだ利用できないVMを起動しようとしたためです。

NFS.HeartbeatFrequencyパラメーターで遊ぶこともできます。

コマンドラインを使用して、VMの自動起動をより柔軟に構成できます。

:

わずかな最適化ホストでジャンボフレームを有効にします。

Jumbo Frames: Networking → Virtual Switches → svm_vSwitch MTU 9000;

Networking → Vmkernel NICs → vmk1 MTU 9000[詳細設定]で、次の値を設定します。

NFS.HeartbeatFrequency = 12

NFS.HeartbeatTimeout = 5

NFS.HeartbeatMaxFailures = 10

Net.TcpipHeapSize = 32 ( 0)

Net.TcpipHeapMax = 512

NFS.MaxVolumes = 256

NFS.MaxQueueDepth = 64 ( 4294967295)VM svmでジャンボフレームを有効にします。

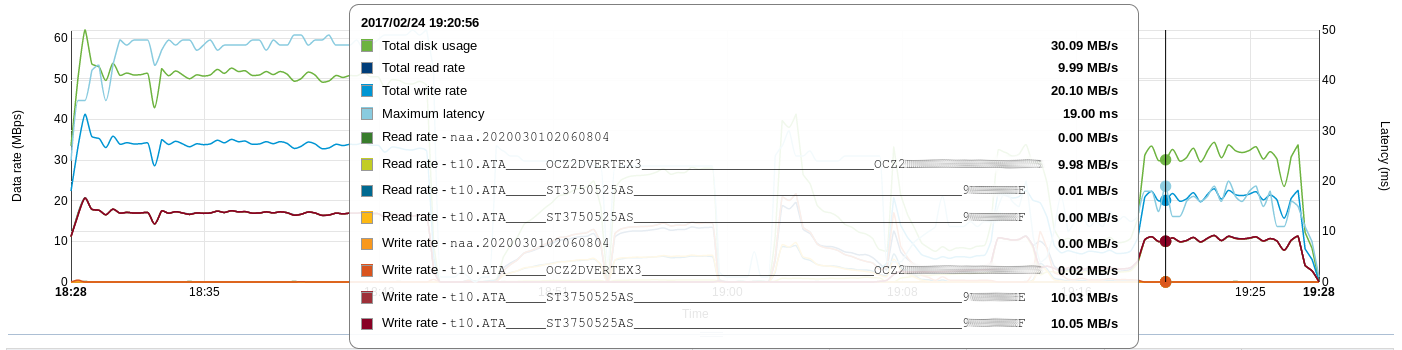

性能

パフォーマンスは、合成テストで測定しました(比較のため、作業中のクラスター(夜間)から測定値を取得しました)。

テストVMで使用されるソフトウェア:

-CentOS 7.3.1611 OS(8 vCPU、12Gb vRAM、100Gb vHDD)

-fio v2.2.8

:

結果を表に示します(*テスト中、svm VMの平均CPU負荷に注意):

VMFS6データストア| ディスクの種類 | FIO深さ1(iops) | FIO深さ24(iops) |

|---|

| ランドリード | randwrite | ランドリード | randwrite |

| HDD | 77 | 99 | 169 | 100 |

| SSD | 5639 | 17039 | 40868 | 53670 |

NFSデータストア| SSDキャッシュ | FIO深さ1(iops) | FIO深さ24(iops) | CPU /準備完了*% |

|---|

| ランドリード | randwrite | ランドリード | randwrite |

| オフ | 103 | 97 | 279 | 102 | 2.7 / 0.15 |

| に | 1390 | 722 | 6474 | 576 | 15 / 0.1 |

作業クラスター| ディスクの種類 | FIO深さ1(iops) | FIO深さ24(iops) |

|---|

| ランドリード | randwrite | ランドリード | randwrite |

| 900Gb 10k(6D + 2P) | 122 | 1085 | 2114 | 1107 |

| 4Tb 7.2k(8D + 2P) | 68 | 489 | 1643 | 480 |

起動時にWindows 7とオフィススイート(MS Office 2013 Pro + Visio + Project)で5つのVMを実行しているときに、手で触れることができる結果が得られました。 キャッシュがウォームアップすると、VMはより高速にロードされ、HDDは事実上ブートに参加しません。 起動するたびに、5つのVMのうち1つが全負荷になり、すべてのVMが全負荷になる時間を記録しました。

5つのVMの同時起動| いや | データストア | 最初の打ち上げ | 二回目の打ち上げ | 3回目の打ち上げ |

|---|

| 最初のVMブート時間 | すべてのVMのダウンロード時間 | 最初のVMブート時間 | すべてのVMのダウンロード時間 | 最初のVMブート時間 | すべてのVMのダウンロード時間 |

| 1 | HDD VMFS6 | 4分 8秒 | 6分 28秒 | 3分 56秒 | 6分 23秒 | 3分 40秒 | 5分 50秒 |

| 2 | NFS(SSDキャッシュオフ) | 2分 20秒 | 3分 2秒 | 2分 34秒 | 3分 2秒 | 2分 34秒 | 2分 57秒 |

| 3 | NFS(SSDキャッシュオン) | 2分 33秒 | 2分 50秒 | 1分 23秒 | 1分 51秒 | 1分 0秒 | 1分 13秒 |

単一のVMのブート時間は次のとおりです。

— HDD VMFS6 - 50

— NFS - 35

— NFS - 26グラフの形式で:

衝突試験

電源を切る

ホストの電源を入れてロードした後、svm VMがFSチェックで起動し(データがキャッシュに残った)、NFSデータストアがホストにマウントされた後、残りのVMがロードされ、問題もデータ損失もありませんでした。

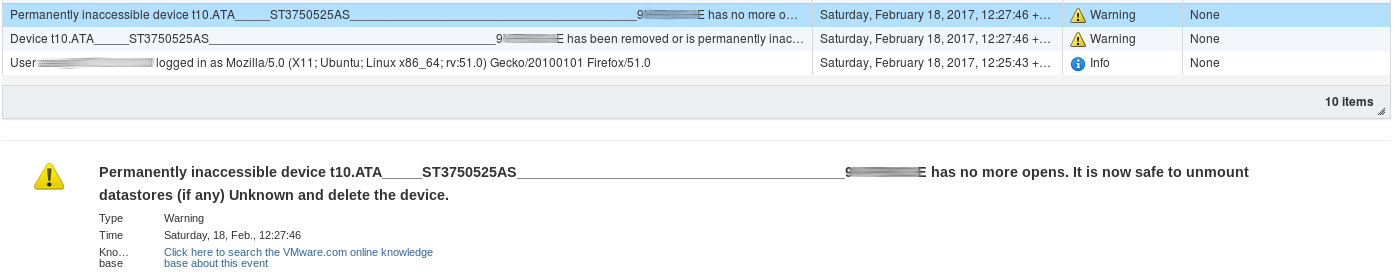

HDD障害(模倣)

SATAドライブの電源を切ることにしました。 残念ながら、ホットスワップはサポートされていないため、ホストをクラッシュさせる必要があります。 ドライブが切断された直後に、イベントに情報が表示されます。

ディスクが失われたときに、ハイパーバイザーがVM svmに質問に答えるよう求めるのは不快な瞬間でした。「この仮想デバイスを仮想マシンからホットリムーブして、[再試行]をクリックして続行できる場合があります。 このセッションを終了するには、[キャンセル]をクリックしてください。」-マシンはフリーズ状態です。

ディスクに一時的で取るに足らない問題(たとえば、ループの理由)があると想像した場合、問題を修正してホストの電源を入れると、すべてが正常に起動します。

SSDの障害

最も不快な状況は、ssdの障害です。 データへのアクセスは緊急モードです。 ssdを交換するときは、システムセットアップ手順を繰り返す必要があります。

メンテナンス(ディスク交換)

(SMARTの結果に応じて)災害が発生しようとしている場合、それを機能する災害と交換するには、次の手順を(svm VM上で)実行する必要があります。

:

VM設定で、死にかけているvHDDを「切り離す」必要があります。その後、HDDを新しいものと交換します。

次に、RDMドライブを準備し、VMにsvmを追加します。

, X — SCSI Virtual Device Node vHDD:

緊急データアクセス

ディスクの1つがワークステーションに接続されている場合、RAIDを「収集」し、キャッシュを無効にして、LVMボリュームをマウントしてデータにアクセスする必要があります。

また、ディスクからシステムを直接起動し、ネットワークをセットアップし、NFSデータストアを別のホストに接続しようとしました-VMは使用可能です。

まとめ

その結果、ライトスルーモードでlvmcacheを使用し、キャッシュサイズ60Gbのセクションを使用します。 ホストのCPUおよびRAMリソースを少し犠牲にしました-210Gbの非常に高速なディスクスペースと1.3Tbの低速なディスクスペースの代わりに、フォールトトレランスを備えた680Gbと158Gbの高速を取得しました(ただし、ディスクが予期せず故障した場合は、データにアクセスするプロセスに参加する必要があります)。