人工知能の分野の研究に関するオンライン情報の大部分は2つのカテゴリに分かれていることがわかりました。1つ目はプロではない視聴者の業績について、もう1つは他の研究者についてです。 より高度な概念に精通しておらず、ギャップを埋めるための情報を探している技術教育の人々にとって、良いリソースは見つかりませんでした。 アクセスしやすいが、同時に(比較的)詳細な説明を提供することで、この空白を埋めようとしています。 ここで、

Turing Neural Machines (NTM)に関するGraves、Wayne、およびDaniheika(2014)の科学記事を説明します。

最初は、この記事について話すつもりはありませんでしたが、私が話そうとしている別の興味深い記事を理解できませんでした。 NTMを変更するだけであったため、次に進む前にNTMを完全に理解したことを確認することにしました。 このことを確信した私は、2番目の記事は説明にあまり適していないと感じていましたが、NTMのオリジナルの作品は非常によく書かれていて、読むことを強くお勧めします。

やる気

人工知能の研究の最初の30年間、基本的には、ニューラルネットワークは絶望的な方向と見なされていました。 1950年代から1980年代後半まで、

象徴的なアプローチがAIを支配しました。 彼は、人間の脳のような情報処理システムの動作は、記号、構造、およびこれらの記号と構造の処理規則を操作することで理解できることを示唆しました。 1986年になって初めて、象徴的なAIに代わる深刻な選択肢が登場しました。 その著者は「並列分散処理」という用語を使用していましたが、今日では「

コネクショニズム 」という用語がより頻繁に使用されています。 このアプローチは聞いたことがないかもしれませんが、おそらくコネクショニズムをモデル化するための最も有名な手法の1つである人工ニューラルネットワークについて聞いたことがあるでしょう。

批評家は、ニューラルネットワークが知性をよりよく理解するのに役立つという考えに対して

2つの議論を提起しました。 まず、入力データのサイズが固定されているニューラルネットワークは、明らかに、可変サイズの入力データに関する問題を解決できません。 第二に、ニューラルネットワークはデータ構造内の特定の場所に値をバインドできないようです。 メモリで読み書きする能力は、研究に利用できる情報処理システム(脳とコンピューター)の両方で重要です。 この場合、これらの2つの議論に何が答えられますか?

最初の議論は、

リカレントニューラルネットワーク (RNN)の作成に反論されました。 処理手順に時間コンポーネントを変更したり追加したりすることなく、可変サイズの入力を処理できます-文を翻訳したり、手書きテキストを認識したりするとき、RNNは必要な回数だけ固定サイズの入力データを繰り返し受け取ります。 彼女の科学記事で、Graves et al。は、ニューラルネットワークに外部メモリへのアクセスとその使用方法を学習する能力を与えることにより、2番目の議論に反論しようとしました。 彼らは彼らのシステムを

Neural Turing Machine(NTM)と呼んだ。

背景

コンピュータ理論の専門家にとって、メモリシステムの必要性は明らかです。 コンピュータは過去半世紀にわたって飛躍的に向上しましたが、それでもメモリ、制御ロジック、算術/論理演算の3つのコンポーネントで構成されています。 また、情報を迅速に保存および取得するためのメモリシステムの利点を示す生物学的証拠もあります。 このようなメモリシステムは

ワーキングメモリと呼ばれ、NTMに関する記事は、計算神経生物学の観点からワーキングメモリを研究したいくつかの初期の論文を参照しています。

直観

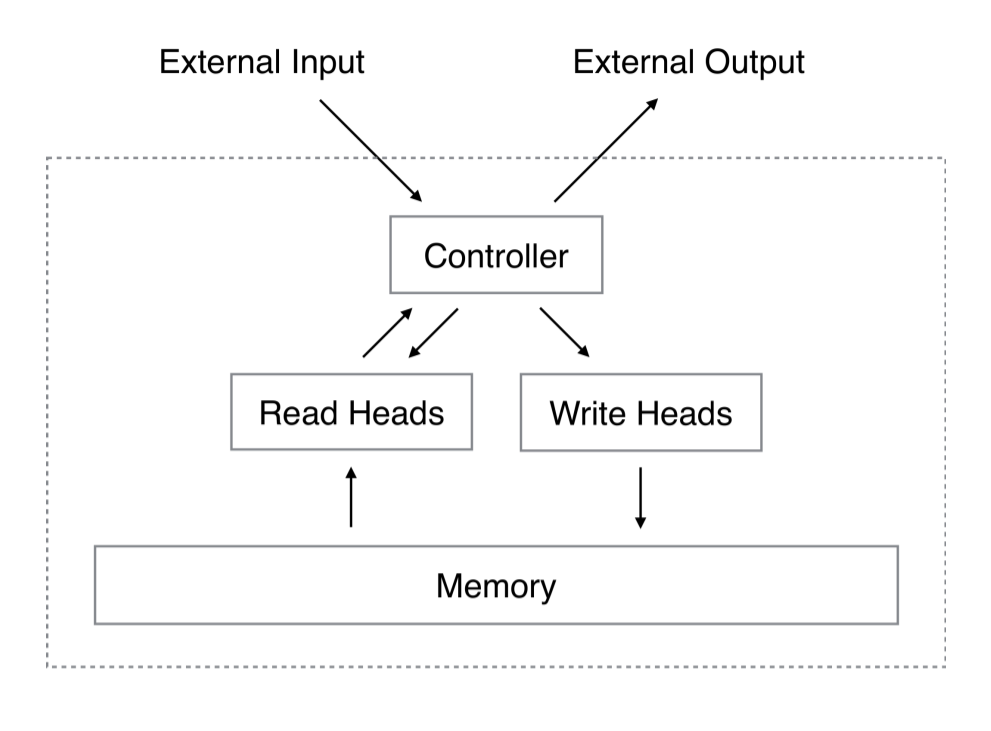

NTMの概略図には、

コントローラー 、2Dマトリックス(メモリバンク)、メモリマトリックスまたは通常の

メモリと呼ばれるニューラルネットワークが含まれてい

ます 。 各タイムステップで、ニューラルネットワークは外部の世界からデータを受信し、出力を外部の世界に送信します。 ただし、ニューラルネットワークには、個々のメモリセルから情報を読み取る機能と、個別のメモリセルに書き込む機能もあります。 Gravesらは、従来の

チューリングマシンからインスピレーションを得て、「ヘッド」という用語を使用してメモリセルの操作を説明しました。 以下の図では、点線は、システムの「内部」にあるアーキテクチャの部分を外部に対して制限しています。

しかし、キャッチがあります。 メモリにインデックスを付けると仮定します

通常のマトリックスのように、行と列を指定します。 エラーの逆伝播法とお気に入りの最適化法(たとえば、確率的勾配法を使用)を使用してニューラルネットワークをトレーニングしたいのですが、特定のインデックスの勾配を取得する方法は? 動作しません。 代わりに、コントローラーは、メモリ内のすべての要素とある程度相互作用する「ぼやけた」操作の一部として読み取りおよび書き込み操作を実行します。 コントローラはメモリセルの重みを計算します。これにより、メモリセルを微分可能な方法で決定できます。 次に、これらの重みベクトルがどのように生成され、次にどのように使用されるかを説明します(システムを理解しやすくなります)。

数学

読書

でメモリ行列を取る

行と

時間のある列のアイテム

どうやって

。 読み取り(および書き込み)を実行するには、ヘッドがデータを読み取る場所を決定する何らかの種類のアテンションメカニズムが必要です。 アテンションメカニズムの長さは正規化されます

(長さ-

)重みベクトルによる

。 重みベクトルの個々の要素については、

。 「評価」とは、次の2つの制限が満たされていることを意味します。

リーディングヘッドは長さが正規化されて返されます

(長さ-

)ベクトル

これはメモリ文字列の線形結合です

重みベクトルでスケーリング:

記録

書き込みは、読み取りよりも少し複雑です。これは、消去と追加の2つの別個のステップが含まれるためです。 古いデータを消去するには、記録ヘッドに新しいベクトルが必要です。これは長さ-

消去ベクトル

、長さに加えて

正規化された重みベクトル

。 消去ベクトルは、行内のどのアイテムを削除するか、変更しないままにするか、またはその間の何かを決定するために、重みベクトルと組み合わせて使用されます。 重みベクトルが線を指しており、消去ベクトルが要素を消去することを示している場合、この行の要素は消去されます。

変換後

で

記録ヘッドは長さを使用します

ベクトルを追加する

書き込み操作を完了します。

アドレッシング

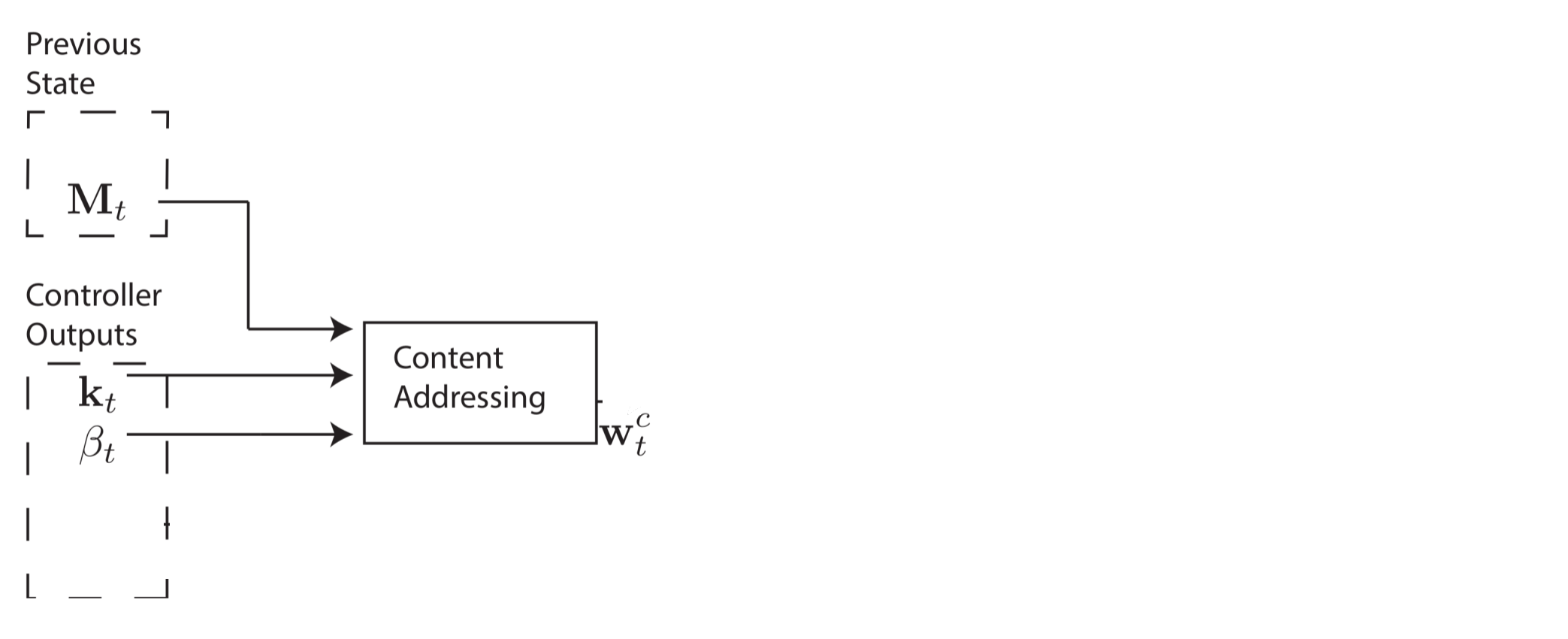

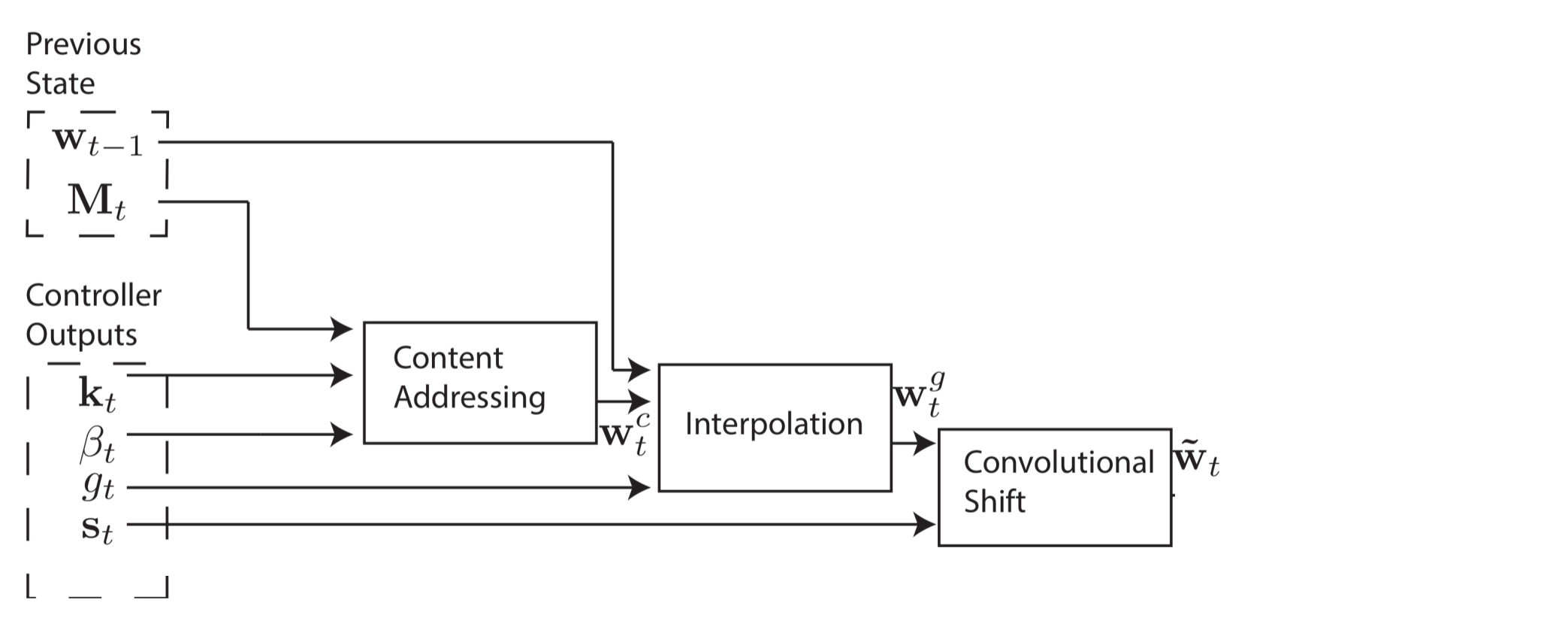

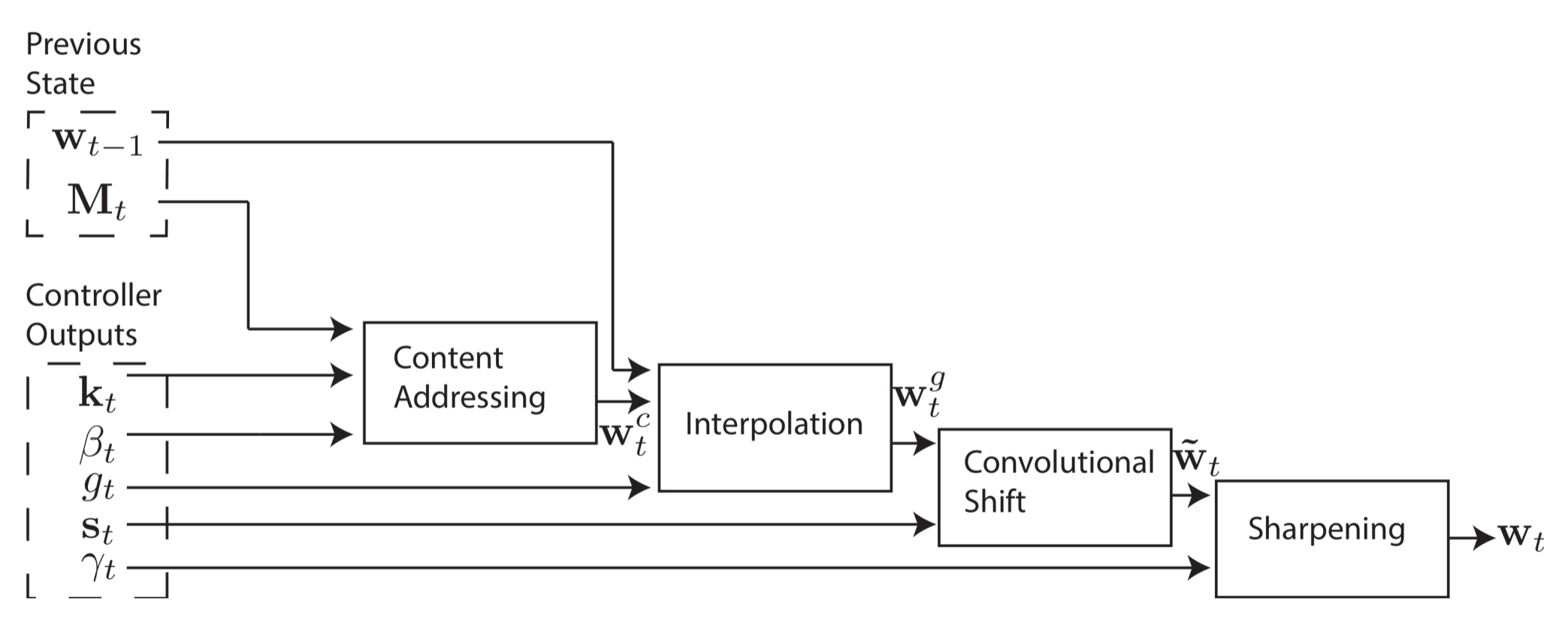

このような重みベクトルを作成してデータの読み取りと書き込みを行う場所を決定するのは簡単な作業ではなく、このプロセスを4段階で説明します。 各段階で、中間の重みベクトルが生成され、次の段階に送信されます。 最初の段階の目標は、メモリ内の各行が長さにどれだけ近いかに基づいて重みベクトルを生成することです。

ベクトル

コントローラーによって発行されます。 この中間の重みベクトルと呼びます

重み付きコンテンツベクトル。 別のパラメーター

これから説明します。

重み付きコンテンツベクトルを使用すると、コントローラーは、コンテンツのアドレス指定と呼ばれる既によく知られている値と同様の値を選択できます。 各ヘッドに対して、コントローラーはキーベクトルを生成します

各行と比較されます

類似性の尺度を使用します。 この作業では、著者は類似度のコサイン尺度を使用します。これは次のように定義されます。

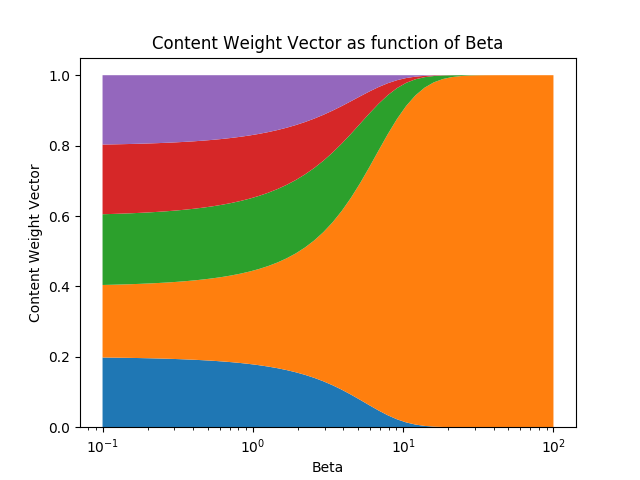

正のスカラーパラメーター

、これはキー強度と呼ばれ、重み付きコンテンツベクトルの集中度を決定するために使用されます。 ベータ値が小さい場合、重みベクトルはぼかされ、ベータ値が大きい場合、メモリ内の最も類似した行に重みベクトルが集中します。 視覚化のために、キーとメモリマトリックスが類似性ベクトル

[0.1, 0.5, 0.25, 0.1, 0.05]する場合、ベータに応じて加重コンテンツベクトルがどのように変化するかを以下に示します。

重み付きコンテンツベクトルは、次のように計算できます。

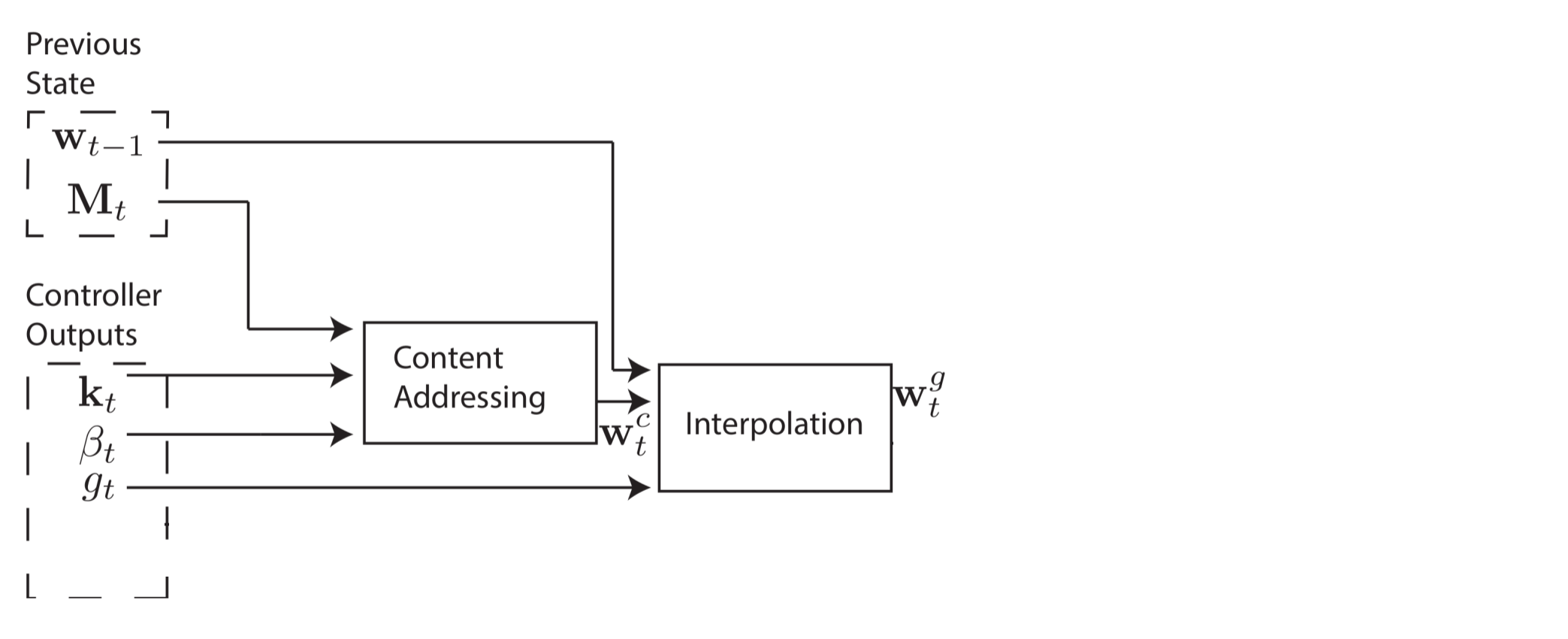

ただし、場合によっては、メモリ内の特定の値を読み取るのではなく、特定のメモリセルから読み取ることがあります。 たとえば、著者は機能を示します

。 この場合、xとyの特定の値は気にせず、メモリ内の同じセルから常に読み取るだけです。 これはセルアドレッシングと呼ばれ、その実装にはさらに3つのステップが必要です。 第2段階では、スカラーパラメーター

補間ゲートと呼ばれるコンテンツの重みベクトルを混合します

前のタイムステップの重みベクトル

バルブ重量ベクトルの製造用

。 これにより、システムはコンテンツアドレッシングをいつ使用する(または無視する)かを理解できます。

コントローラーが他の行にフォーカスを移動できるようにしたいと思います。 システムパラメータの1つに許容オフセットの範囲が制限されているとします。 たとえば、頭の注意は1行だけ前方に移動するか(+1)、変化しないまま(0)、または1行だけ後方に移動します(-1)。 モジュロシフトを行います

、そのため、メモリの一番下の行から前方に移動すると、頭の注意が一番上の行に移動します。ちょうど一番上の行から後ろに移動すると、頭の注意が一番下の行に移動します。 補間後、各ヘッドは正規化されたせん断重み付けを生成します

そして、次のたたみ込みの動きは、せん断重量を計算します

。

4番目の最終段階であるシャープニングは、せん断荷重による侵食を防ぐために使用されます。

。 これにはスカラーが必要です

。

できました! 読み書きするアドレスを定義する重みベクトルを計算できます。 さらに良いことに、システムは完全に微分可能であるため、エンドツーエンドのエンドツーエンドの学習が可能です。

実験と結果

コピー

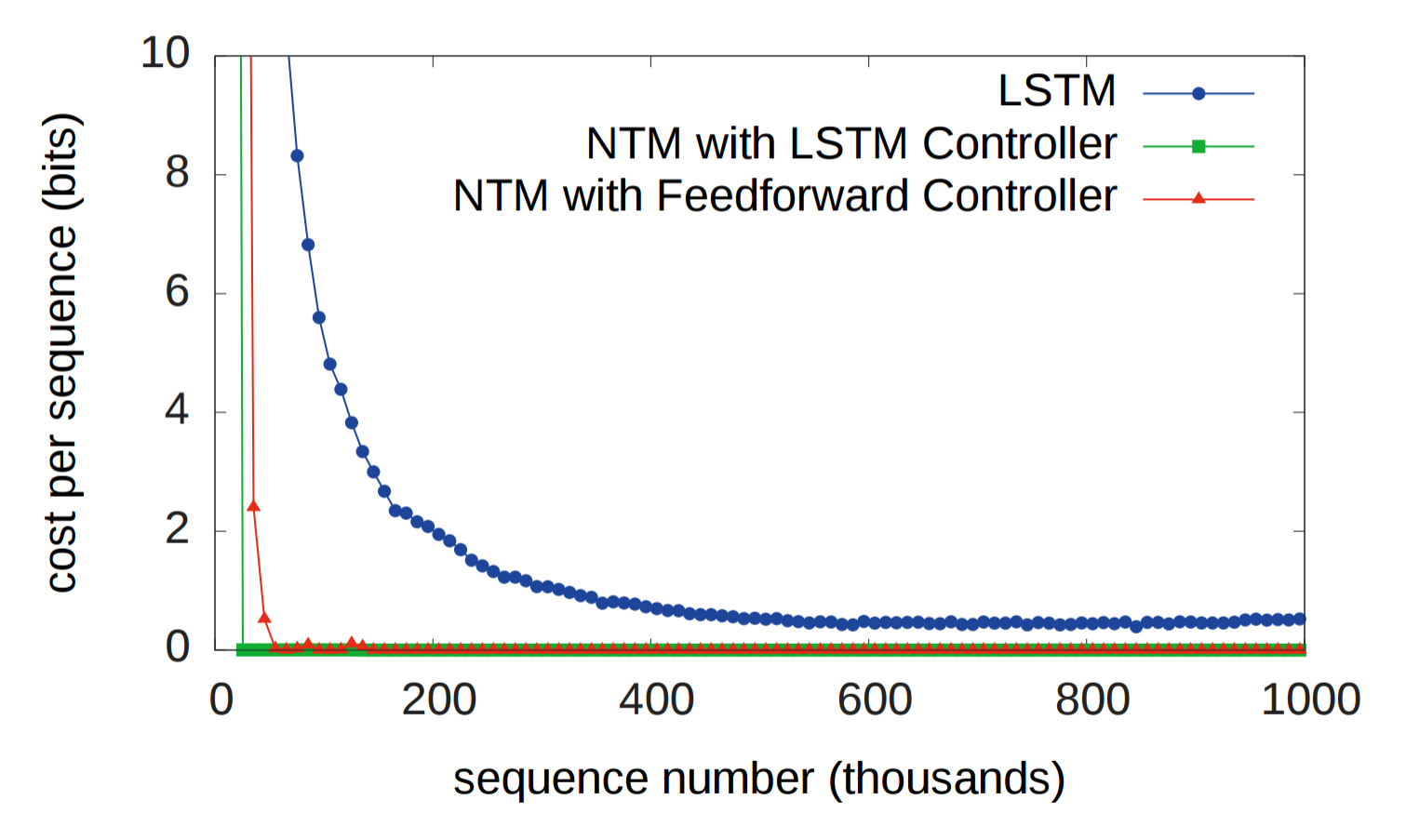

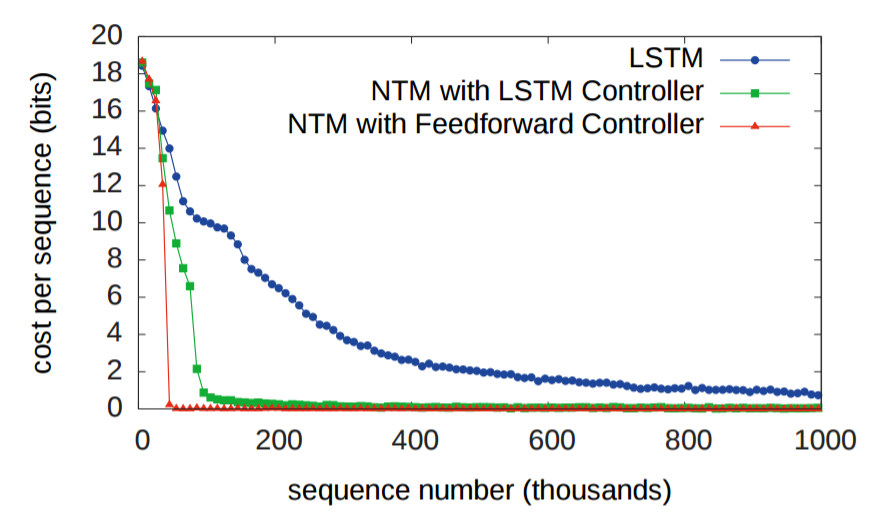

歴史的に、RNNは長い間情報を記憶することができないという問題に悩まされてきました。 最初の実験は、外部メモリシステムが状況を改善するかどうかをテストするために設計されています。 この実験では、3つのシステムにランダムな8ビットベクトルのシーケンスが与えられ、その後にデータセパレーターフラグが続き、入力データのシーケンスを繰り返すように求められました。

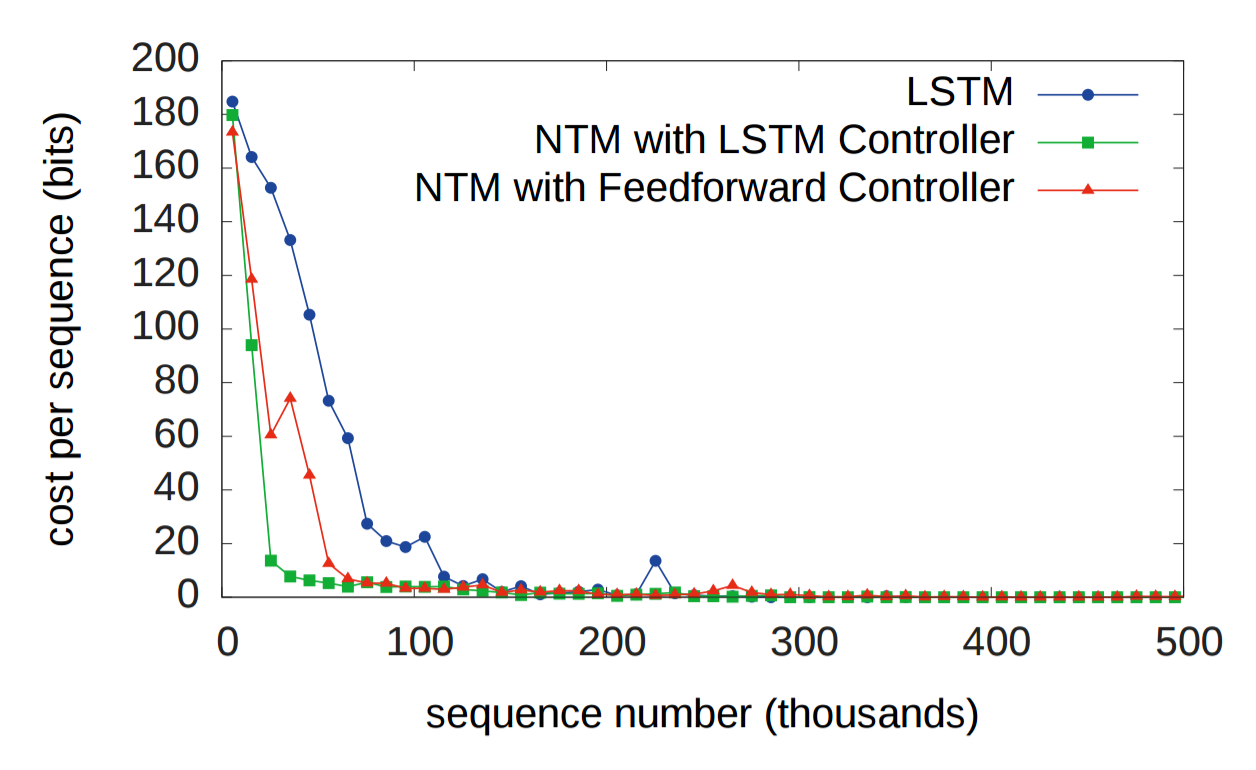

LSTMは 、2つのNTMと比較されます。1つは

LSTMコントローラーを使用し、もう1つは

標準フィードフォワードコントローラーを使用します。 以下のグラフで、「各シーケンスのコスト関数」は、システムがシーケンス全体で誤って再現したビット数を意味します。 ご覧のとおり、両方のNTMアーキテクチャはLSTMよりもはるかに優れています。

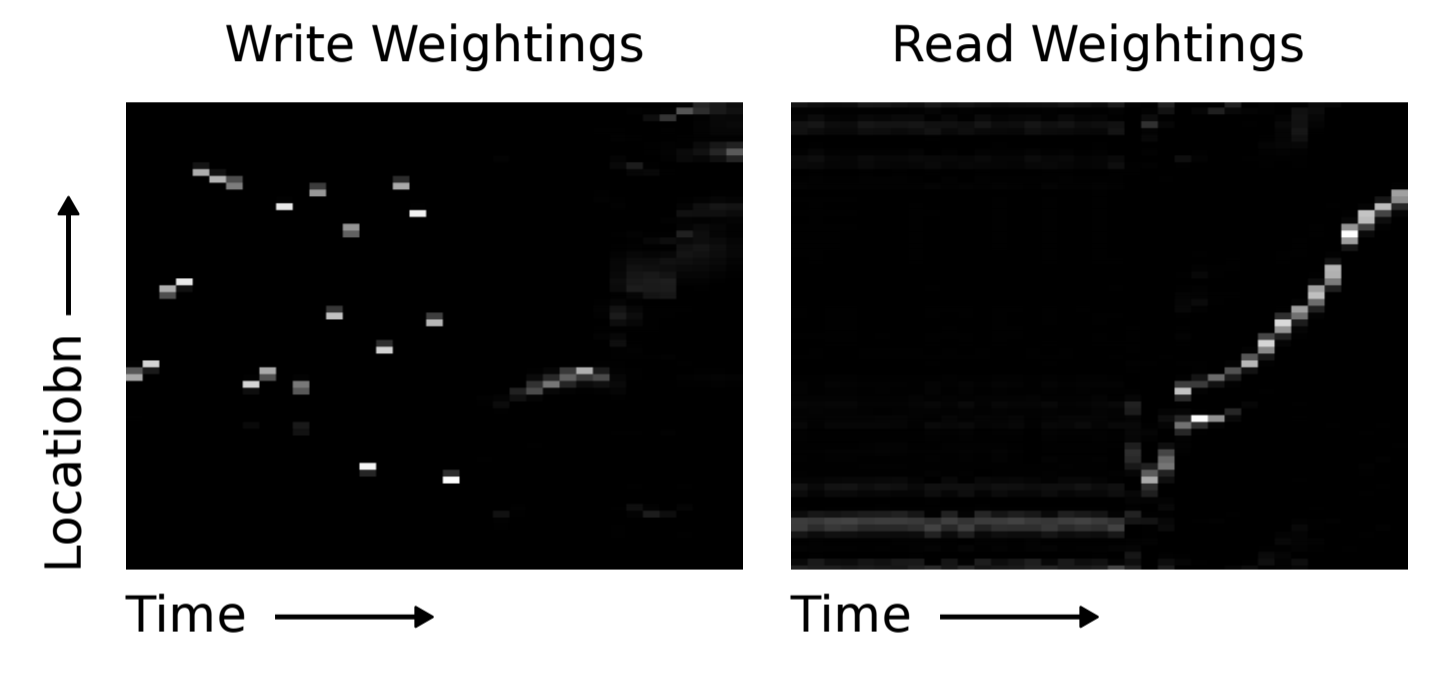

明らかに、LSTMとNTMの両方は、ある種の初歩的なコピーアルゴリズムを学びました。 研究者は、NTMがどのように読み書きするかをグラフ形式で示しました(以下を参照)。 白い色は重み1に対応し、黒は重み0に対応します。この図は、メモリセルの重みが明確に焦点を合わせていることを明確に示しています。

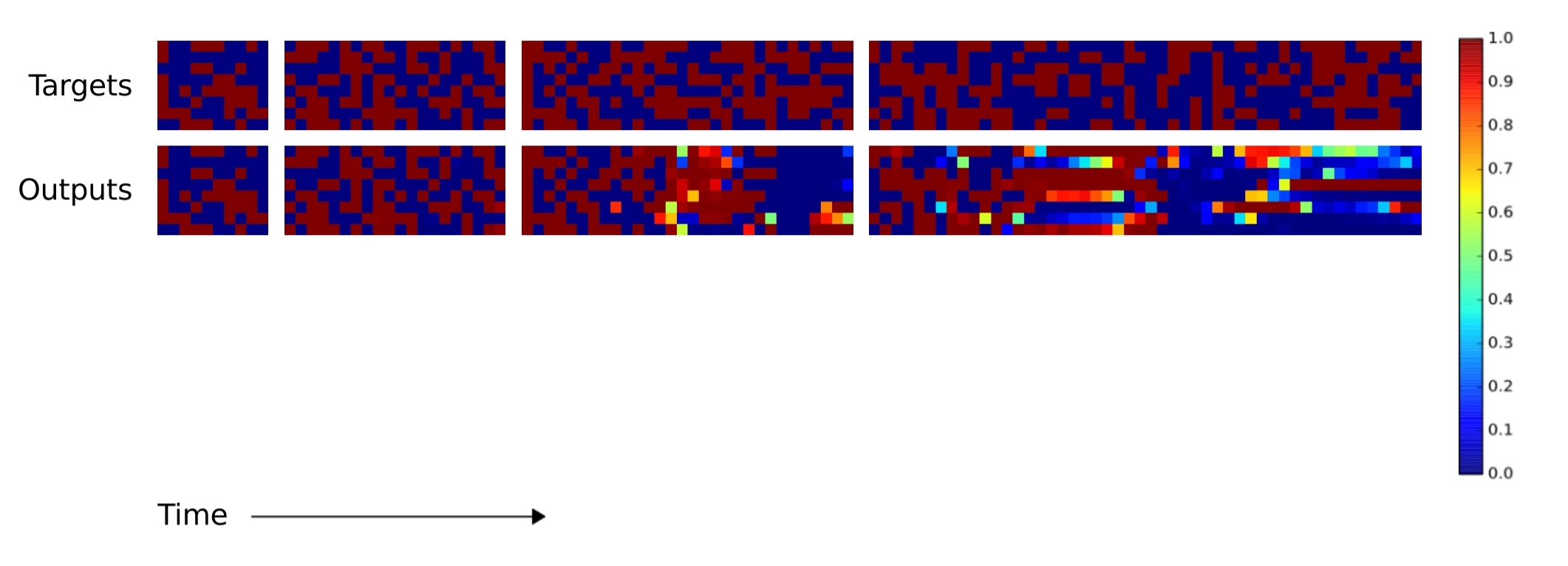

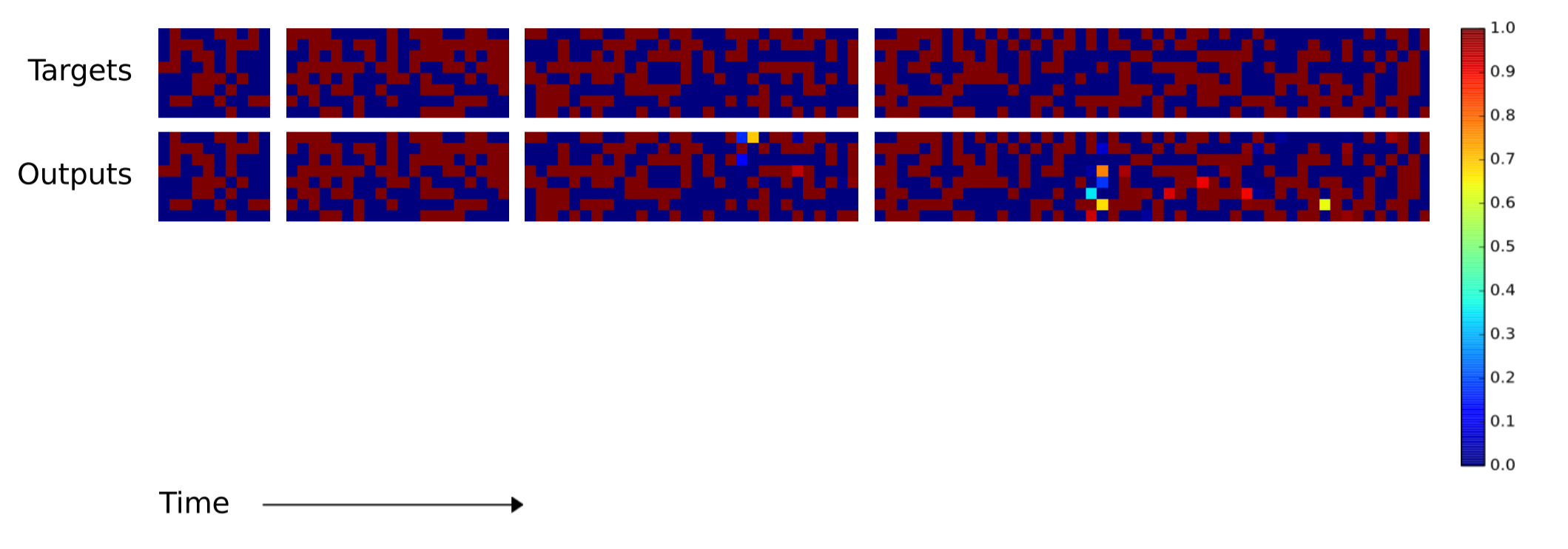

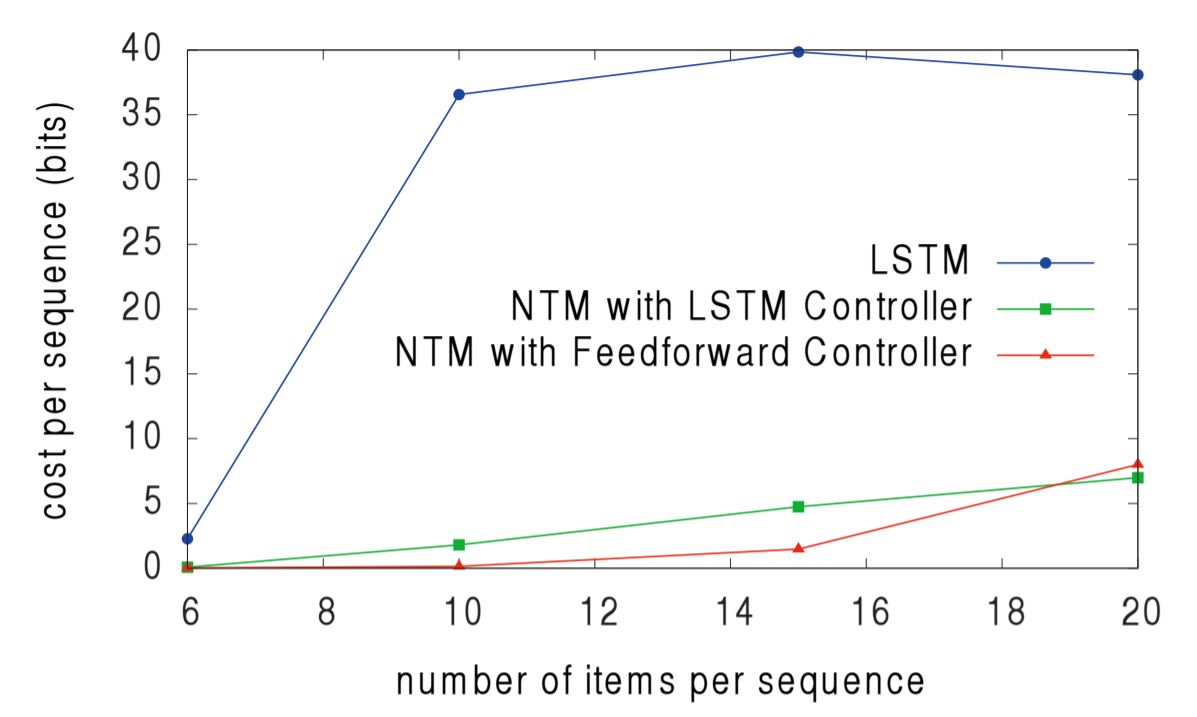

次に、研究者は、LSTMおよびNTMアルゴリズムが、トレーニング対象のすべての入力データよりも長いシーケンスに対してどれだけうまくスケーリングできるかを知りたいと考えました。 トレーニングは1〜20個のランダムなベクトルのシーケンスで行われたため、LSTMとNTMは長さが10、20、30、50、120個のベクトルのシーケンスで比較されました。 次の2つの図には説明が必要です。 8つのブロックがあります。 上の4つのブロックは、シーケンス10、20、30、および50に対応します。各ブロックでは、8つの赤と青の正方形の列を使用して値1と0を視覚化します。明るい色の正方形は0.0〜1.0の値に対応します。

長さが10、20、30、40のシーケンスでのLSTMコピーのパフォーマンス 10、20、30、40のシーケンスでのNTMコピーのパフォーマンス

10、20、30、40のシーケンスでのNTMコピーのパフォーマンス

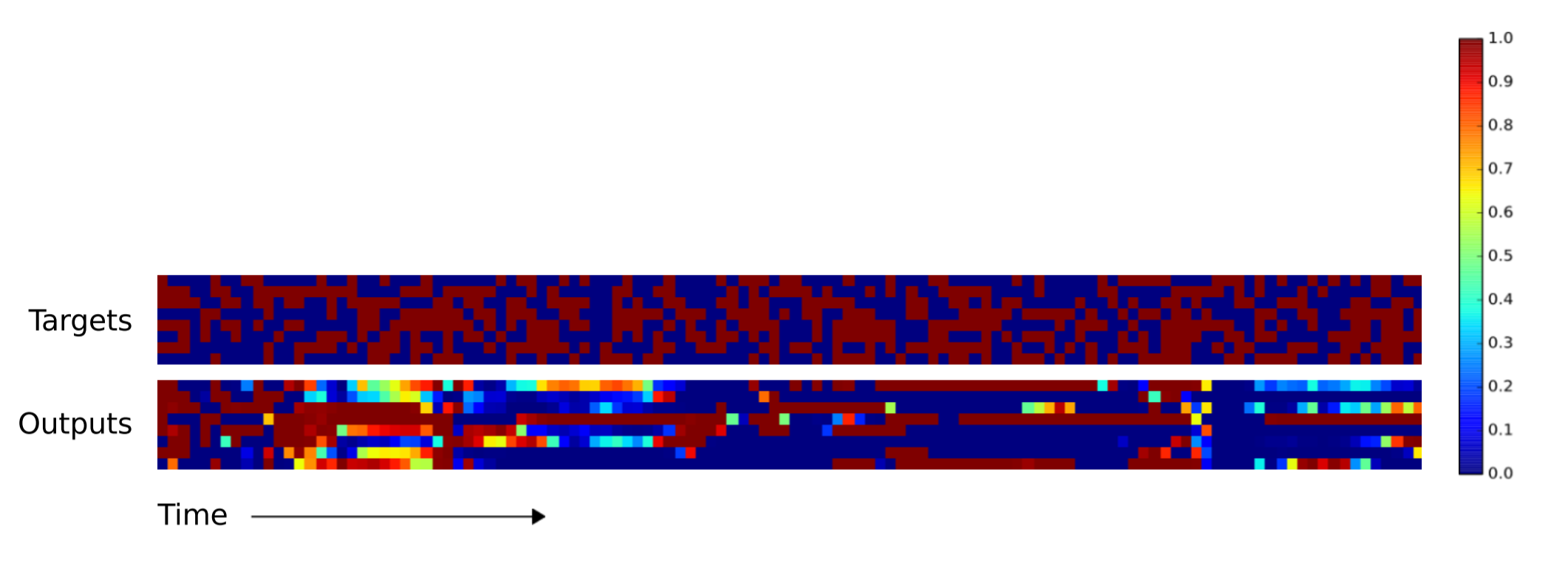

ご覧のとおり、NTMは長いシーケンスでのエラーをはるかに少なくします。 科学的研究では、NTM(RNNコントローラーまたはプロアクティブコントローラー)を使用して上部のこの画像を生成することはできませんでした。 以下に示すように、NTMとLSTMの違いは、シーケンスが120ベクトルに増加するにつれてさらに顕著になります。

長さ120のLSTMのコピーパフォーマンス 120 NTMコピーパフォーマンス

120 NTMコピーパフォーマンス

もう一度コピー

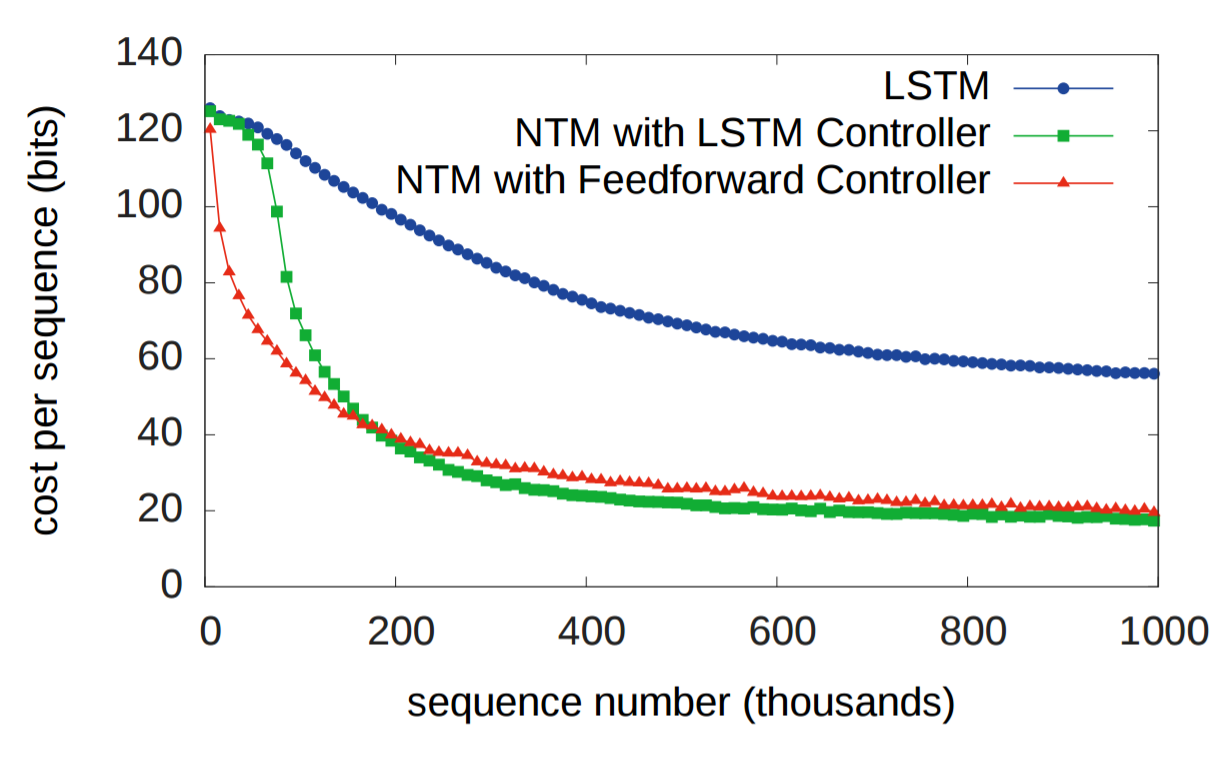

2番目の実験は、NTMがネストされた関数(この場合、ネストされたループ)を学習できるかどうかを判断することでした。 シーケンスに加えて、NTMがコピーされた入力シーケンスを生成する回数に対応するスカラー値もNTMに送信されました。 予想通り、両方のNTMがLSTMよりも優れていました。

前と同様に、LSTMはコピー繰り返しアルゴリズムを一般化することは困難であるとわかりましたが、NTMはそうではありませんでした。

連想データ復旧

3番目の実験は、NTMが間接処理を学習できるかどうか、つまり、あるデータ要素が別のデータ要素を指しているかどうかを判断することでした。 著者は、入力としてアイテムのリストを送信し、リストから1つのアイテムを要求し、次のアイテムがリストから返されるのを待ちました。 著者は、LSTMコントローラを備えたNTMに対するプロアクティブコントローラを備えたNTMの優位性は、NSTMメモリがLSTMの内部状態よりも優れたストレージシステムであることを示していることに注意します。

繰り返しになりますが、NTMは、リスト内の多数のアイテムを要約したときにLSTMよりも優れていました。

ダイナミックN-gram

4番目のタスクは、NTMが

事後予測分布を学習できるかどうかを判断するために設計されました。 研究者はNグラム(N要素のシーケンス)を作成しました。これは、シーケンスの前の要素が取得されたときに、シーケンスの次の要素の特定の確率分布を計算します。 この場合、研究者はバイナリ6グラムを使用しました。 次のビットを予測するエージェントの能力の最適なソリューションは分析ソリューションであり、両方のNTMがLSTMよりも優れており、最適な見積もりに近づいています。

優先ソート

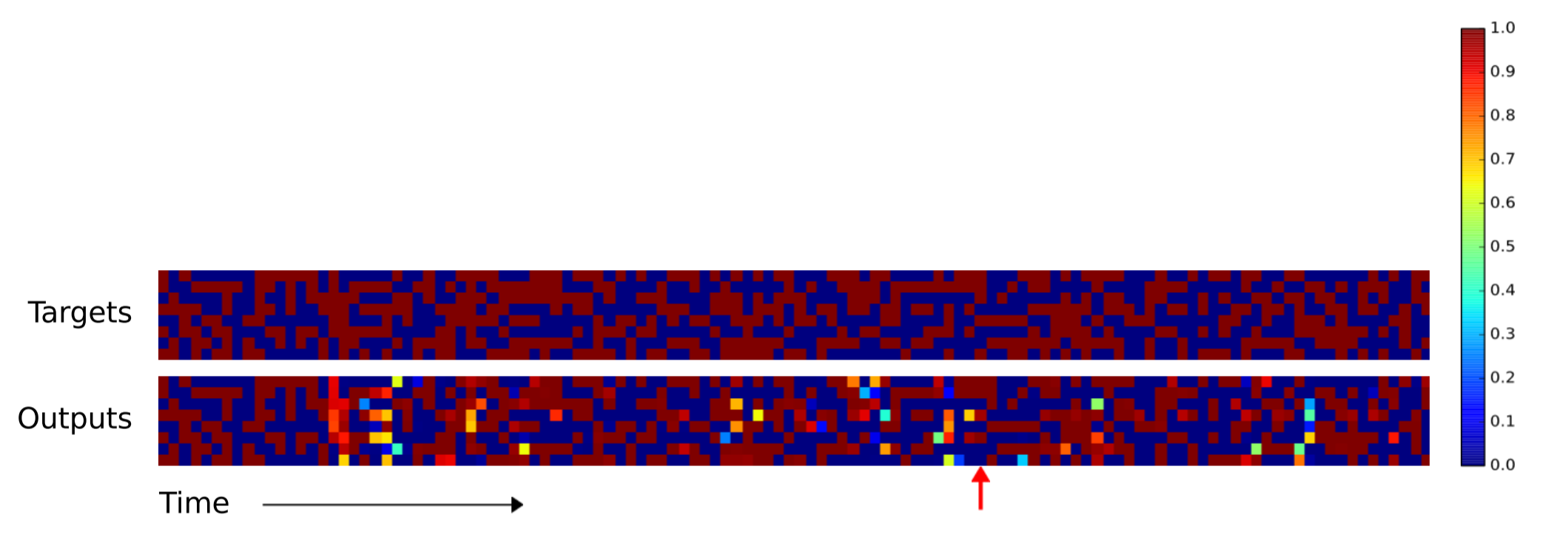

5番目の最後の実験では、NTMがデータのソートを学習できるかどうかをテストしました。 20個のバイナリベクトルには、範囲[-1、1]から均等に選択されたスカラーの「優先度評価」が割り当てられ、各システムのタスクは、入力データから最高の優先度を持つ16個のベクトルを返すことでした。 科学者は、NTMメモリの書き込みおよび読み取り操作を調べた後、NTMが優先順位を使用してベクトルを保存する順序を大まかに推定していることを発見しました。 次に、最高の優先度を持つ16個のベクトルを生成するために、メモリセルが順番に読み取られます。 これは、メモリからの読み取りおよび書き込み操作のシーケンスで確認できます。

また、NTMはLSTMを上回りました。

まとめ

- 脳の作業メモリとデジタルコンピュータアーキテクチャの神経生物学的モデルは、システムの機能が外部メモリの可用性に依存する可能性があることを示唆しています。

- 外部メモリで補完されたニューラルネットワークは、ニューラルネットワークがデータ構造内の特定の場所に値をバインドできないという可変性(変数バインディング)に対する重要な重要な議論への可能な答えを提供します。

- ぼやけた読み取りおよび書き込み操作は微分可能です。 これは、コントローラーがメモリーの使用方法を学習するために重要です。

- 5つのテストの結果は、NTMがLSTMを上回り、LSTMよりも一般的なアルゴリズムを学習できることを示しました。

注釈

フィードバックに感謝します。 私がどこかで間違えた場合や提案がある場合は、

Redditと

HackerNewsについて

書いてください 。 近い将来、メーリングリストを作成し(Benに感謝)、RSSを統合します(Yuriに感謝)。