グリゴリー・サプノフ(インテント)

私の名前はグリゴリー・サプノフです。私はインテント社のサービスステーションです。 私は長い間ニューラルネットワークに携わっており、特に機械学習は道路標識と数字のニューラルネットワーク認識装置の構築に携わっていました。 私は、画像のニューラルネットワークの様式化に関するプロジェクトに参加し、多くの企業を支援しています。

ポイントにまっすぐに行きましょう。 私の目標は、基本的な用語と、この分野で何が起きているのか、ブリックニューラルネットワークの組み立て元、およびその使用方法を理解することです。

レポートの概要は次のとおりです。 最初に、

ニューロンが何であるかについての

簡単な紹介、

ニューラルネットワーク 、

ディープニューラルネットワークを使用して、同じ言語で通信します。

さらに、この分野で起こっている重要な傾向についてお話します。 それから

ニューラルネットワークの

アーキテクチャを掘り下げ、それらの

3つの主なクラスを考えてください。 これが最も重要な部分になります。

その後、2つの比較的高度なトピックを検討し、ニューラルネットワークを操作するため

のフレームワークとライブラリの簡単な

概要で終わります。

会議では、NTechLabのNatalia Efremovaが実際の事例について話しました。 ニューラルネットワークが内部にどのように配置されているか、内部でどのようなブリックが作られているかを説明します。

まとめ

要約:ニューロン、ニューラルネットワーク、ディープニューラルネットワーク

簡単なリマインダー

人工ニューロンは、生体ニューロンに非常に似ています。

人工ニューロンとは何ですか? これは実際には単純な関数です。 彼女にはインプットがあります。 各入力に特定の重みを掛けてから、すべてを合計し、非線形関数を実行し、結果を出力します-すべて、これは1つのニューロンです。

ロジスティック回帰(SIGMOIDの非線形関数を意味する)に精通している場合、1つのニューロンはロジスティック回帰の完全な類似物であり、単純な線形分類器です。

実際、図に示されている双曲線正接(TANH)、SIGMOID、RELUなど、さまざまなアクティベーション関数があります。

現実には、すべてがはるかに複雑です。 このトピックについては触れません。

一種の生物学的ニューロンとして、人工ニューロンの非常に基本的な考えを述べました。

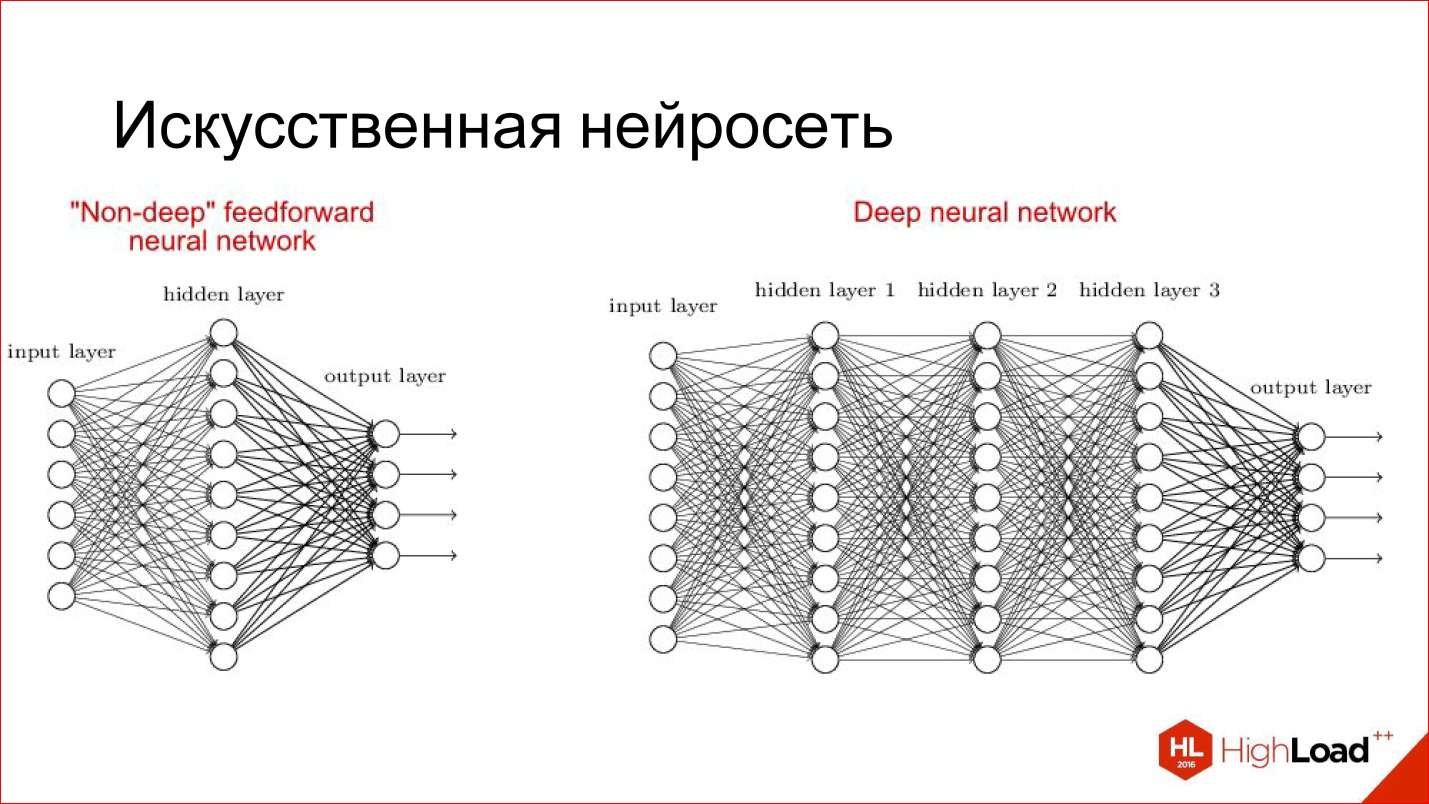

人工ニューラルネットワークは、分類問題などの特定の問題を解決するために、ニューロンをネットワークに収集する方法です。 ニューロンは層状に集まります。 入力信号が供給される入力層、ニューラルネットワークの結果が取得される出力層、およびそれらの間に隠された層があります。 1、2、3、多くあります。 隠れ層が複数ある場合、ニューラルネットワークは深いと見なされ、1の場合は浅いと見なされます。

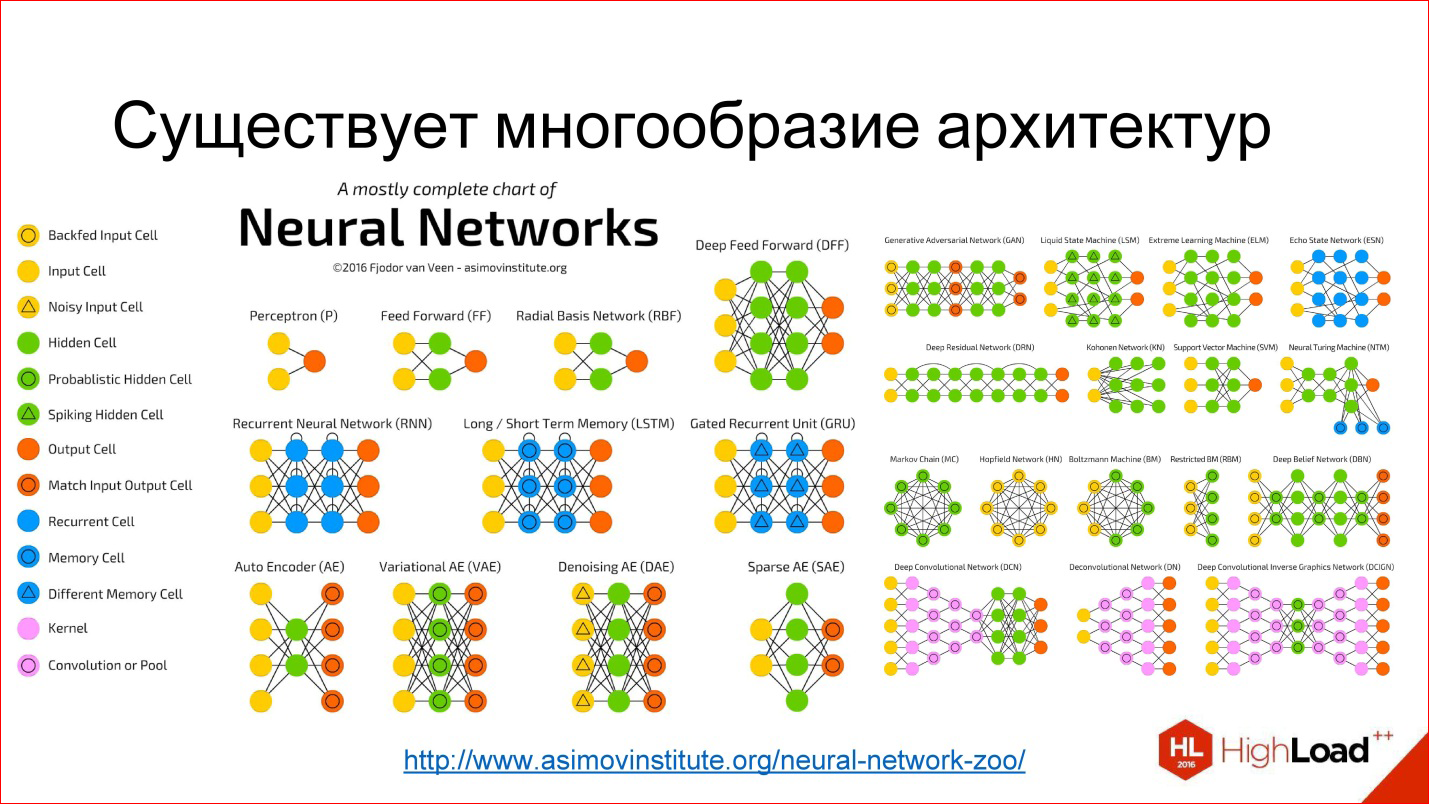

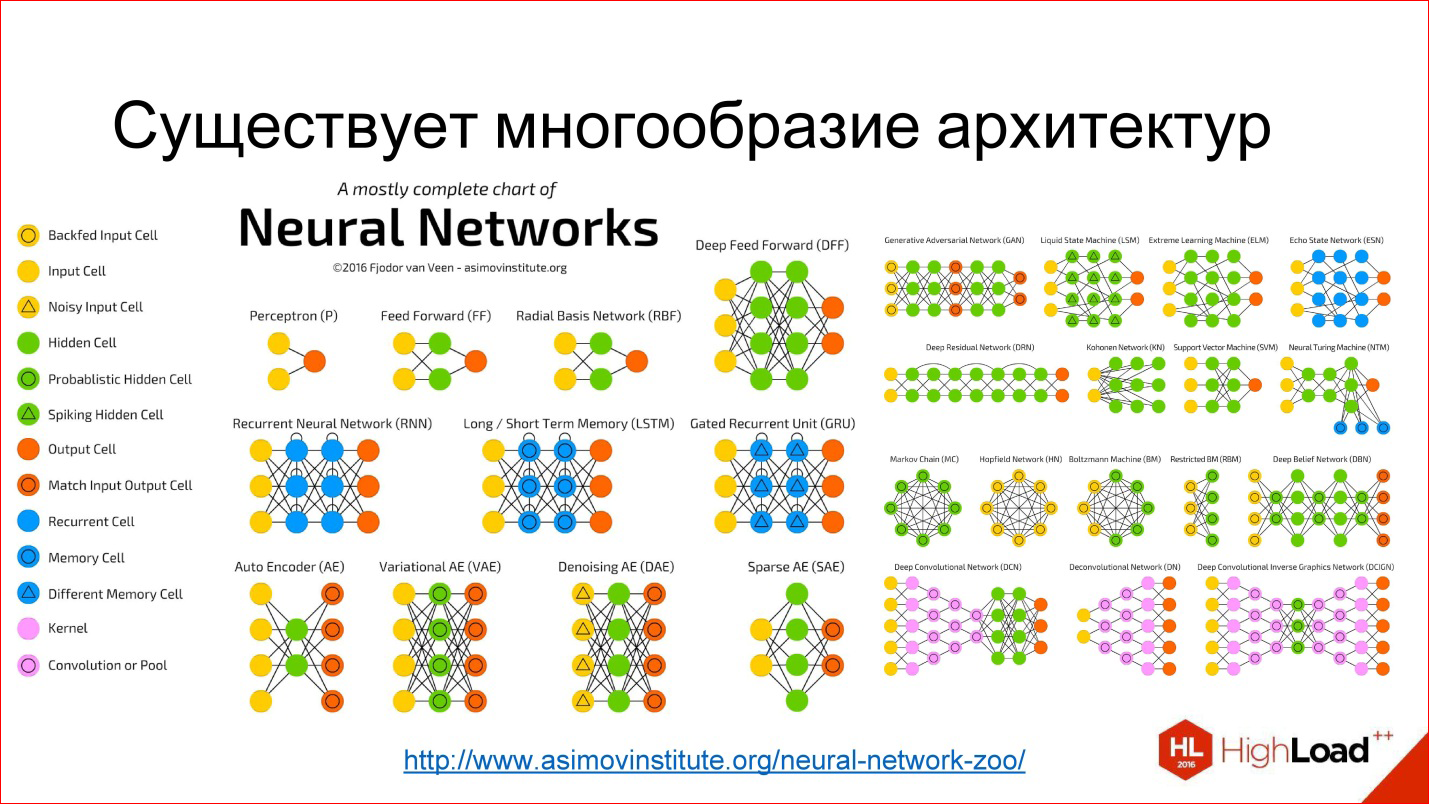

多種多様なアーキテクチャがあり、その主なものを検討します。 しかし、それらの多くがあることに留意してください。 興味がある場合は、

リンクをたどって

ください -ご覧ください。

ニューラルネットワークについて議論するために知っておく必要があるもう1つの有用なこと。 1つのニューロンがどのように機能するかについては既に説明しました。各入力が重み、係数、合計、非線形性を乗算する方法です。 これは、たとえば、ニューロンの生産モード、つまり、推論、すでに訓練された形でどのように機能するかです。

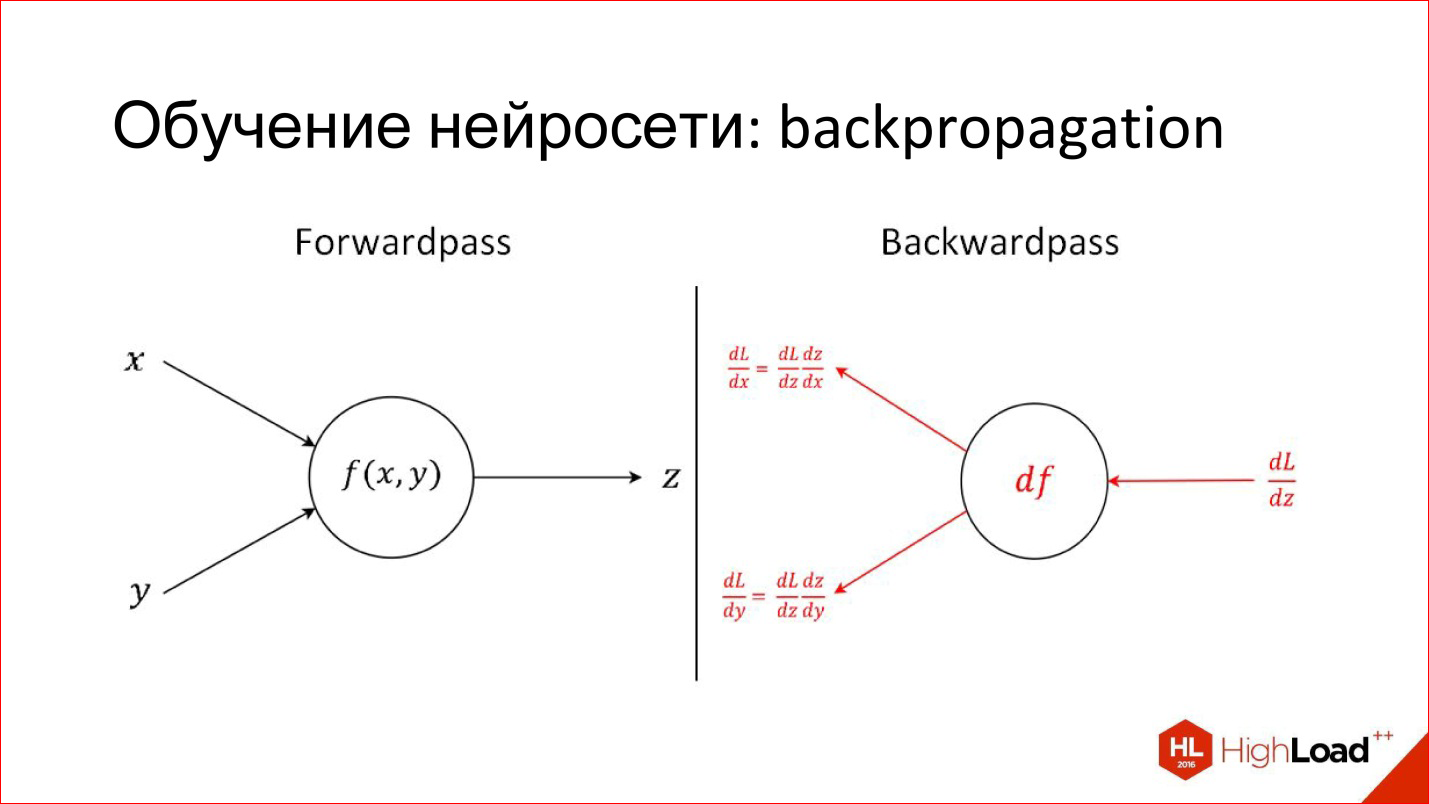

完全に異なるタスクがあります-ニューロンを訓練すること。 トレーニングは、これらの適切な重みを見つけることです。 トレーニングは、ニューロンの出力で答えがどうあるべきか、そして何が判明したかを知ると、この違い、エラーを認識するという単純な考えに基づいています。 このエラーは、ニューロンのすべての入力に送り返され、どの入力がこのエラーに大きな影響を与えたかを理解できます。したがって、この入力の重みを調整して、エラーを減らします。

これが、バックプロパゲーションアルゴリズムであるバックプロパゲーションの主なアイデアです。 このプロセスは、ネットワーク全体で、ニューロンごとに駆動して、重みを変更する方法を見つけることができます。 このためには、デリバティブを取る必要がありますが、原則として、最近ではこれは必要ありません。 ニューラルネットワークを操作するためのすべてのパッケージは、自動的に区別されます。 2年前にトリッキーなレイヤーの複雑な派生物を手動で記述する必要があった場合、パッケージはそれを自分で行います。

要約:重要なトレンド

モデルの品質と複雑さで何が起こっているのか

第一に、ニューラルネットワークの精度が向上し、非常に向上しています。 ニューラルネットワークがある領域に来て、古典的なアルゴリズムに完全に取って代わる場合、すでにいくつかの例があります。 これはすでに画像処理と音声認識で発生しており、さまざまな分野で発生します。 つまり、エラーを大幅に減らすニューラルネットワークが表示されます。

図では、ディープラーニングが紫色で強調表示され、青色が古典的なコンピュータービジョンアルゴリズムです。 ディープラーニングが表示され、エラーが減少し、さらに減少し続けていることがわかります。 そのため、ディープラーニングは、条件付きですべての古典的なアルゴリズムを完全に置き換えます。

もう1つの重要なマイルストーンは、品質の面で人を追い越し始めることです。 ImageNetでは、これが2015年に初めてでした。 しかし実際には、人間よりも品質に優れたニューラルネットワークシステムが以前に登場しました。 最初に文書化された個別のケースは2011年で、ドイツの道路標識を認識し、人よりも2倍優れたシステムが構築されました。

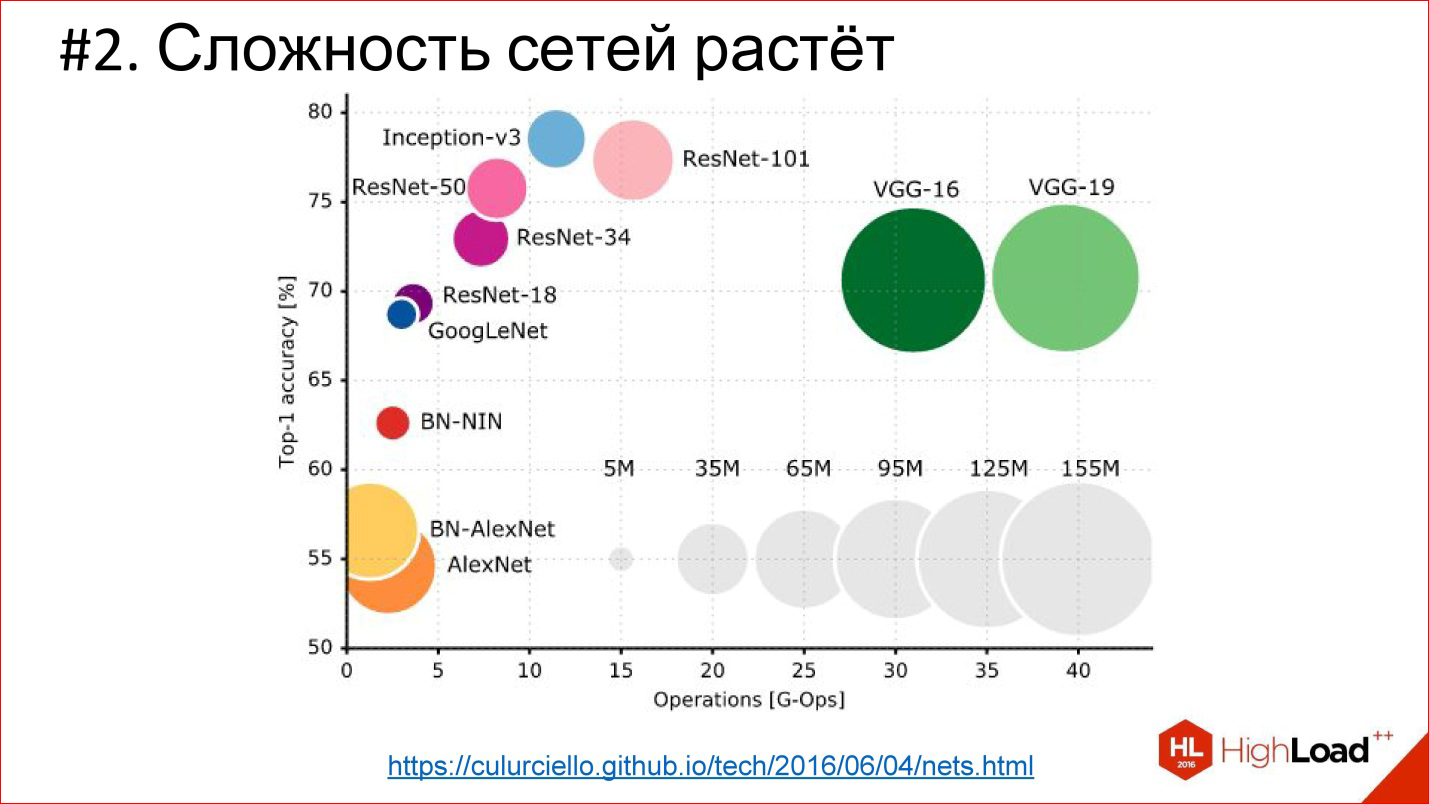

2番目の重要な傾向-ニューラルネットワークの複雑さが増大しています。 深さに関しては、深さが大きくなります。 ImageNetで2012年の勝者(AlexNetネットワーク)が10層未満だった場合、2014年には2015年にはすでに20を超え、150未満でした。今年は既に200を超えているようです。さらにあります。

http://cs.unc.edu/~wliu/papers/GoogLeNet.pdf

http://cs.unc.edu/~wliu/papers/GoogLeNet.pdf深さの増大に加えて、アーキテクチャ自体が複雑化しています。 レイヤーを1つずつ結合するのではなく、分岐、ブロック、構造が現れ始めます。 一般に、アーキテクチャの複雑さも増大しています。

https://culurciello.imtqy.com/tech/2016/06/04/nets.html

https://culurciello.imtqy.com/tech/2016/06/04/nets.htmlこれは、さまざまなニューラルネットワークの精度のグラフです。 これは、実行にかかる時間、このネットワークの誤計算、つまりある種の計算負荷を示します。 円のサイズは、ニューラルネットワークによって記述されるパラメーターの数です。 2012年以降のネットワークの勝者である従来のネットワークAlexNetを比較するのは興味深いことです。 精度は向上しますが、通常含まれるパラメーターは少なくなります。 これは、ニューラルネットワークが非常に洗練されているという重要な傾向でもあります。 つまり、アーキテクチャが変更されているため、レイヤーの数が150であっても、パラメーターの合計数は2012年の6-7レイヤーネットワークよりも少なくなります。 アーキテクチャは非常に興味深い方法で何らかの形で複雑になっています。

別の傾向は、データ量の増加です。 1998年に畳み込みトレーニング用

手書きのチェックを認識するニューラルネットワーク、10

7ピクセルが2012年に使用されました(IMAGENET)-10

14 。

14年で7注文-これは大きな違いであり、大きな変化です!

同時に、プロセッサでの通過数も増え、計算能力が向上しています-ムーアの法則が有効です。 この14年間で、プロセッサは条件付きで1000倍高速になりました。 これは、現在ディープラーニングの分野を支配しているGPUによって示されています。 ほとんどすべてがグラフィックアクセラレータでカウントされます。

NVIDIAは、ゲーム会社から人工知能の会社に変身しました。 その出展者は、Intelの出展者を大きく引き離しました。

これは、トップエンドのグラフィックカードが4.5 TFLOPSだった2013年の写真です。 現在、新しいTITAN Xはすでに11 TFLOPSです。 一般的に、出展者は継続します!

実際、近い将来にFPGAが登場し、GPUが部分的に置き換えられることが予想されます。また、ニューロモーフィックプロセッサでさえ時間がたてば登場する可能性があります。 これを追跡してください-興味深いこともたくさんあります。

ニューラルネットワークのアーキテクチャ。 直接分布ニューラルネットワーク

完全に接続されたフィードフォワードニューラルネットワーク、FNN

最初の古典的なアーキテクチャは、直接リンクの完全に接続されたニューラルネットワーク、または完全に接続されたフィードフォワードニューラルネットワーク(FNN)です。

多層パーセプトロンは通常、ニューラルネットワークの古典です。 あなたが見たニューラルネットワークの画像、これはそれです-多層完全接続ネットワーク。 完全に接続-これは、各ニューロンが前の層のすべてのニューロンに接続されていることを意味します。 良好なネットワークが機能し、分類に適しています。多くの分類問題が正常に解決されます。

ただし、彼女には2つの問題があります。

たとえば、100 * 100 psの画像を処理する必要がある3つの隠れ層のニューラルネットワークを使用する場合、これは入力に10,000 psがあり、3つの層で起動することを意味します。 一般に、すべてのパラメーターに正直に言うと、このようなネットワークには約100万のパラメーターがあります。 これは実際にはたくさんあります。 100万個のパラメーターを使用してニューラルネットワークをトレーニングするには、常に存在するとは限らない多くのトレーニングサンプルが必要です。 実際、今では例がありますが、例はありませんでした。したがって、特に、ネットワークは適切にトレーニングできませんでした。

さらに、多くのパラメータを持つネットワークには、再トレーニングする傾向があります。 現実には存在しないもの、つまりノイズデータセットに閉じ込められる可能性があります。 たとえ最終的にネットワークが例を覚えていても、それが見えなかった場合は、ネットワークを通常どおり使用することはできません。

さらに、別の問題があります:

出力からのエラーが入力に送信され、すべての重みに分配され、ネットワークを介してさらに送信されるときの、バックプロパゲーションに関する話を覚えていますか? さらに、これらの導関数、つまり勾配(誤差の導関数)は、ニューラルネットワークを介して戻されます。 ニューラルネットワークに多くの層がある場合、非常に非常に小さな部分が最後のこの勾配から残ることがあります。 この場合、この勾配は実際には「死んでいる」ため、入力の重みを変更することはほとんど不可能です。

これも問題です。その理由は、ディープニューラルネットワークも訓練するのが難しいからです。 特にリカレントネットワークについては、このトピックに戻ります。

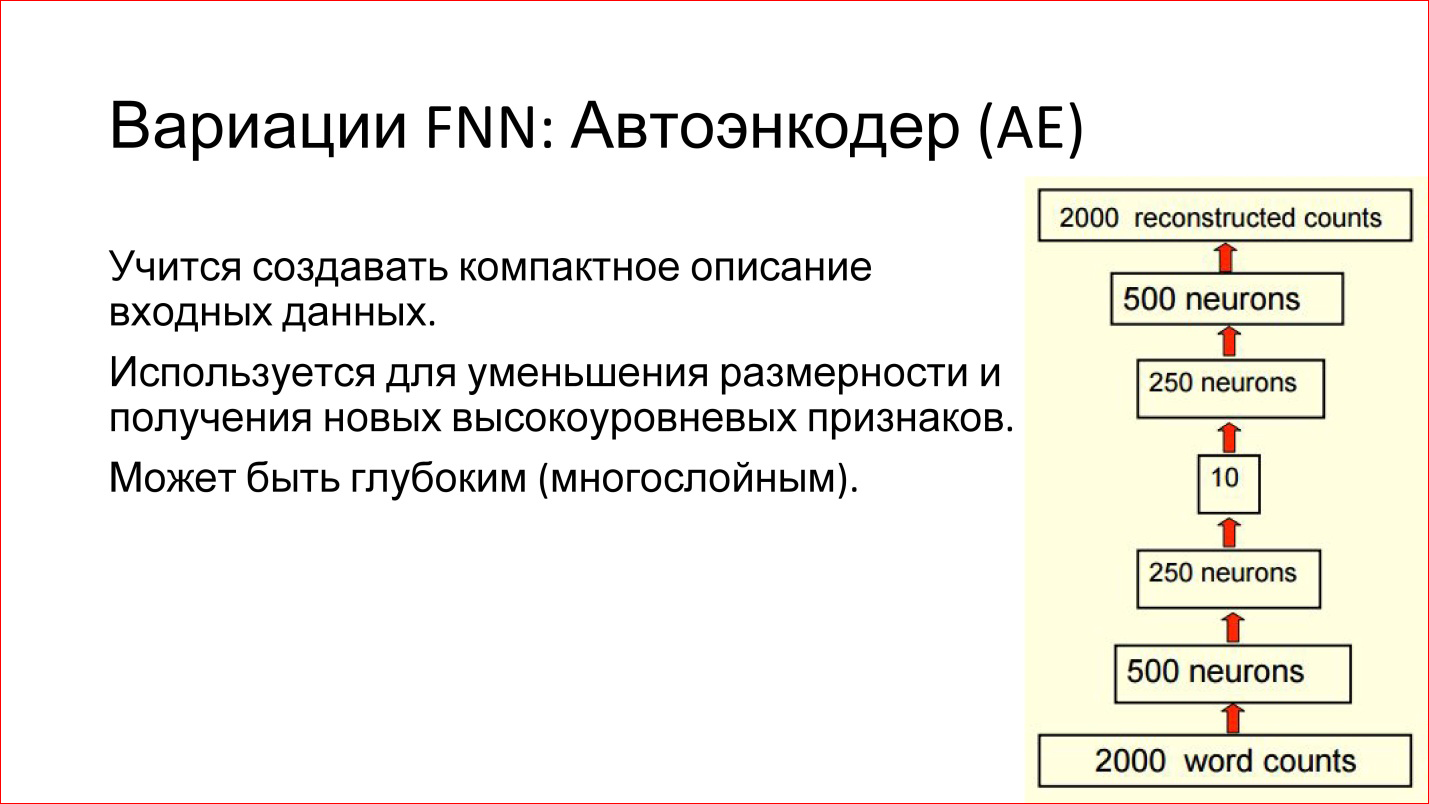

FNNネットワークにはさまざまなバリエーションがあります。 たとえば、Auto Encoderの非常に興味深いバリエーションです。 これは、いわゆるボトルネックが真ん中にある直接配信ネットワークです。 これは非常に小さい層で、たとえば10個のニューロンのみです。

このようなニューラルネットワークの利点は何ですか?

このニューラルネットワークの目的は、何らかの入力を取得し、それを介してそれを駆動し、出力で同じ入力を生成することです。つまり、一致します。 ポイントは何ですか? 入力を受け取り、それ自体を駆動し、まったく同じ出力を生成するようなネットワークをトレーニングできる場合、これは、この10個のニューロンがこの入力を記述するのに十分であることを意味します。 つまり、スペースを大幅に削減し、データ量を削減し、入力データを10個のベクトルという新しい条件で経済的にエンコードできます。

それは便利で動作します。 このようなネットワークは、たとえば、タスクの規模を縮小したり、使用できる興味深い機能を見つけたりするのに役立ちます。

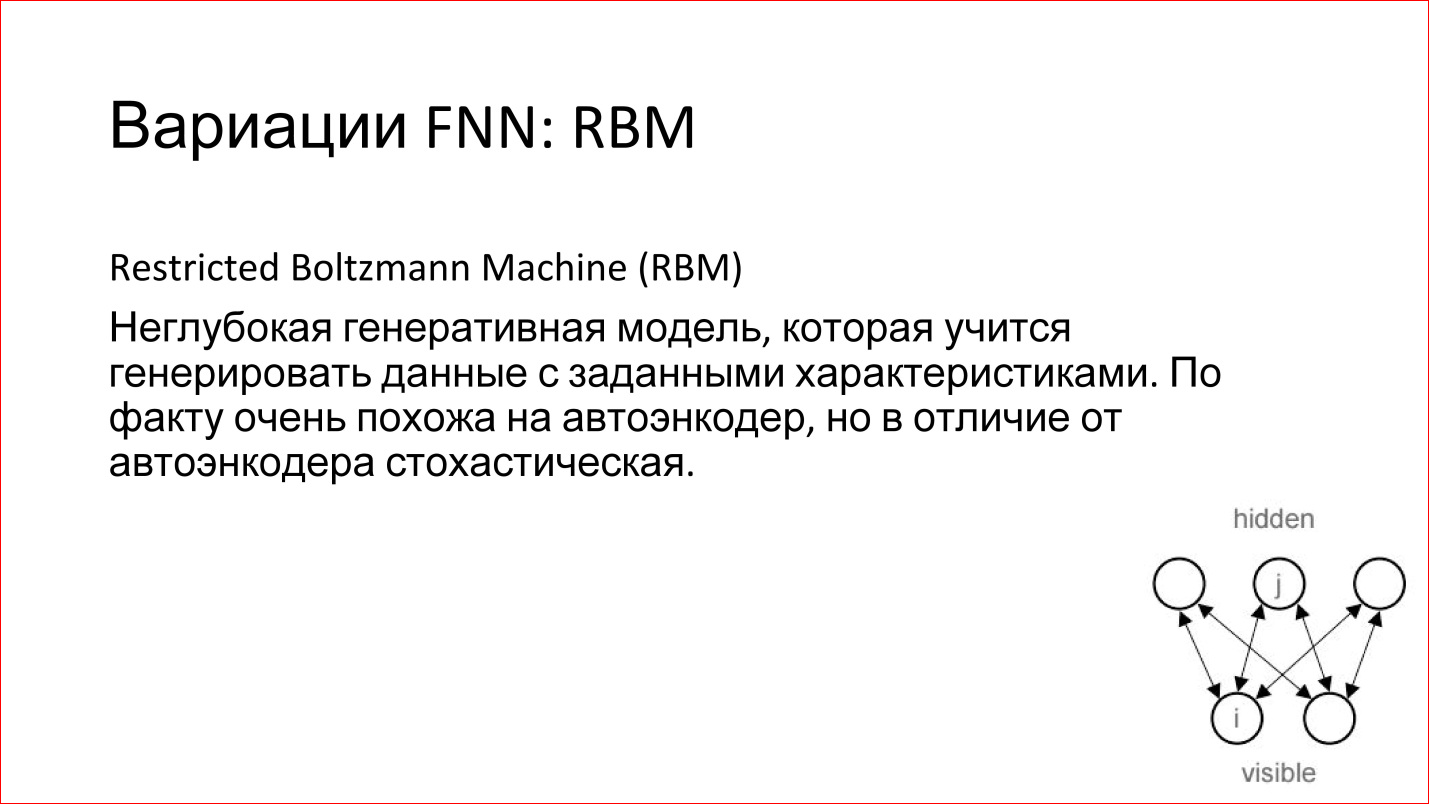

興味深いRBMモデルがまだあります。 私はFNNのバリエーションでそれを書きましたが、実際はそうではありません。 第一に、それは深くなく、第二に、フィードフォワードではありません。 ただし、多くの場合、FNNネットワークに関連付けられています。

これは何ですか

これは浅いモデル(スライドの隅に描かれています)で、入力があり、何らかの隠しレイヤーがあります。 入力信号を与え、この入力を生成するように隠れ層を訓練しようとします。

これは生成モデルです。 彼女を訓練した場合、後で入力信号のアナログを生成できますが、わずかに異なります。 それは確率的です。つまり、毎回少しずつ異なるものを生成します。 たとえば、手書きのユニットを生成するようにそのようなモデルをトレーニングした場合、一定量のわずかに異なるユニットが生成されます。

RBMの優れている点は、RBMを使用して深いネットワークをトレーニングできることです。 そのような用語があります-Deep Belief Networks(DBN)-実際、これは深いネットワークのトレーニングの方法です。 その後、これらの重みは修正されます。 次に、2番目のレイヤーが取得され、別のRBMと見なされ、同じ方法でトレーニングされます。 など、ネットワーク全体で。 次に、これらのRBMが結合され、1つのニューラルネットワークに結合されます。 ディープニューラルネットワークであることが判明しました。

しかし、今では大きな利点があります-単にランダム(ランダム)状態からトレーニングした場合、今ではランダムではありません-ネットワークは、前のレイヤーからデータを復元または生成するようにトレーニングされています。 つまり、彼女の重みは合理的であり、実際には、これはそのようなニューラルネットワークが実際に非常によく訓練されているという事実につながります。 その後、いくつかの例で少し訓練することができ、そのようなネットワークの品質は良好です。

さらに、追加の利点があります。 RBMを使用する場合、基本的には、教師なし学習と呼ばれる未割り当てデータで作業します。 あなたは写真しか持っていません、あなたは彼らのクラスを知りません。 Flickrまたは他の場所からダウンロードした数百万、数十億の写真を追い出し、これらの写真を記述するネットワーク自体に何らかの構造があります。

あなたはまだそれが何であるかを知りませんが、これらはあなたがそれからあなたが撮って、そして少数の異なる写真で再訓練することができる合理的な重みです、そしてそれはすでに良いでしょう。 これは、2つのニューラルネットワークの組み合わせを使用するクールな方法です。

さらに、このストーリー全体が実際にはレゴに関するものであることがわかります。 つまり、個別のネットワーク(リカレントニューラルネットワーク、その他のネットワーク)があり、これらはすべて結合可能なブロックです。 それらは異なるタスクでうまく組み合わされます。

これらは、古典的な直接分布ニューラルネットワークでした。 次に、畳み込みニューラルネットワークに移ります。

ニューラルネットワークアーキテクチャ:畳み込みニューラルネットワーク

畳み込みニューラルネットワーク、CNN

https://research.facebook.com/blog/learning-to-segment/

https://research.facebook.com/blog/learning-to-segment/畳み込みニューラルネットワークは、3つの主なタスクを解決します。

- 分類。 あなたは写真を提出すると、ニューラルネットワークは言うだけです-あなたは犬、馬、何かについての写真を持っています、そしてそれはクラスを与えます。

- ニューラルネットワークが画像内に犬または馬がいると言うだけでなく、画像内の境界ボックスも検出する場合、 検出はより高度なタスクです。

- セグメンテーション。 私の意見では、これは最もクールなタスクです。 実際、これはピクセルごとの分類です。 ここでは、画像内のすべてのピクセルについて説明しています。このピクセルは犬、このピクセルは馬、そしてこのピクセルは何か他のものを指します。 実際、セグメンテーションの問題を解決する方法を知っていれば、残りの2つのタスクはすでに自動的に与えられています。

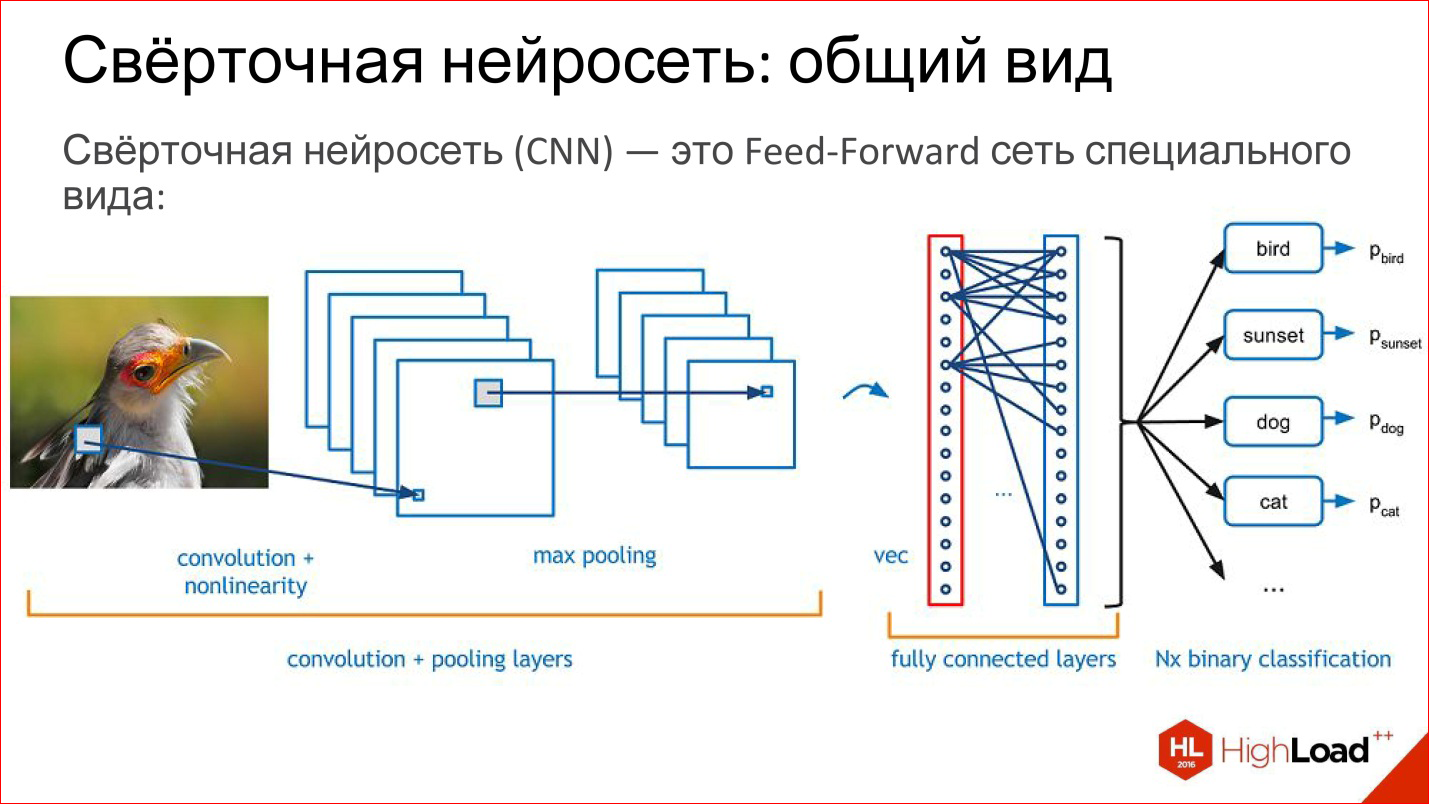

たたみ込みニューラルネットワークとは何ですか? 実際、畳み込みニューラルネットワークは通常のフィードフォワードネットワークであり、ほんの少し特別なものです。 レゴはすでに始まっています。

畳み込みネットワークには何がありますか? 彼女が持っている:

- 畳み込み層-それが何であるかをさらに説明します。

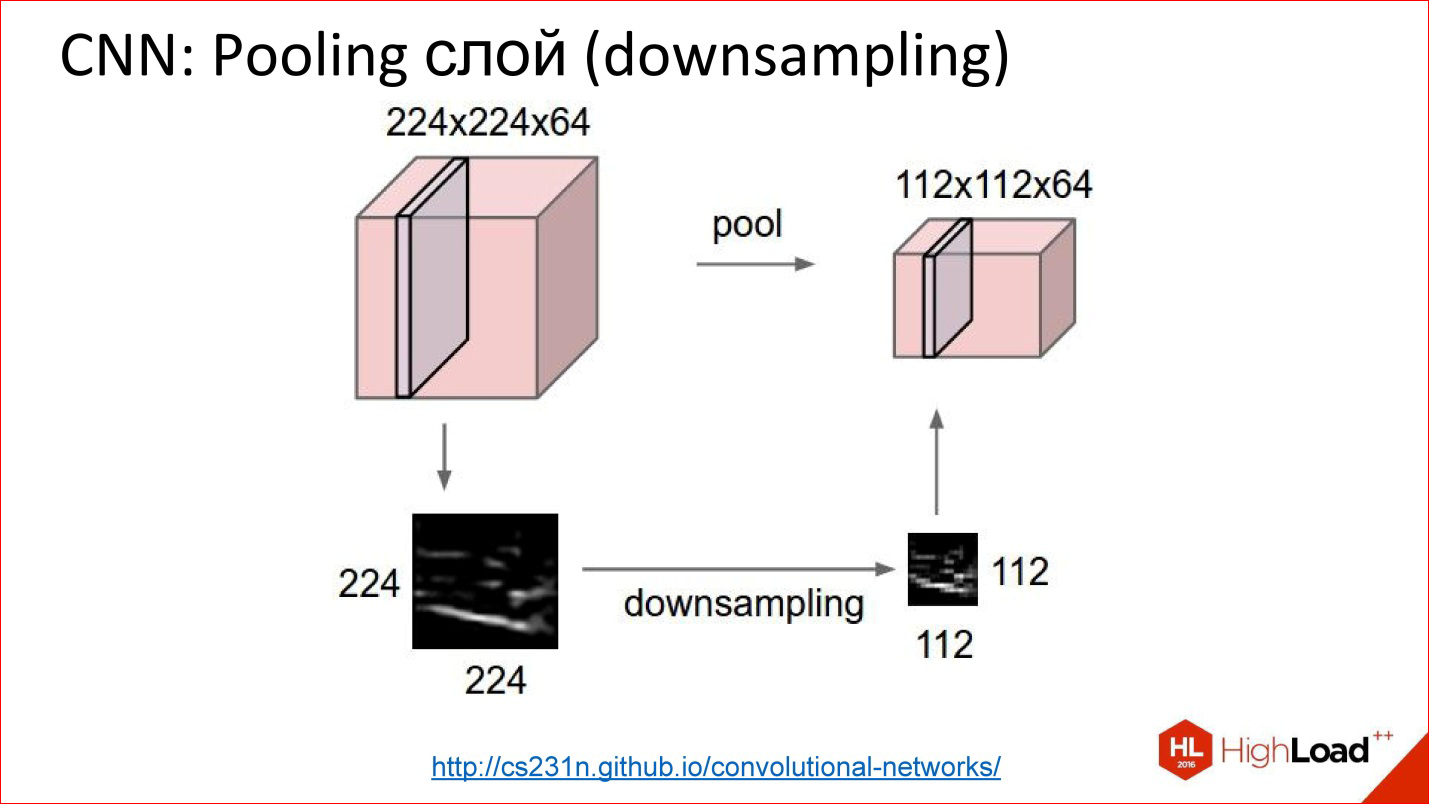

- 画像サイズを縮小するサブサンプリングまたはプーリング層。

- 通常の完全に接続された層、同じ多層パーセプトロン。これらは最初の2つのトリッキーな層に単純に上からぶら下がっています。

これらすべてのレイヤーについてもう少し詳しく説明します。

- 畳み込み層は通常、平面またはボリュームのセットとして描画されます。 このような図の各プレーンまたはこのボリュームの各スライスは、実際には、畳み込み演算を実装する1つのニューロンです。 繰り返しになりますが、後で説明します。 実際、これは元の画像を他の画像に変換するマトリックスフィルターであり、これは何度も実行できます。

- サブサンプリングレイヤー (サブサンプリングと呼びます)は単純に画像サイズを縮小します:200 x 200 psでしたが、サブサンプリング後は100 * 100 psになりました。 実際、平均化は少し複雑です。

- 通常、パーセプトロンは分類のために完全に接続されたレイヤーを使用します。 それらについて特別なことは何もありません。

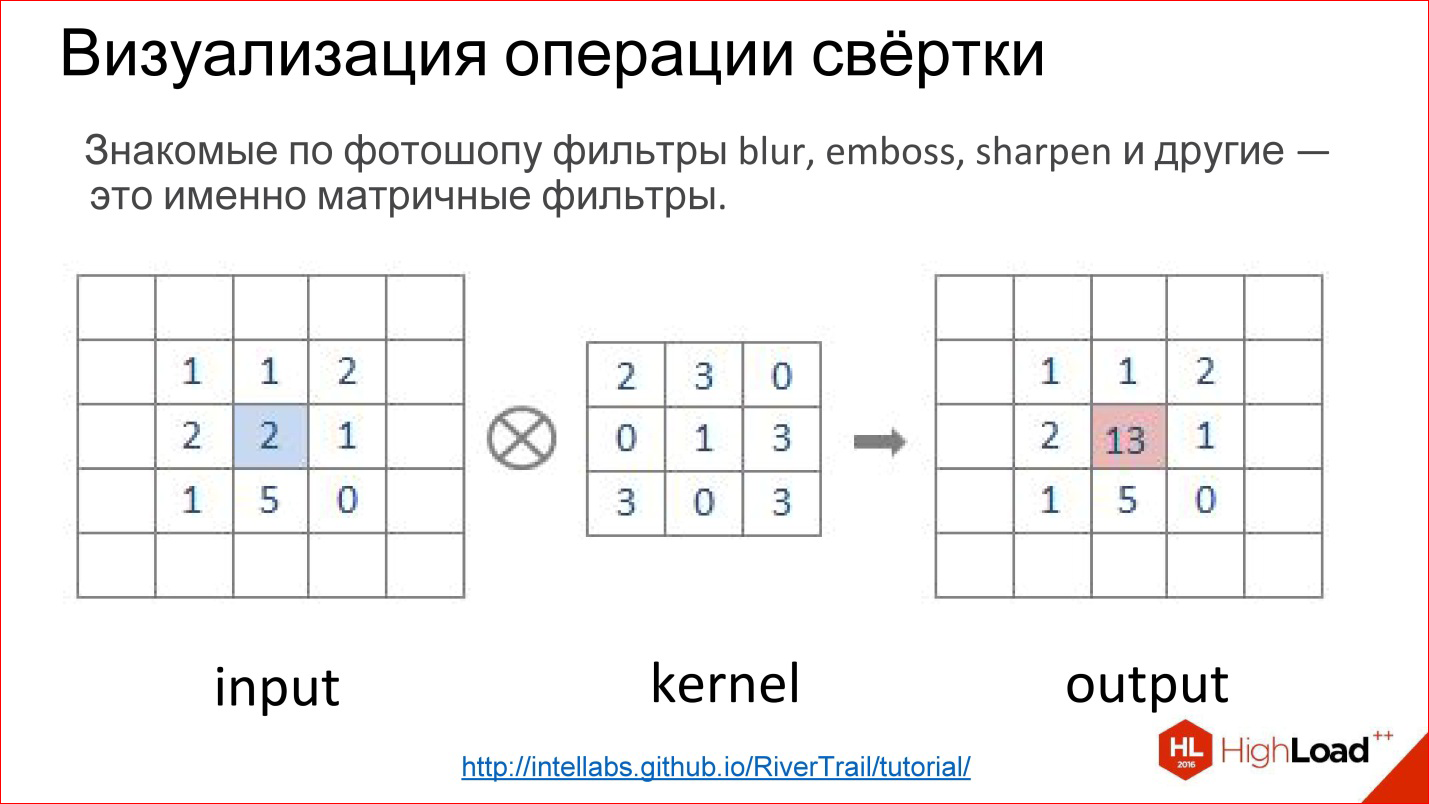

http://intellabs.imtqy.com/RiverTrail/tutorial/

http://intellabs.imtqy.com/RiverTrail/tutorial/畳み込み演算とは何ですか? それは皆を怖がらせますが、実際には非常に簡単なことです。 Photoshopで作業し、Gaussian Blur、Emboss、Sharpen、その他多数のフィルターを使用した場合、これらはすべてマトリックスフィルターです。 マトリックスフィルター-これは実際には畳み込み演算です。

どのように実装されていますか? フィルターコアと呼ばれるマトリックスがあります(カーネルピクチャ内)。 ぼかしの場合、すべてのユニットになります。 画像があります。 このマトリックスは画像の一部に重ねられ、対応する要素が単純に乗算され、結果が追加されて中心点に書き込まれます。

http://intellabs.imtqy.com/RiverTrail/tutorial/

http://intellabs.imtqy.com/RiverTrail/tutorial/そのため、より明確に見えます。 画像入力があり、フィルターがあります。 画像全体にフィルターを実行し、対応する要素を正直に乗算し、中央に追加、書き込みます。 実行、実行-新しいイメージを作成しました。 これは畳み込み演算です。

つまり、実際には、畳み込みニューラルネットワークの畳み込みは、彼が学習するトリッキーなデジタルフィルター(Blur、Embossなど)です。

http://cs231n.imtqy.com/convolutional-networks/

http://cs231n.imtqy.com/convolutional-networks/実際、畳み込み層はすべてボリュームで機能します。 つまり、通常のRGB画像を撮影しても、すでに3つのチャネルがあります。これは、実際には平面ではなく、条件付きで3つの立方体です。

この場合の畳み込みは、マトリックスではなく、テンソル、実際は立方体で表されます。

フィルターがあり、イメージ全体を実行すると、すぐに3つのカラーレイヤーすべてが表示され、この1つのボリュームに対して1つの新しいポイントが生成されます。 イメージ全体を実行します-1つのチャネル、新しいイメージの1つの平面を構築します。 5つのニューロンがある場合、5つのプレーンを構築しています。

これが畳み込み層の仕組みです。 畳み込み層をトレーニングするタスクは、通常のニューラルネットワークと同じタスクです。つまり、重みを見つけること、つまり、ニューロンの重みと完全に等しい非常に畳み込み行列を実際に見つけることです。

そのようなニューロンは何をしますか? 彼らは実際に、いくつかの機能、彼らが見るその小さな部分のいくつかのローカルサインを探すことを学びます-それがすべてです。 このようなフィルターを実行すると、画像内のこれらの標識の位置のマップが作成されます。

次に、このようなプレーンを多数作成し、それらを画像として使用して、次の入力に適用します。

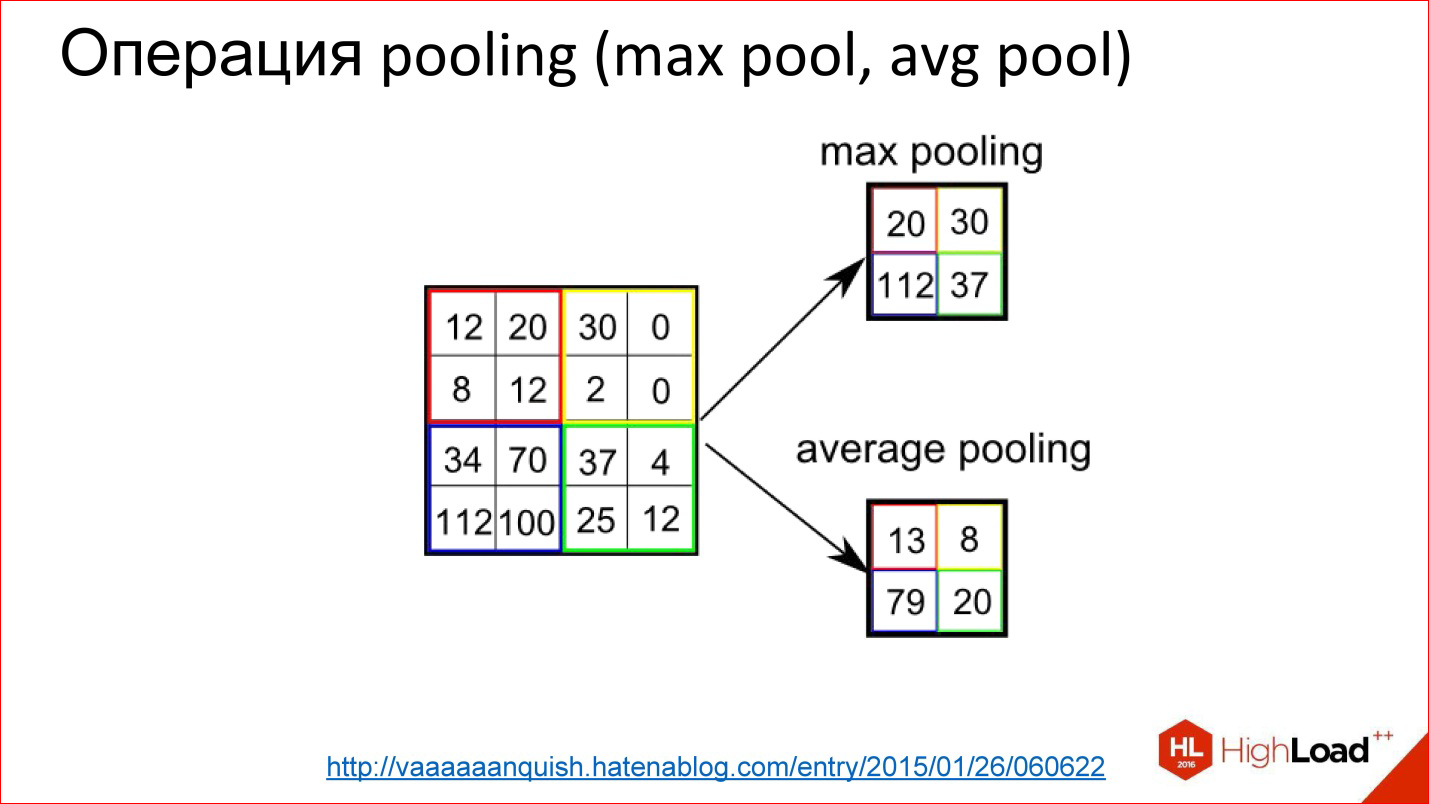

http://vaaaaaanquish.hatenablog.com/entry/2015/01/26/060622

http://vaaaaaanquish.hatenablog.com/entry/2015/01/26/060622プーリングはさらに簡単な操作です。 これは単純に平均化するか、最大値を取ることです。 また、2 * 2などのいくつかの小さな正方形でも機能します。 画像にスーパーインポーズし、たとえば、この2 * 2ボックスから最大要素を選択して、出力に送信します。

したがって、画像を縮小しましたが、トリッキーな平均ではなく、わずかに高度なものを使用して-最大値を取りました。 これにより、わずかな変位不変性が得られます。 つまり、あなたにとっては問題ではありません。この位置または右側2 psに何らかの兆候が見つかりました。 このことにより、ニューラルネットワークはイメージシフトに対する耐性がわずかに高くなります。

http://cs231n.imtqy.com/convolutional-networks/

http://cs231n.imtqy.com/convolutional-networks/これがプーリング層の仕組みです。 畳み込みとして数えた3つのチャネル、10、または100のチャネル-いくつかのボリュームのキューブがあります。 幅と高さを単純に縮小しますが、残りの寸法には影響しません。 すべては原始的なものです。

たたみ込みネットワークは何に適していますか?

これらは、従来の完全に接続されたネットワークよりもパラメーターが大幅に少ないという点で優れています。 完全に接続されたネットワークの例を思い出してください。ここでは、100万の重みを取得しました。 類似、より正確に類似したものをとると、類似と呼ぶことはできませんが、同じ入力、同じ出力を持つ密接な畳み込みニューラルネットワークは、出力に1つの完全に接続されたレイヤーと100個のニューロンがある別の2つの畳み込みレイヤーも持ちますコアネットワークでは、このようなニューラルネットワークのパラメーターの数が1桁以上減少していることがわかります。

パラメータがこれより少ない場合は素晴らしいことです。ネットワークのトレーニングは簡単です。 私たちはこれを見て、訓練するのは本当に簡単です。

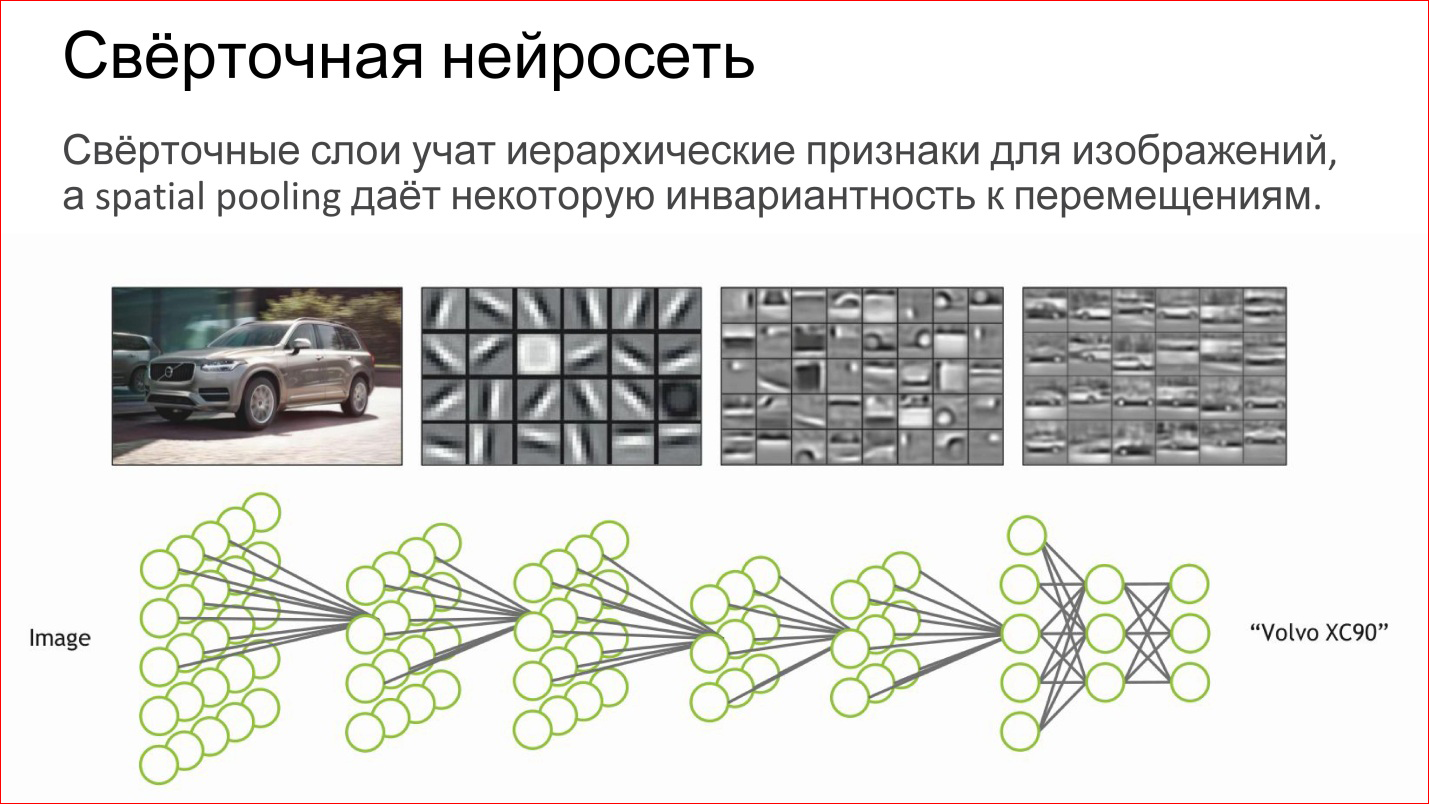

たたみ込みニューラルネットワークは何をしますか?

実際、画像のいくつかの階層的な機能を自動的に教えます。最初の基本的な検出器、さまざまな傾きの線、勾配など。 これらのうち、彼女はさらに複雑なオブジェクトを収集し、さらに複雑なオブジェクトを収集します。

ニューロンを単純なロジスティック回帰、単純な分類器と見なす場合、ニューラルネットワークは単なる階層分類器です。 最初に単純な標識を選び出し、そこから複雑な標識を組み合わせ、さらに複雑な標識をさらに複雑にし、最終的には特定の人、特定の機械、象など、非常に複雑な標識を組み合わせることができます。

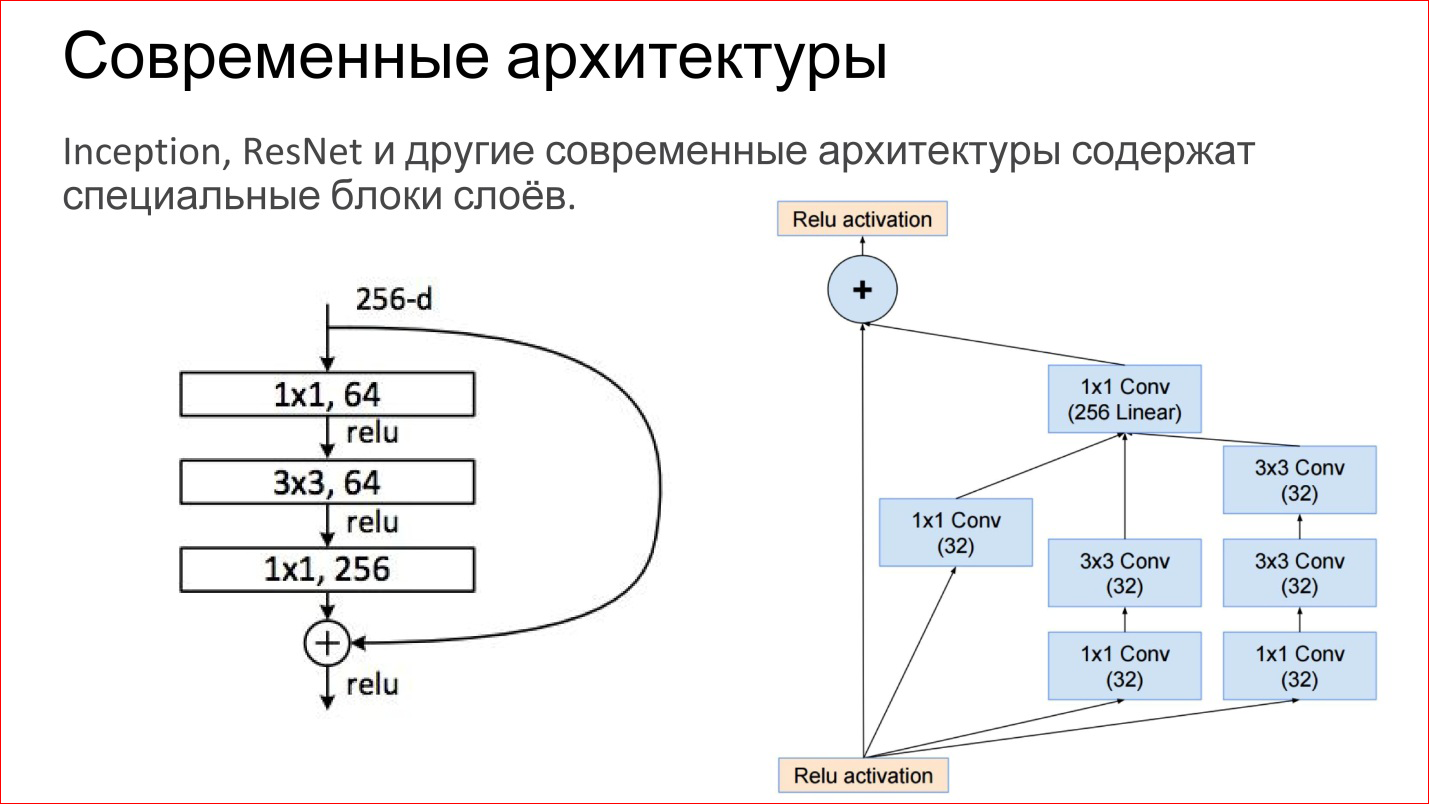

畳み込みニューラルネットワークの最新のアーキテクチャは、はるかに複雑になっています。 最新のImageNetコンテストで優勝したニューラルネットワークは、単なる畳み込み層ではなく、プーリング層です。 これらは直接完成したブロックです。 この図は、ネットワークInception(Google)およびResNet(Microsoft)の例を示しています。

実際、内部は同じ基本コンポーネントであり、同じ畳み込みと引き抜きです。 ちょうど今、それらの多くがあり、それらは何らかの形で巧みに組み合わされているだけです。 さらに、画像をまったく変換せずに、単に出力に転送する直接接続があります。 これは、偶然にも、グラデーションがフェードしないようにするのに役立ちます。 これは、ニューラルネットワークの最後から最初に勾配を渡す追加の方法です。 また、このようなネットワークのトレーニングにも役立ちます。

これは非常に古典的な畳み込みニューラルネットワークでした。 はい、分類に使用できるさまざまなタイプのレイヤーがあります。 しかし、もっと面白いアプリケーションがあります。

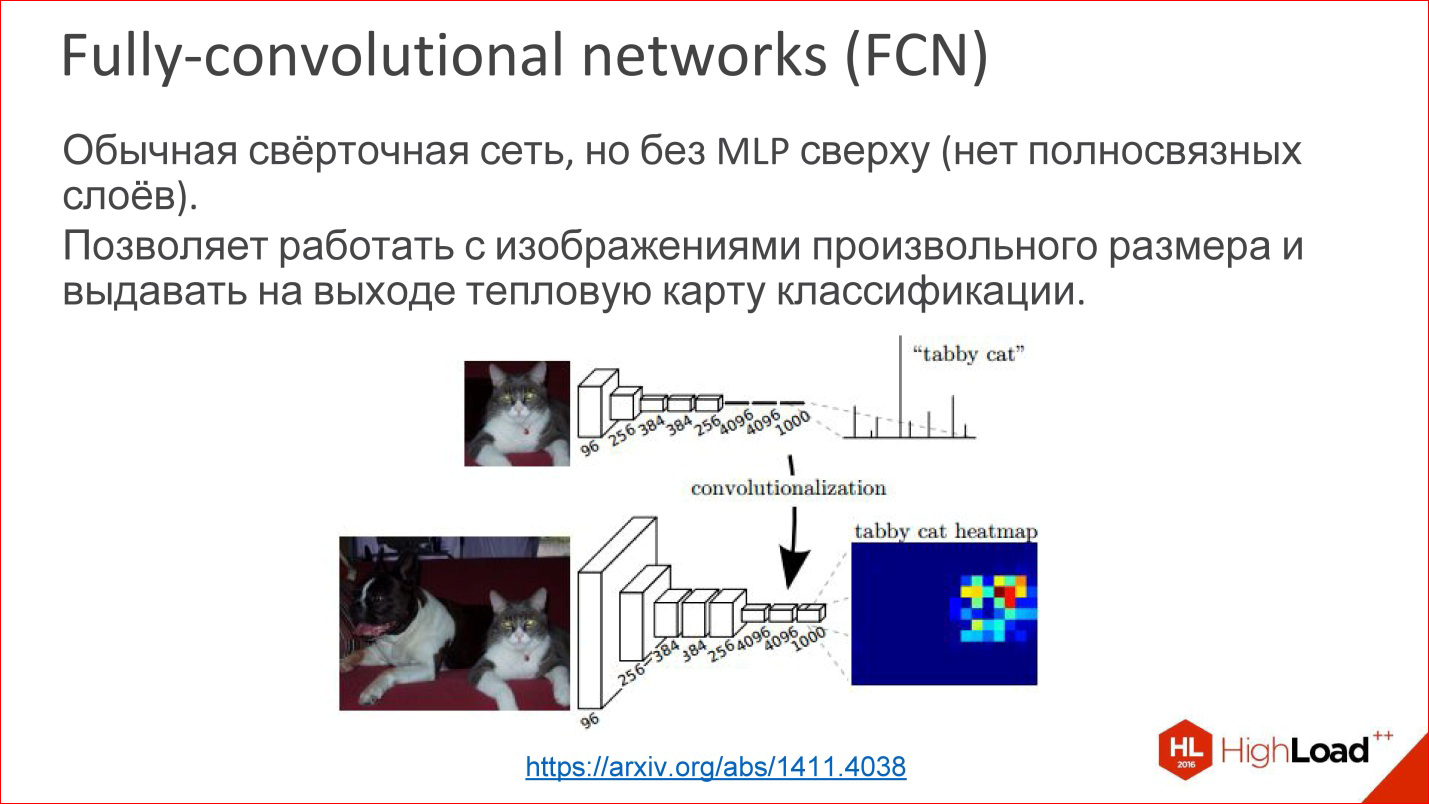

https://arxiv.org/abs/1411.4038

https://arxiv.org/abs/1411.4038たとえば、完全畳み込みネットワーク(FCN)と呼ばれる畳み込みニューラルネットワークがあります。 彼らはめったに話されませんが、それはクールなことです。 あなたは最後の多層パーセプトロンを取りはずすことができます、それは必要ありません-それを捨ててください。 そして、ニューラルネットワークは、任意のサイズの画像に対して魔法のように機能します。

つまり、例えば、子猫、犬、その他の画像で1000クラスを定義することを学んだ後、最後のレイヤーを取り、それを剥がすことなく、畳み込みレイヤーに変換しました。 問題はありません-あなたは体重を数えることができます。 次に、このニューラルネットワークは、トレーニングされた同じウィンドウ100 * 100 psで動作することがわかりましたが、画像全体でこのウィンドウを介して実行でき、出力で一種のヒートマップを作成できます-この特定の画像特定のクラス。

たとえば、すべてのクラスに対してこれらのヒートマップを1000個作成し、これを使用して画像内のオブジェクトの位置を決定できます。

, , .

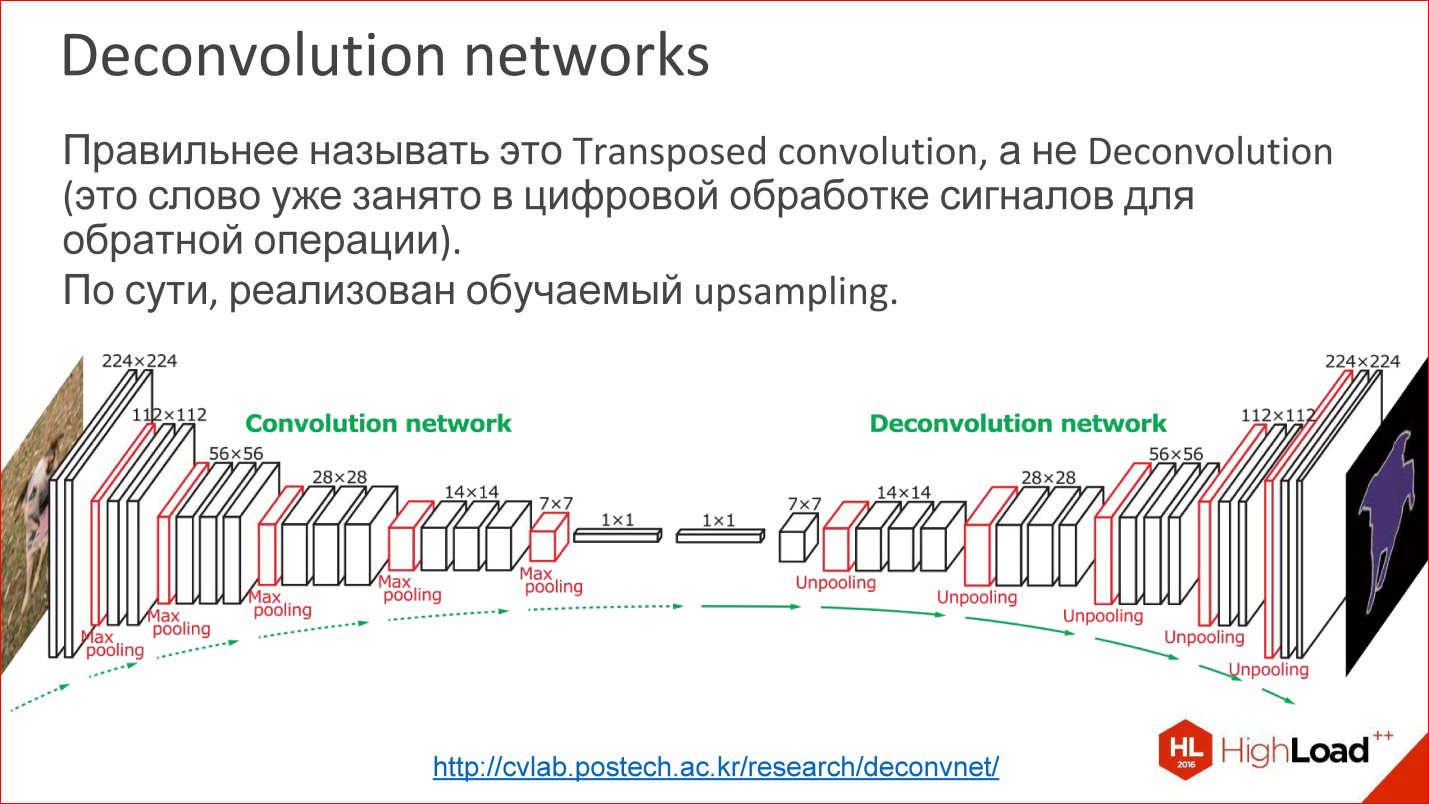

http://cvlab.postech.ac.kr/research/deconvnet/

http://cvlab.postech.ac.kr/research/deconvnet/— Deconvolution networks. , .

Deconvolution — . — , .

これは何ですか , Upsampling. - - , , 1 ps. , , - . .

, - 10*10 ps, Upsampling , - , Upsampling .

— , , , - . /, , , . これは面白いです。

. — , - . , . — , .

, , -, .

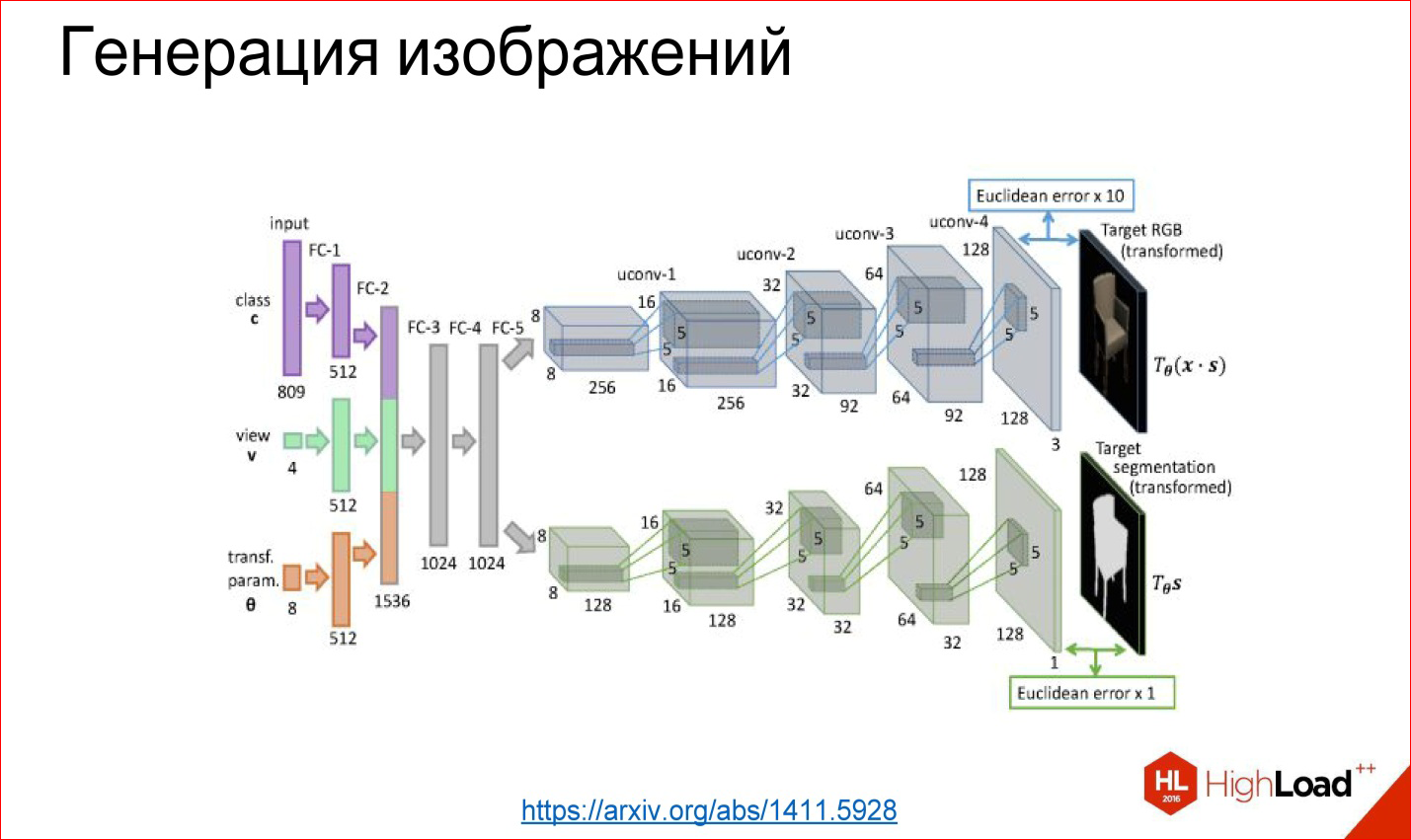

https://arxiv.org/abs/1411.5928

https://arxiv.org/abs/1411.5928, , , - , — , , , : - - . - , .

, . , . , , , - .

https://arxiv.org/abs/1508.06576

https://arxiv.org/abs/1508.06576, , , . , . .

https://arxiv.org/abs/1508.06576

https://arxiv.org/abs/1508.06576. , , , . , — , .

, , , , . , , , . () , , , . Backpropagation. , , , . .

, . - — . , , , . , - , -.

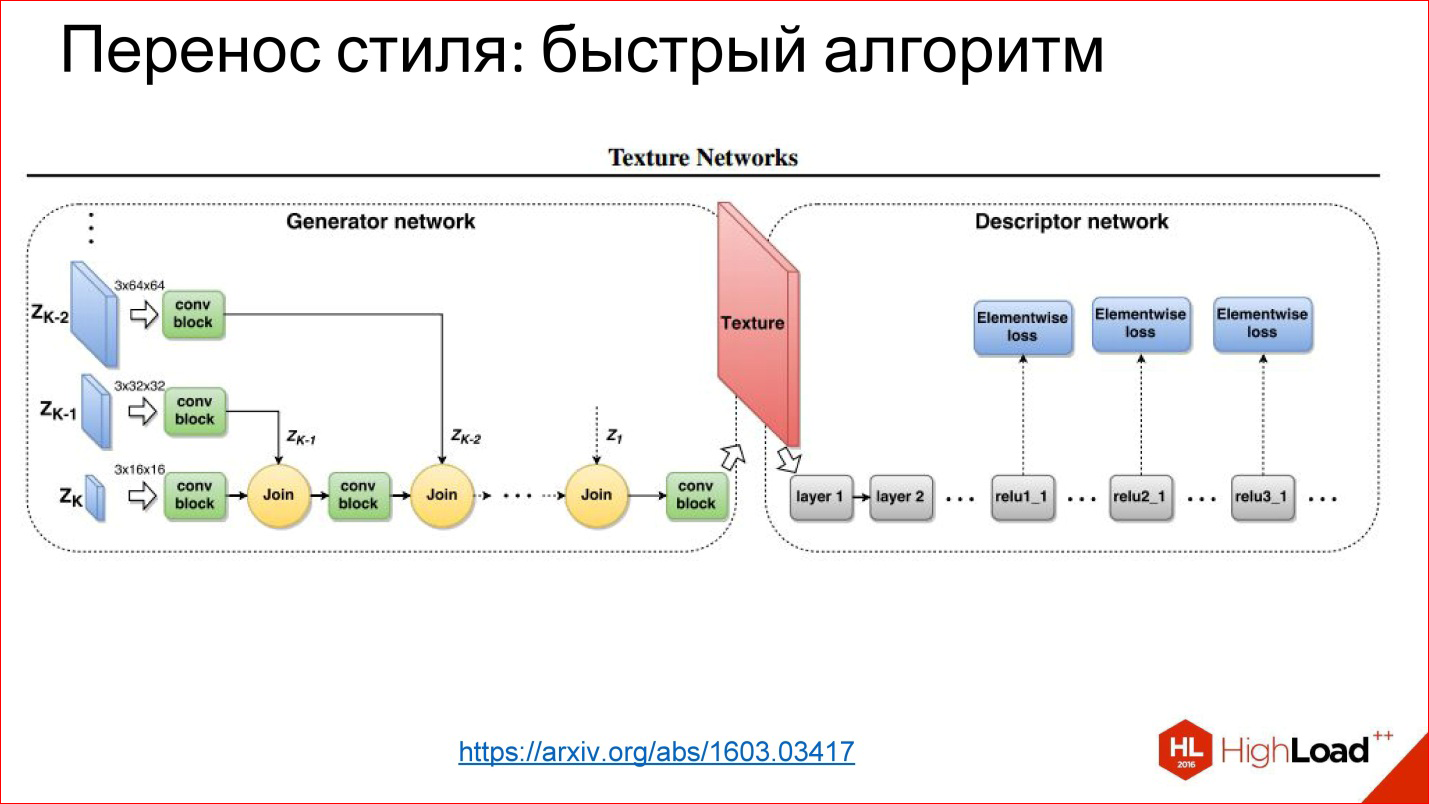

https://arxiv.org/abs/1603.03417

https://arxiv.org/abs/1603.03417, 1 . , : -, -, , .

, — , , .

, , , .

.

:

Recurrent Neural Networks, RNN

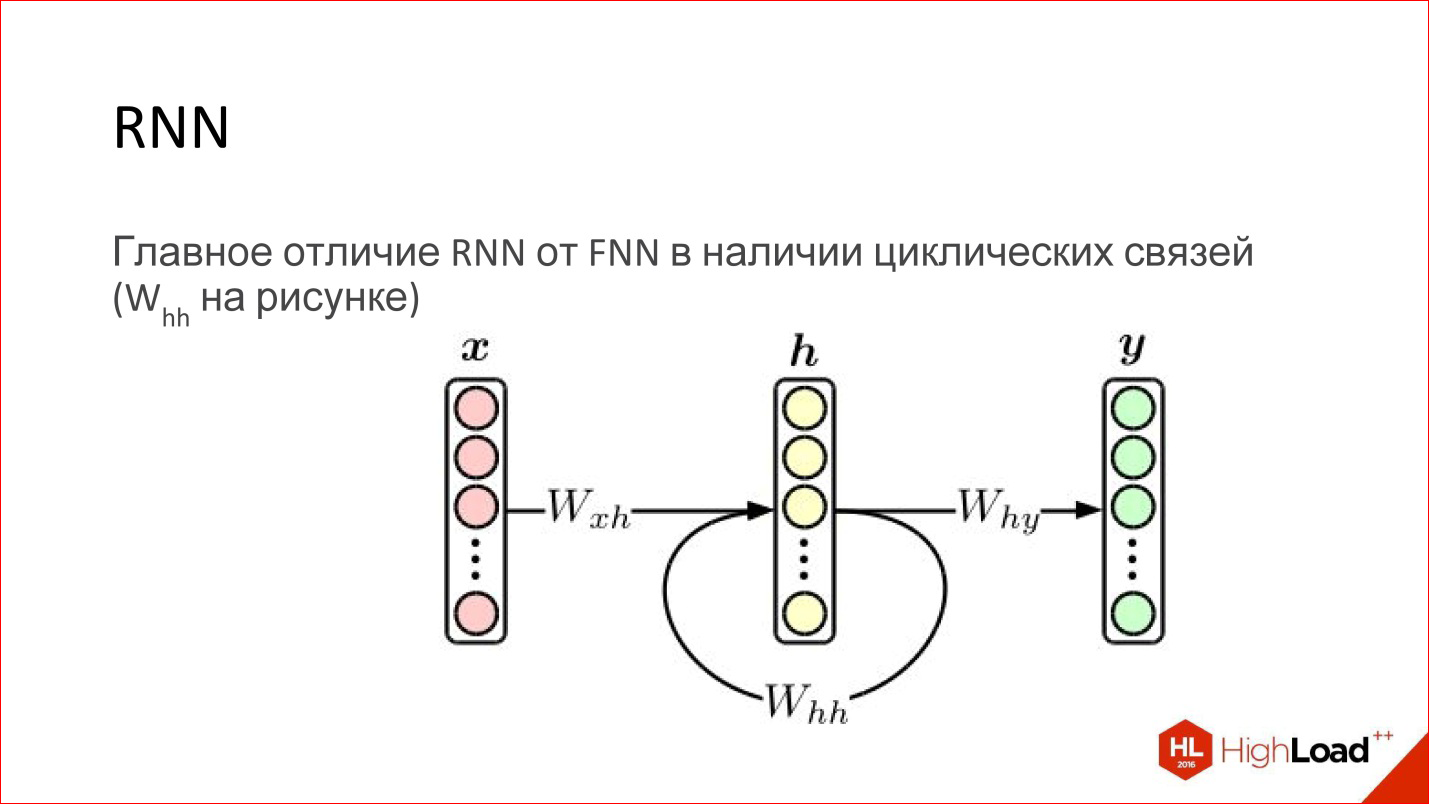

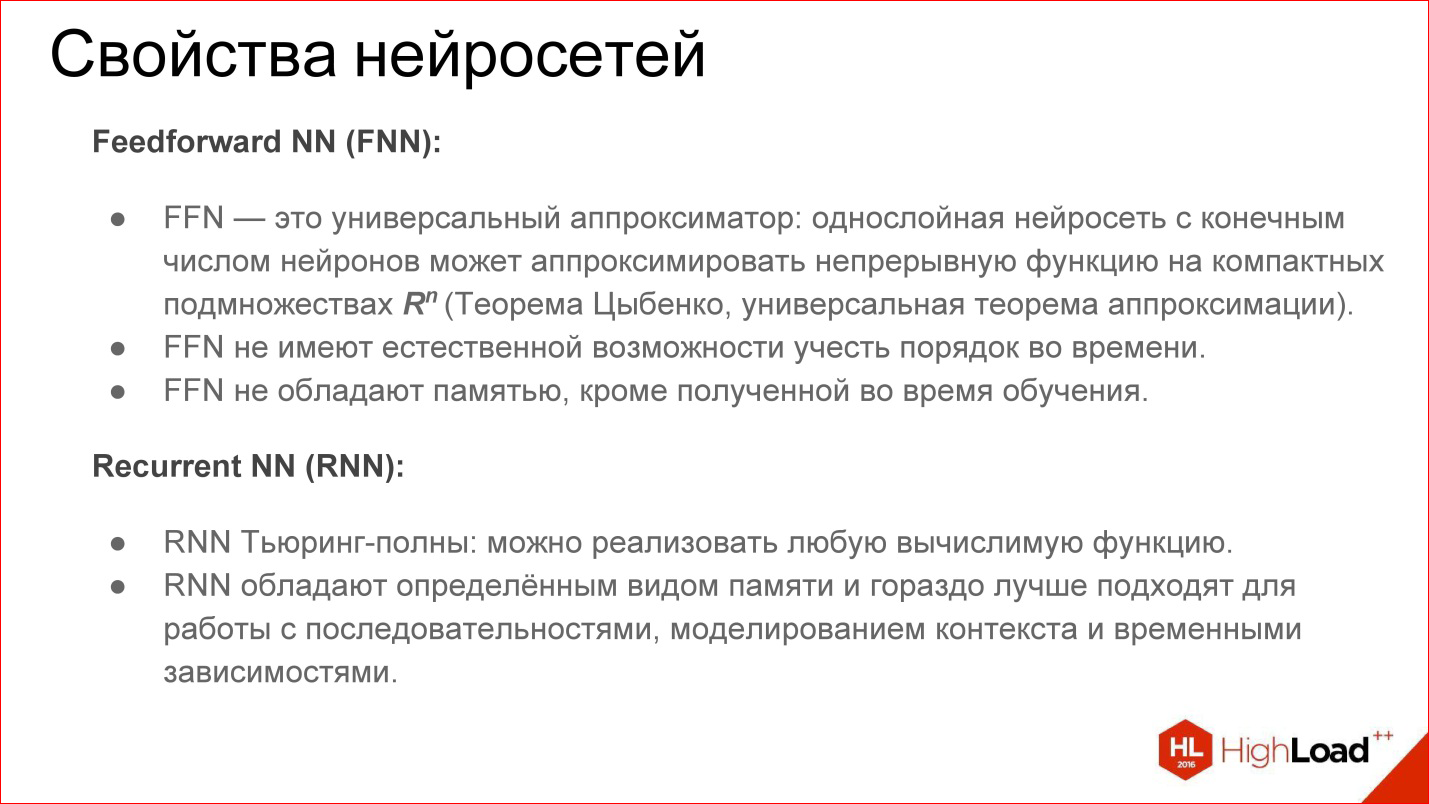

. , FNN- , - . . , , .

Feed-Forward , . - ( ). , — . .

— . — . . , .

, Feed-Forward- — , . , .

Feed-Forward , , , . , , . . .

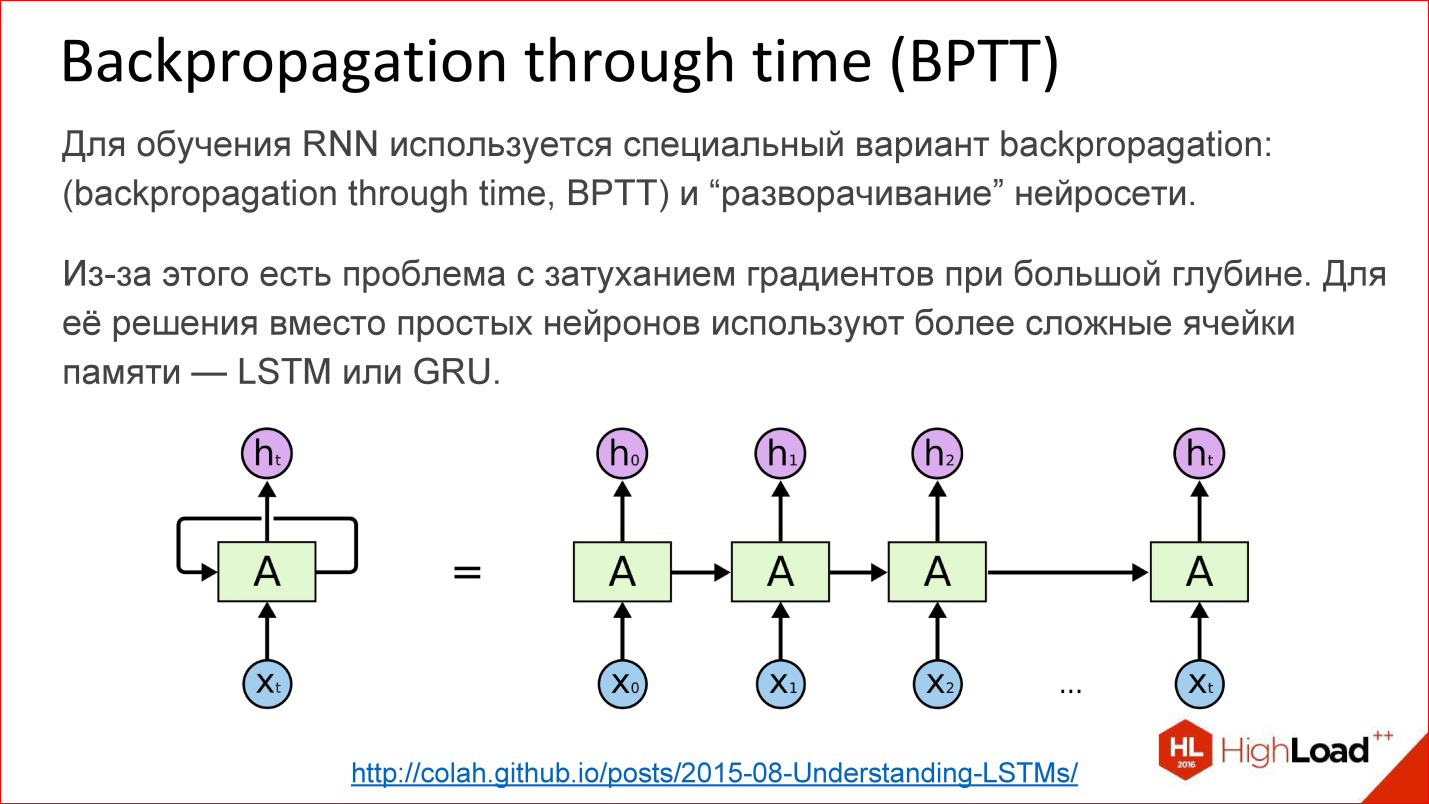

http://colah.imtqy.com/posts/2015-08-Understanding-LSTMs/

http://colah.imtqy.com/posts/2015-08-Understanding-LSTMs/? . Backpropagation, , , Backpropagation .

— Backpropagation through time. — - , , 10, 20 100, , Backpropagation.

しかし、問題があります。 – 10, 20, 100 — , , 100 . - . , LSTM GRU- .

https://deeplearning4j.org/lstm

https://deeplearning4j.org/lstm, , gate, , , .. gate , . , , , , , 100 . , - , . , .

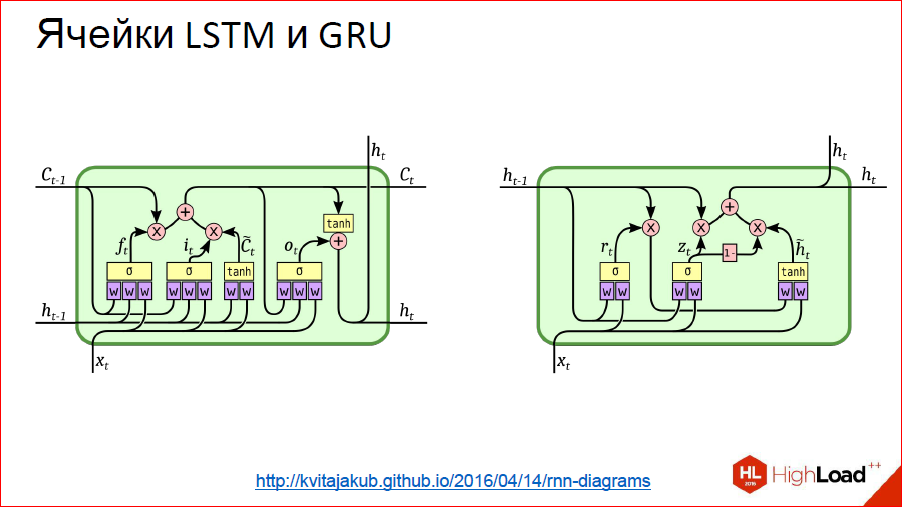

- , . LSTM, GRU.

http://kvitajakub.imtqy.com/2016/04/14/rnn-diagrams

http://kvitajakub.imtqy.com/2016/04/14/rnn-diagrams, , , , , , , . gate, « — », « — ».

. , , .

, , , , — . ! , , , — , , ?

. , - . , , 2 , .

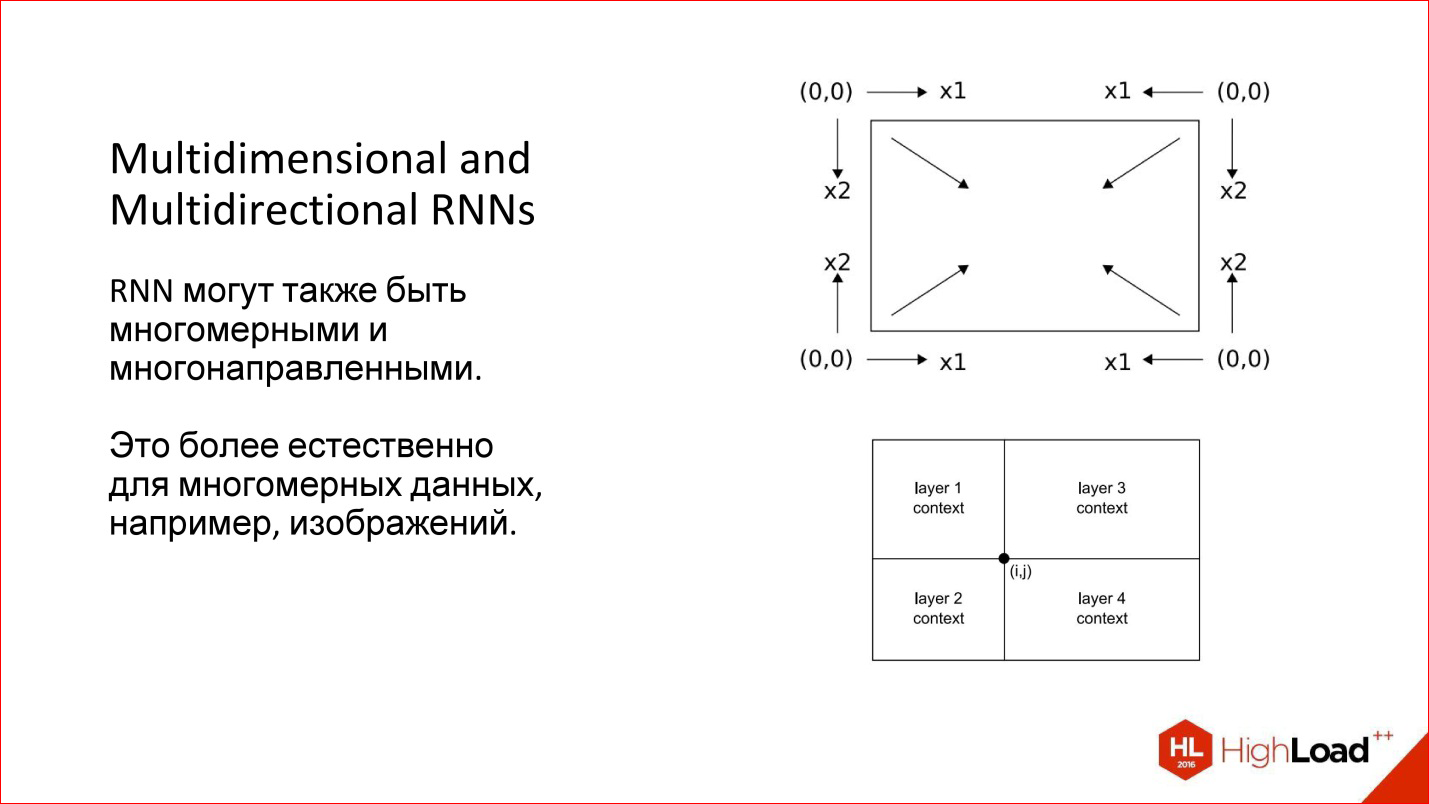

Bidirectional — . , , : 2 — , . , , .

, , - , — .

, — , . — . 4 , -. , , 4 .

: , . . , , , 10, , .

(2015 ). — LeNet, . , . , .

— , . , , - .

. , , . .

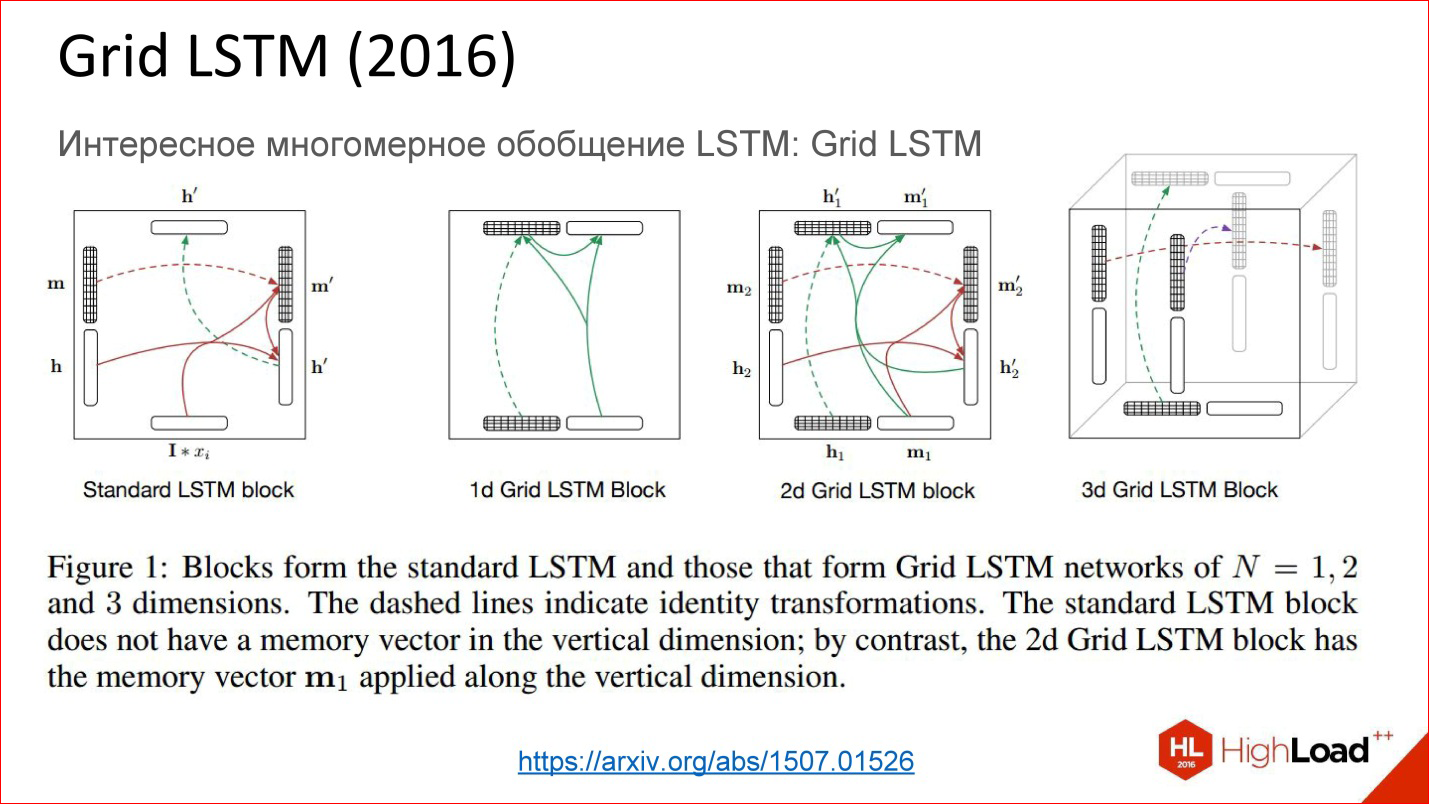

https://arxiv.org/abs/1507.01526

https://arxiv.org/abs/1507.01526Grid LSTM, . — , - - , . , gate, . , - ? , , !

— , . 1-2 , . , , .

, , , .

.

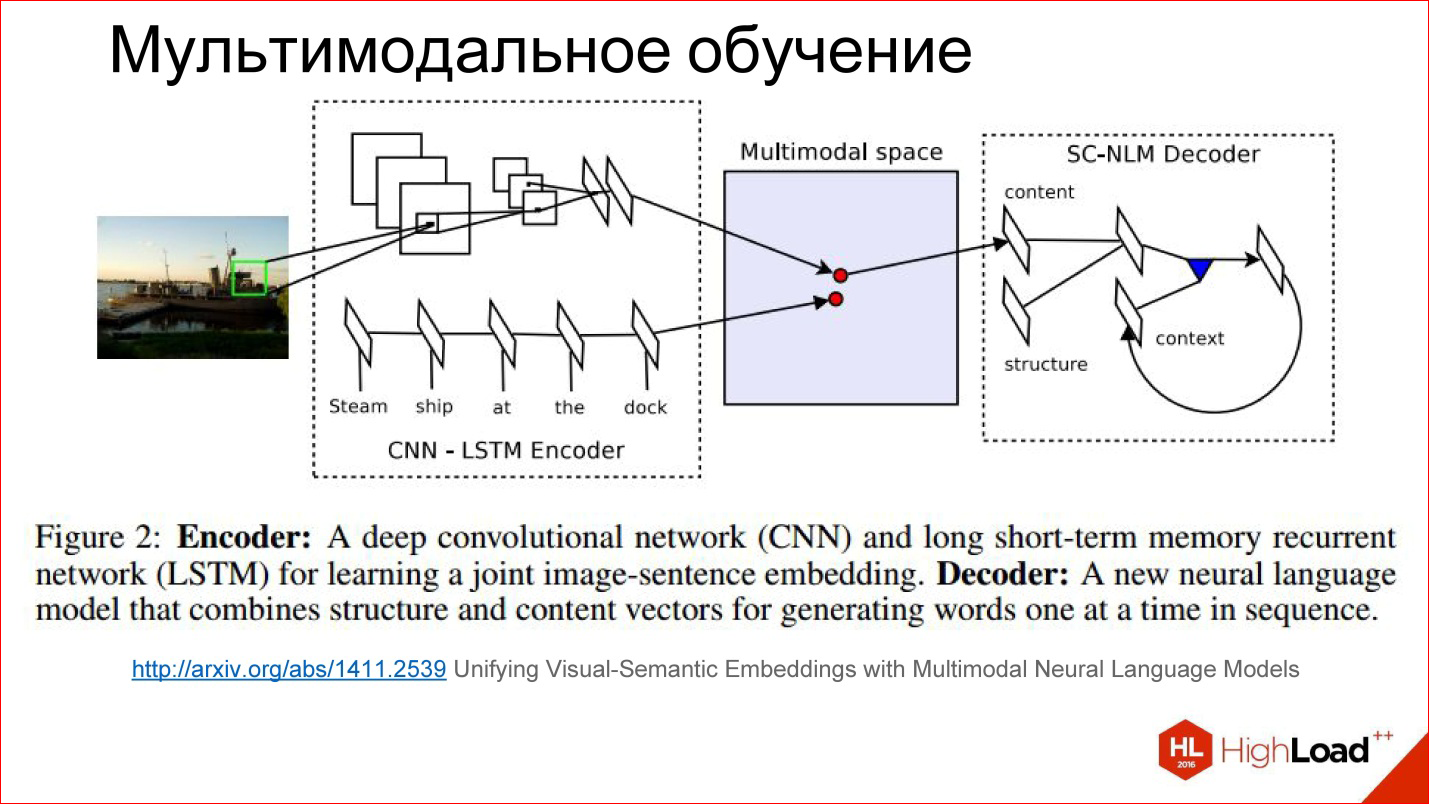

(Multimodal Learning)

, ,

— , 2 , , . 1 — , , . !

http://arxiv.org/abs/1411.4555

http://arxiv.org/abs/1411.4555, — . , , , , , . , , . .

, HighLoad++ . , , YouTube .

. , , - - . , .

2- . .

https://www.cs.utexas.edu/~vsub/

https://www.cs.utexas.edu/~vsub/, , . , — .

例:

!

, .

http://arxiv.org/abs/1411.2539

http://arxiv.org/abs/1411.2539- , , , . , 2 : , . 2 .

, : — , — . .

ところで、テキストの画像を生成するネットワークを構築しようとする試みは既にあります。それは面白いです、それも動作します。まだあまり良くありませんが、可能性は膨大です。シーケンス学習とseq2seqパラダイム

入力および/または出力で任意の長さのシーケンスを使用する場合

2番目の興味深いトピックは、シーケンス学習またはseq2seqパラダイムです。 翻訳もしません。 アイデアは、多くのタスクがシーケンスを持つことに帰着するということです。 つまり、分類する必要がある画像だけでなく、1つの番号を与えるだけでなく、1つのシーケンスがあり、出力には別のシーケンスが必要です。

たとえば、翻訳はシーケンス2シーケンス学習の古典的なタスクです。彼らはテキストを英語で設定し、フランス語で取得したいと考えています。

実際、このようなタスクは数多くあります。 これは、写真の説明の場合です。

http://karpathy.imtqy.com/2015/05/21/rnn-effectiveness/

http://karpathy.imtqy.com/2015/05/21/rnn-effectiveness/私たちが調べた通常のニューラルネットワーク-何かを運転し、ネットワークを運転し、出力で削除した-はおもしろいものではありません。

One to manyというオプションがあります。 彼らは写真をネットワークに送り、そして彼女は仕事に行き、仕事をし、この写真の説明を作成しました。 わあ

反対方向にできます。 たとえば、テキストの分類。 これはすべてのマーケティング担当者のお気に入りのタスクです-ツイートを分類するために-彼らは感情的な色の面で肯定的または否定的です。 提案をリカレントニューラルネットワークに導き、最後に1つの数字を出しました-はい、肯定的な色のツイート、いいえ、否定的な色のツイート、ニュートラルなど。

翻訳についての話があります。 長い間、1つの言語でシーケンスを運転していました。 その後、ネットワークは機能し、別の言語でシーケンスを生成し始めました。 これは一般的に最も一般的な設定です。

入力と出力が同期される場合、別の興味深い設定があります。 たとえば、画像のすべてのフレームに注釈を付けたい場合、何かがあるかどうか。

この図は、シーケンス2シーケンス学習のすべてのオプションを示しています。これは非常に強力なパラダイムです。 ニューラルネットワーク内のすべてが微分可能であるという点で強力です-そして、議論したニューラルネットワークが内部で完全に微分可能であるということは、いわば、エンドツーエンドでニューラルネットワークをトレーニングできることを意味します。内部で何が起こっているかはあなたにはまったく関係ありません。 ニューラルネットワーク自体が対処します。英語の多数の例が入力され、フランス語の多数の例が出力であり、優れています。彼女自身が翻訳方法を学習します。 そして、もしあなたが大規模なデータベースとそれを追い払うための優れた計算能力を持っているなら、本当に良い品質で。

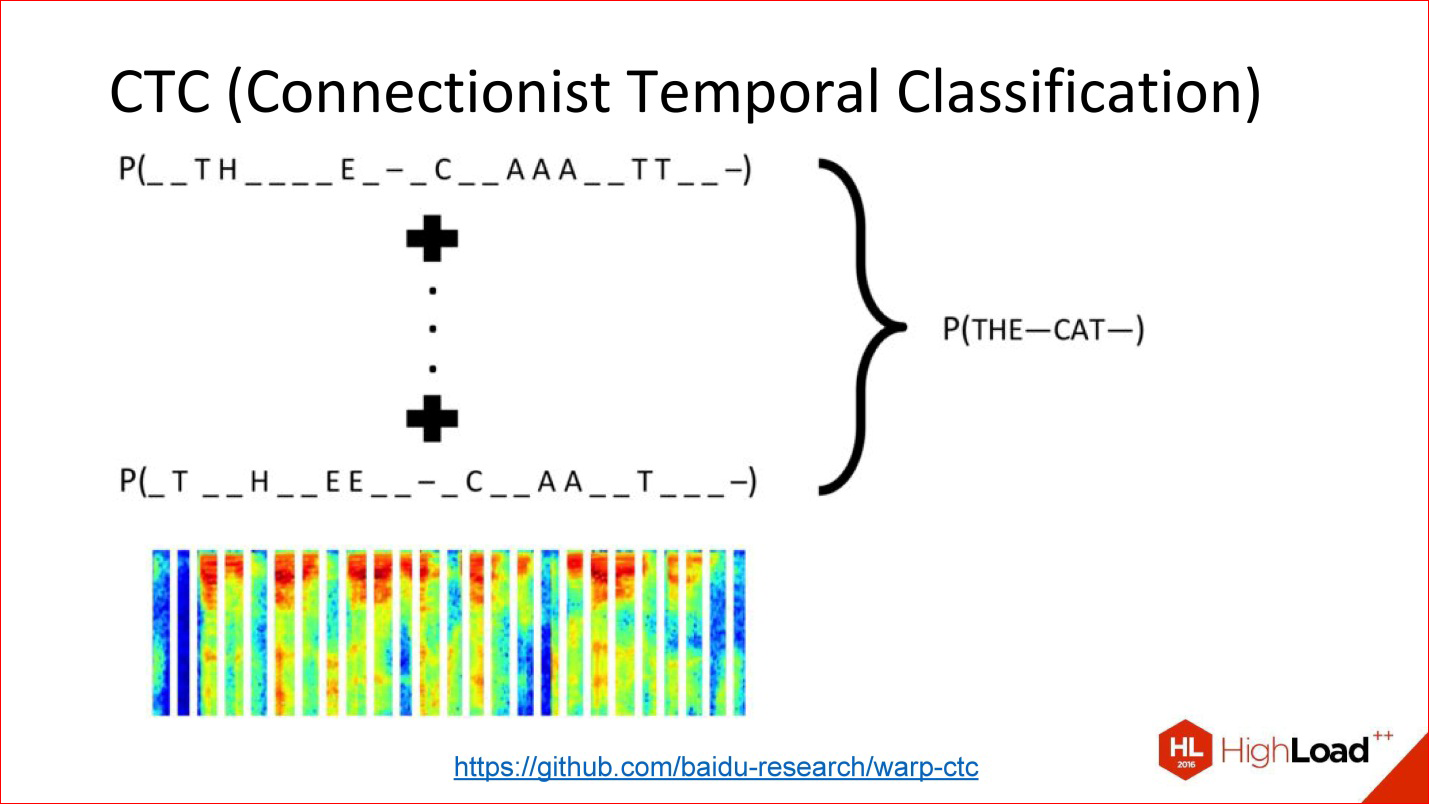

ほとんど誰も話していないが、Google Speech Recognition、Baidu、またはMicrosoftが機能しないもう1つの非常に重要なことは、CTCです。

https://github.com/baidu-research/warp-ctc

https://github.com/baidu-research/warp-ctcCTCは非常に扱いにくい出力層です。 彼は何をしていますか? このシーケンス内のアライメントが実際に重要ではない多くのタスクがあります。 音声認識タスクがあります。 たとえば、音を取り、それを50ミリ秒の短いフレームにカットし、出力で、どの単語であるか、音素のシーケンスを生成する必要があります。 概して、元のシグナルのこの音素またはその音素がどこにあったかは重要ではありません。 出口で簡単な単語を取得するために、相互間の順序のみが重要です。

正確な位置に関するすべての情報を捨てることができるという事実は、実際にはたくさんあります。 たとえば、すべてのサウンドフレームに正確な音素マークを付ける必要はありません。そのようなマークアップを取得するのは非常に高価なためです。 すべてをマークアップする男を植える必要があります。

すべてを取り出して捨てることができます-入力があり、出口があります-出力シーケンスに関して何が起こるべきか-つまり、このトリッキーなCTCレイヤーがあり、それ自体が何らかの整列を行い、これが再び終了します-そのようなトリッキーなネットワークを訓練するために、あなたは何もマークしなかった。

これは強力なことであり、最新のすべてのパッケージに実装されているわけでもありません。 しかし、たとえば、1年前、BaiduはCTCレイヤーの実装をレイアウトしました-それは素晴らしいことです。

さまざまなアーキテクチャに関するいくつかの言葉。

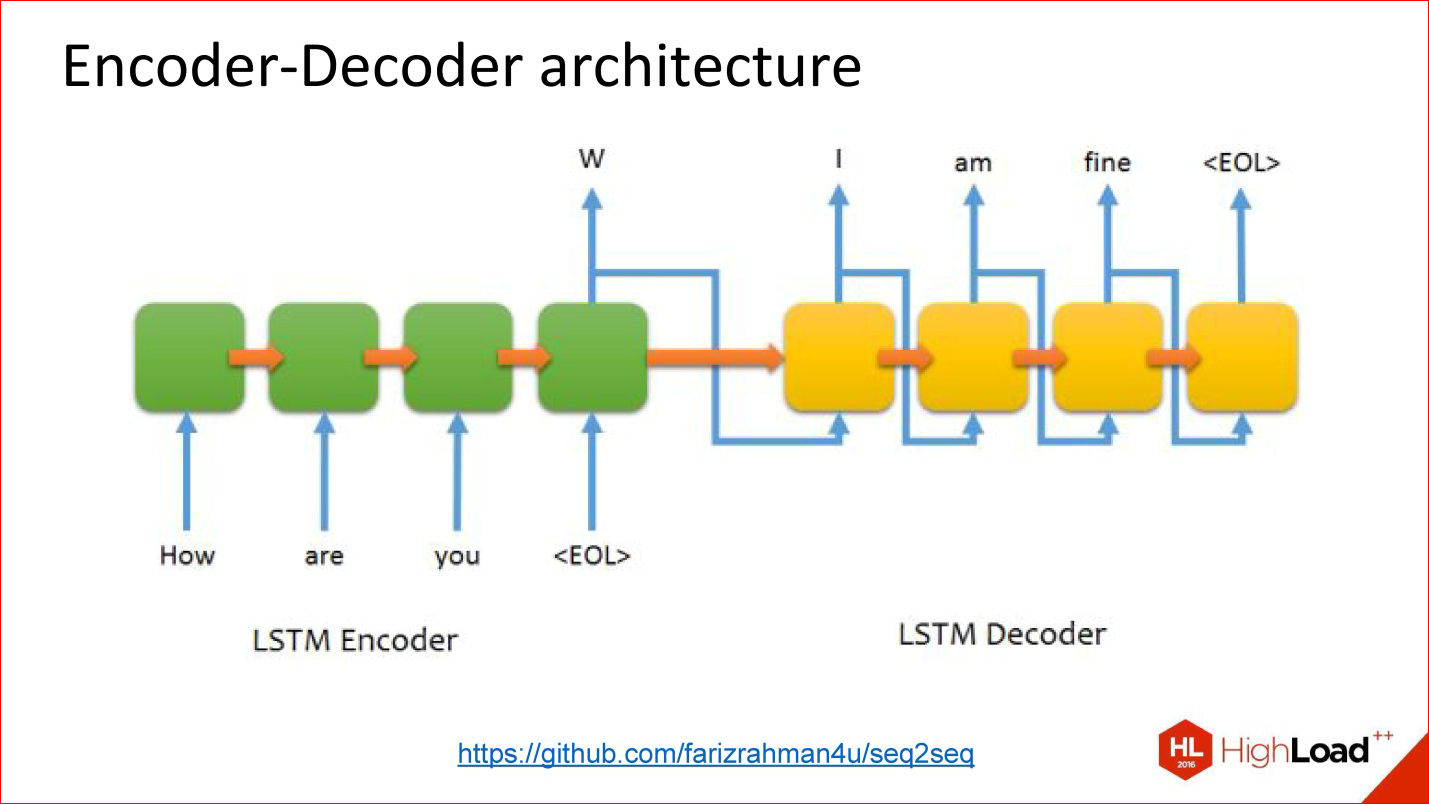

https://github.com/farizrahman4u/seq2seq

https://github.com/farizrahman4u/seq2seq古典的なエンコーダーデコーダーアーキテクチャーがあります。 私が話した翻訳の例は、ほぼ完全にこのアーキテクチャに限定されています。

入力ニューラルネットワークが1つあり、そこに単語が配信されます。 このニューラルネットワークの出力は、文の終わりの記号が指定されるまで無視されます。 その後、2番目のネットワークがケースに含まれ、最初のネットワークの状態を読み取り、そこから出力ワードの生成を開始します。 前のステップでの結果は入力に送られます。

動作します。 多くの翻訳システムはこのように機能します。

しかし、このアーキテクチャには1つの問題があります-ボトルネックもです。 送信される状態ベクトル(非表示層のサイズ)は制限され、固定されています。 つまり、短い文でも、非常に長い文でも同じであることがわかります。これはあまり良くありません。 長い文がこのボリュームに収まらないことが判明する場合があります。

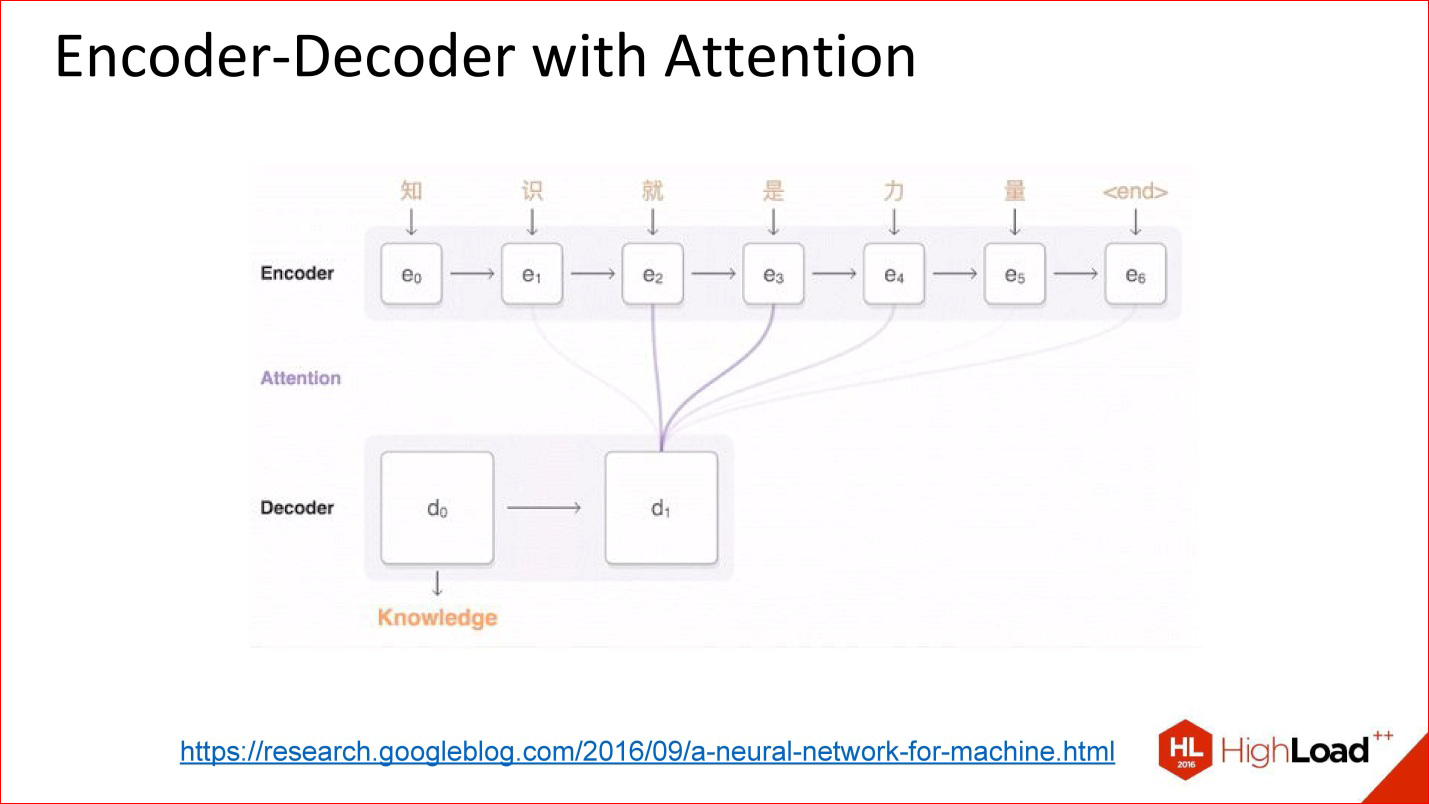

https://research.googleblog.com/2016/09/a-neural-network-for-machine.html

https://research.googleblog.com/2016/09/a-neural-network-for-machine.html彼らが言うように、建築は注意を払って登場した。

注意はそのようなトリッキーなものであり、実際には実際には非常に単純です。 これは、ニューラルネットワークの出力デコーダーが以前のニューラルネットワークの出力値ではなく、すべての中間状態で、ある種のバランスで見るという考え方です。 重みは、デコーダーが機能する最終的な大量にこれらの各状態を取り込むために必要な量の係数です。

つまり、注意は実際には、エンコーダの以前のすべての状態の単純な線形結合であり、これも訓練されています。

事実に注目したニューラルネットワークは非常にうまく機能します。 翻訳やその他の複雑なタスクでは、それらは注意を払わずにニューラルネットワークよりも品質が非常に優れています。

http://kelvinxu.imtqy.com/projects/capgen.html

http://kelvinxu.imtqy.com/projects/capgen.htmlそのようなネットワークの追加ボーナス。 この図は、2つの異なるニューラルネットワークの組み合わせを示しています。畳み込みニューラルネットワークからいくつかの兆候を得た後、再帰ニューラルネットワークがテキストを生成します。 注意の概念を実装し、いくつかの写真を設定すると、重みが大きい特定の単語の生成を見ることができます。 これは、特定の瞬間に画像のどのピクセルがこの特定の単語を生成する役割を果たしたかを実際に示します。 つまり、ニューラルネットワークが注意を払っているように見えたものです。

ところで、注意の概念はすべてのライブラリに実装されるにはほど遠い、つまり、既成のボックスソリューションはありません。 誰かが自分の仕事の一部として公開した既製のコードを見つけることができます。

http://kelvinxu.imtqy.com/projects/capgen.html

http://kelvinxu.imtqy.com/projects/capgen.htmlCNN + RNN with attention =美しい写真。

ニューラルネットワークがSTOPサインに関するテキストを生成するとき、それは本当にこのサインのように見えます-その重量、特定のSTOPサインの生成への貢献は非常に高く、他のすべてのピクセルはほとんど役割を果たしません。

これは興味深い概念です。注意してください。 また、多く使用されます。

ニューラルネットワークを操作するためのフレームワークとライブラリ

非常に短いレビュー

実際、何時間も話すことができます。 私はあなたに伝える目的はありません-はい、このライブラリまたはこれを使用してください-これはそうではないからです。 膨大な数のライブラリがあります。 多かれ少なかれ関連の異なるライブラリのリストを提供します。

詳細リスト:

http :

//deeplearning.net/software_links/ユニバーサルライブラリとサービス:

まず、普遍的なライブラリがあり、その多くについて聞いたことがあります。

たとえば、TensorFlow(Google)は、最近ではありますがおそらく最も人気のあるものの1つです。 PythonおよびC ++で使用できます。

現在、Facebookを積極的にサポートしているTorchライブラリがあります。 これはLua言語です。 しかし、怖がらないでください、それは実際にクールな言語です。 このライブラリには実装されたものがたくさんあり、Luaコードの形で新しい研究がたくさんあります。 これは素晴らしい。

Theanoライブラリがあります-TensorFlowは現在それをわずかに置き換えていますが、Theanoの周りには多くの異なるクールな高レベルラッパーが構築されています-ニューラルネットワークは数行で記述できます。 これは本当に素晴らしいです!

Kerasなどのこれらのラッパーの一部は、彼らが言うように、バックエンドのようにTensorFlowで動作できます。 つまり、TensorFlowはニューラルネットワークの観点ではかなり低レベルのコードであり、Kerasは高レベルのコードであるか、単一行のレイヤーが便利です。

Microsoftは何かを公開しました。Neep、Deeplearning4j-まれなケース-DeeplearningのJavaライブラリがあります。 Javaにはほとんどありません。 多くのPythonおよびC ++。 他の言語では少ない。

さらに、ビデオ処理用の特別なツールがあります。

画像とビデオの処理:

ここにOpenCVを含めました。 もちろん、これはDeeplearningライブラリではありませんが、他のライブラリとうまく統合できます。

Caffeは素晴らしいライブラリであり、本番環境で使用しました。 これはプラスのライブラリであり、非常に高速です。実際よりも高速ではありません。 現在もニューラルネットワークを習得している人は、何らかの理由でTensorFlowのみを考えていますが、それでもまだクールです。 しかし、Caffeを含む他の優れたソリューションがたくさんあることに注意してください-非常にクールなことです。

さらに、WEBで使用できるさまざまなAPIがいくつかあります。

音声認識。 実際に悪化しています。

音声認識:

音声認識用のクールなKALDIライブラリが1つありますが、それはプラスです。 しかし、一般的に、大企業では音声認識は多かれ少なかれ閉鎖されています。なぜなら、誰も音声と音声に関する大きなデータセットを持っていないからです。 しかし、Yandex、Google、Baiduには多数のAPIがあり、MicrosoftにもAPIがあるようです。

ワープロ:

テキストについては、特に特別なものはありませんが、すべてのユニバーサルライブラリは優れています。 Keras(または他の、それは問題ではない)を取り、数行で何かを書く-テキストを扱う準備ができているニューラルネットワークがあります。 または他のライブラリ-それは重要ではありません。

それだけです、ありがとう。 どのユニバーサルライブラリーを採用すべきかという質問に対する普遍的な答えはありません。 タスクを見てください。 多くの微妙な点があります-そして、あなたが持っているテクノロジーの種類、その中に埋め込まれているもの、既成のコードはすでに自然のものです

-http://github.com/で使用できるコードは本当にたくさんあり

ます 。 これは、慎重に取り組む必要があるエンジニアリングタスクです。 単一の普遍的な答えはなく、ありえません。

よくある質問

質問 :初心者向けにある種の文献をアドバイスしてもらえますか?ニューラルネットワークのプログラミング方法を読んだり、見たり、理解したりするにはどうすればよいでしょうか?

回答 :ここでの多くは、現在のレベル、理解を深めたい程度に依存します。 実際、膨大な数のブログがあります。 最初に、ロシア語を忘れてください-実際には何もありません。 Habréにはいくつかの翻訳がありますが、これは自然界に存在する配列の背景に対して深刻ではありません。

英語では、さまざまな例が理解できるクールなブログが膨大にあります。 たくさんあります。グーグルで検索して、特定のトピックで何かを見つけてください。 さまざまなチュートリアルがありますが、これも英語で、多少なりとも小さくなっています。 800ページのDeeplearningブックがあります。これは現在AMT-Pressの紙で入手でき、長い間PDFで入手できます。

一般に、文献があります。 Courseraなど、オンラインでいくつかのコースがあり、コースをオフラインで起動しようとしています。 特に、私はこれらのコースのいずれかにすぐに参加します。

実際には、かなり多くの異なるオプションがあります。 インターネットを見てください-ただし、多くの機会があります。 彼らの多くはいまだに様々な外国文学を読んでいますが、それは本当に良くて包括的なものです。

しかし同時に、GitHubのコードも優れています。 多くのコードが公開されており、少なくとも確認できます。 多くの場合、読むことができますが、それほど怖いものではありません。 そして、このコードには、それがどのように機能するかについてのわかりやすいコメントがしばしばあります。 インターネットに行くだけです-そこにはすべてがたくさんあります。

質問 :一般に、ニューラルネットワークをトレーニングする方法は何ですか? インターネットからたくさんの写真を簡単にグーグル検索することは可能ですか、それとも他のニューラルネットワークを訓練するニューラルネットワークを利用できますか?

回答 :はい、これは素晴らしい質問です。 ニューラルネットワークのトレーニングでは、今後数年で多くの進歩もあると思います。 さまざまなアプローチがあります。 最初に、はい-データセットを入力してトレーニングしたとき-これは古典的なアプローチです。 彼は、彼から逃げることはできません、彼は多くの場合基本的です。

しかし今、ところで、転移学習と呼ばれる別のアプローチがしばしば基本的なアプローチになります。 同じImageNet上で、さまざまなタスクでトレーニングされた、すでに公開されている多数のニューラルネットワークがあります。 1000クラスの既製のImageNetニューラルネットワークを使用して、一部の特別なクラスで再トレーニングできます。 たとえば、クラスの画像が1000枚しかないため、このようなボリュームで最初から優れたニューラルネットワークをトレーニングすることはできないため、これはより簡単になります。 ディープニューラルネットワークをトレーニングするには、大量のデータが本当に必要です。 数十万、数百万のオブジェクトです。 ただし、既製のグリッドがある場合は、それを使用して少しトレーニングし、すでに正常な結果が得られています。 転移学習は良いアプローチです。 彼は働いています。

他のニューラルネットワークがニューラルネットワークを教えるときのオプション-そのようなオプションもあります。 それらは生産よりも研究です。 これは非常にクールなトピックです。従うのは素晴らしいことです。 優れた制作ソリューションはわかりませんが、科学的な側面に興味があるなら、そうです、読んでください。ある種の世界のモデルを含む教師とニューラルネットワークが別のニューラルネットワークを教えてくれるという非常にクールな記事があります。 。

質問 :ニューラルネットワークの既存のアーキテクチャを変更したり、独自のアーキテクチャを作成したりできるツールはありますか?

回答 :視覚的なツールが必要な場合は、はいではなく、いいえをご覧ください。 TensorFlowには何かをレンダリングするプラグインがいくつかありますが。 しかし、全体として、これは実際にはそれほど大きな問題ではありません。なぜなら、ニューラルネットワークは多くの場合、何らかの構造、テキストファイル、またはコードの形で与えられ、変更することはそれほど難しくないので、そこにレイヤーを追加してそれらをプログラムできます。 それは実際にはプログラミングでさえありません。実際、そのような特別なDSLです。 いくつかのレイヤーを追加しました。

これらすべての作品で最も難しいのは、レイヤー間で観察する次元です。 これらの多次元配列にテンソルがどのように配置されているかを本当に理解していない場合、次元と混同される可能性があります。 これは、これらすべての中で最も難しい部分です。

質問 :あなたは非常に多くの異なるリカレントアーキテクチャについて話しました

ニューラルネットワーク。 そして、あなたは正確に何を使用し、どのタスクのために

回答 :ほとんどのタスクでは、LSTMボックスからの単純なニューラルネットワークが十分に機能し、十分な深さとサイズがあります。 テキスト分類、シーケンス内のあらゆるものの分類には多くのタスクがあります。 LSTMネットワークのいずれかで開始する場合、これは原則として通常の開始です。 この場所で双方向性が役立つことを理解している場合、双方向LSTMを実行しています。

あらゆる種類のクールなオプションから注意を払って開始することは素晴らしいことですが、それらをゼロからプログラムするのは難しいため、開始するのは困難です。 結局、些細なことではありません。 そして、あなたが取って使うコードのそのような良い部分はあまりありません。 私にとって、これまでのベースラインはLSTMネットワークです-単方向または双方向です。 テキストと画像を分類するためにそれらを使用しました(数字認識)。

質問 :暗号化アルゴリズムを解読するためにニューラルネットワークが使用されていることを知っています。たとえば、プレーンテキストが入力であり、暗号文が出力です。 そして、反対方向に、暗号化されたテキストが送信され、トレーニングは単に出力でオープンを受け取ります。 問題は、この分野で現在どのような進展があり、実際に機能するのか、そしてこれにどのようなアーキテクチャを使用できるのかということです。

回答 :これについてはあまり言えません。 私はこの分野では有能ではありません、いわば有能です。 私は、暗号化のそのようなセキュリティとのインターフェースで働いていません。 1つのニューラルネットワークがコードを生成し、もう1つのニューラルネットワークがクラッキングするというGoogleの新鮮な作品を見ました。 しかし、それにもかかわらず、これらの例は優れた暗号アルゴリズムとはほど遠いようです。 私は、これがシリーズのレベルでの研究であるように思えます。 深刻な暗号を破るクールな仕事について聞いたことがない。

このレポートは、高負荷システムHighLoad ++の開発者の会議で行われた最高のスピーチの1つの転写です 。 HighLoad ++ 2017カンファレンスの1か月未満が残ります。

私たちはすでに会議プログラムを準備しており、現在スケジュールが積極的に形成されています。

今年は、ニューラルネットワークのトピックを引き続き調査します。

また、これらの資料の一部は、高負荷システムHighLoadの開発に関するオンライントレーニングコースで使用されますガイドは、特別に選択された文字、記事、資料、ビデオのチェーンです。 私たちの教科書にはすでに30以上のユニークな資料があります。 接続してください!