並列計算システムアーキテクチャの普及により、このタイプのハードウェアリソースを十分に活用できるソフトウェア開発ツールへの関心が高まっています。

ただし、現時点では、消費者市場で利用可能な並列処理のハードウェア実装とサポート用のソフトウェアには一定のギャップがあります。 そのため、マルチコア汎用コンピューターが現在の10年半ばに標準になった一方で、そのようなシステム用のプログラムを開発するための一般的な標準であるOpenMPの出現は、ほぼ10年前に注目されました[1]。 ほぼ同時に、分散環境のプロセス間でメッセージを転送する方法を説明するMPI標準が策定されました[2]。

パラダイムをオブジェクト指向のアプローチに適合させずに機能を拡張することでのみ表現されるこれらの標準の両方の開発は、Microsoft .NET Frameworkなどの最新のプログラミングプラットフォームと互換性がないという事実につながります。 そのため、これらのプラットフォームの開発者は、製品に並列処理を実装するための追加の努力をしなければなりません。

[3]で、著者はこれらの技術の1つであるMicrosoft Parallel Extensionsを検討しました。これにより、共有メモリを備えたコンピューターの初期シーケンシャルマネージコードに並列処理を実装するかなり簡単な方法が可能になります。 また、科学計算に.NET Frameworkを使用する可能性と便利さも示されました。 それにもかかわらず、コンピューティングクラスタなどの分散メモリを備えたシステムでの複雑な計算に使用されるプログラムを開発するためのこのプラットフォームの適用性の問題は未解決のままです。 これらのシステムは、相互接続されたコンピューティングノードのセットに基づいています。各ノードは、独自のプロセッサ、メモリ、I / Oサブシステム、オペレーティングシステムを備えた本格的なコンピューターであり、各ノードは独自のアドレス空間で動作します。

MPI 主なアイデアと欠点

関数型プログラミングの世界では、このタイプの並列コンピューター用のプログラムを作成するための最も一般的なテクノロジーはMPIです。 この場合の並列プロセスの相互作用の主な方法は、あるノードから別のノードへのメッセージの送信です。 MPI標準は、各コンピューティングプラットフォームのプログラミングシステムとユーザーがプログラムを作成する際に尊重する必要があるインターフェイスを修正します。

MPIはFortranとCをサポートします。MPIプログラムは、相互作用する並列プロセスのセットです。 すべてのプロセスは一度生成され、プログラムの並列部分を形成します。 各プロセスは独自のアドレス空間で動作し、MPIには共通の変数やデータはありません。 プロセス間の対話の主な方法は、あるプロセスから別のプロセスへのメッセージの明示的な送信です。 [4]

MPIプログラムは高いレベルのパフォーマンスを示すという事実にもかかわらず、テクノロジー自体にはいくつかの欠点があります。

- 低レベル(MPIでのプログラミングは、アセンブラーでのプログラミングと比較されることが多い)、プロセス間のメッセージの交換だけでなく、配列の分散の詳細な制御とプロセス間のループの反復の必要性-これはすべて、プログラム開発の高度な複雑性につながります;

- 送信されたメッセージのデータ型の過剰な指定の必要性、および送信されたデータの型に対する厳格な制限の存在。

- 任意のサイズの配列と任意の数のプロセスで実行できるプログラムを記述するのは複雑であるため、既存のMPIプログラムを再利用することはできません。

- オブジェクト指向アプローチのサポートの欠如。

これらの欠点のいくつかが、.NET Frameworkなどの最新の開発プラットフォームでMPIインターフェイスをサポートしていない理由である可能性があります。これにより、大きな計算問題の解決への適用性が大幅に制限される可能性があります。

それにもかかわらず、3番目のバージョンから、.NET FrameworkにはWindows Communication Foundation(WCF)が含まれています。これは、Microsoftプラットフォーム上であらゆる種類の分散アプリケーションを作成するための統合テクノロジーです[5]。 残念ながら、この技術はXMLベースのWebサービスを操作するためのフレームワークとしてしか理解されていないことが多く、WCFが並列コンピューティングを整理するための効果的なツールと見なされることはありません。

WCF構造

分散メモリシステム用のプログラムを開発するためのツールとしてWCFを使用する可能性を判断するために、この技術の基本を検討します。 WCFサービスは、クライアントにいくつかの有用な機能を提供するエンドポイントのセットです。 エンドポイントは、単にメッセージを送信できるネットワークリソースです。 提供される機会を活用するために、クライアントは、クライアントとサービス間の契約で記述された形式でエンドポイントにメッセージを送信します。 サービスは、メッセージが合意された形式で記録されると想定して、メッセージがエンドポイントアドレスに到着するのを待っています。

クライアントがサービスに情報を送信するには、アドレス、バインディング、契約という「APK」を知っている必要があります。

アドレスは、エンドポイントがメッセージを受信できるように、メッセージの送信

先を決定します。

バインディングは、エンドポイントとの通信用のチャネルを定義します。 WCFアプリケーションで循環するすべてのメッセージは、チャネルを介して送信されます。 チャネルは、いくつかのバインディング要素で構成されます。 最下位レベルでは、バインディング要素はネットワークを介したメッセージ配信を提供するトランスポートメカニズムです。 上記のバインディング要素は、セキュリティおよびトランザクションの整合性要件を説明しています。 WCFには、一連の定義済みバインディングが付属しています。 たとえば、basicHttpBindingバインディングは、2007年以前に作成されたほとんどのWebサービスへのアクセスに適用できます。 バインディングnetTcpBindingは、2つの.NETシステム間の通信用にTCPプロトコルを介した高速データ交換を実装します。 netNamedPipeBindingは、単一のマシン内または複数の.NETシステム間の通信用に設計されています。 また、ピアツーピアネットワークで動作するアプリケーションの構築もサポートしています。これには、netPeerTcpBindingバインディングがあります。

コントラクトは、エンドポイントによって提供される一連の機能、つまり、エンドポイントが実行できる操作、およびこれらの操作のメッセージ形式を定義します。 コントラクトで説明されている操作は、エンドポイントを実装するクラスのメソッドにマップされ、特に各メソッドとの間で受け渡しされるパラメーターのタイプが含まれます。 WCFは、任意のデータ型の同期および非同期の一方向および二重操作をサポートします。これは、.NET Frameworkに基づいて分散アプリケーションを構築し、大きな計算問題を解決するのに十分です。 ただし、提供される情報は、この場合のWCFテクノロジの実用的な適用性と有効性の評価には役立ちません。

WCFの有効性を評価する方法

次の位置からWCFの適用性を評価します。

- 計算問題を解決するための分散アプリケーションを開発する能力と複雑さ。

- 分散アプリケーションのコンポーネント間のデータ交換の効率。

- WCFを使用した分散コンピューティングの全体的な効率。

この評価は、分散メモリ(MPI)を備えたシステム用の並列プログラムを構築する比較的一般的で実績のある手段を実行するのに適しているようです。 このアプローチにより、効率の評価は、同様の環境のWCFおよびMPIプラットフォームでの同様のプログラムの実行時間の比較分析に限定されます。 同様のプログラムとは、使用される最適化と同一のデータ型まで、同じ計算アルゴリズムを使用するプログラムを意味します。 同様の環境は、実験の実施に使用されるコンピューティングおよびネットワークハードウェアリソースのIDを指します。

可能性の実例として、WCFを使用した計算タスクのアプリケーション開発の複雑さを評価するとともに、公式のMPIリソースで説明されているデモアルゴリズムを実装することを提案します[6]。

ソリューションのパフォーマンスをテストするために、4台と2台の同等のパフォーマンスのプロセッサコアを搭載した2台のコンピューターを使用します。 通信はイーサネット100Mbit経由です。 WCFテストはMicrosoft Windows 7 OSで実行され、Pelican HPC [7]はOpen MPI 1.3.3を使用してLinux 2.6.30カーネルでMPIクラスターを構築するために使用されます。

簡単な情報交換プログラム

コンピューターネットワークのコンポーネント間のデータ交換の有効性を示すために設計された最も単純なテストは、あるノードから別のノードへ、またはその逆に倍精度実数の配列を送信し、これらの操作に費やされる時間を修正することです。 MPIのC ++コードは次のとおりです。

#define NUMBER_OF_TESTS 10

int main( argc, argv )

int argc;

char **argv;

{

double *buf;

int rank, n, j, k, nloop;

double t1, t2, tmin;

MPI_Status status;

MPI_Init( &argc, &argv );

MPI_Comm_rank( MPI_COMM_WORLD, &rank );

if (rank == 0)

printf( "Kind\t\tn\ttime (sec)\tRate (MB/sec)\n" );

for (n=1; n<1100000; n*=2) {

if (n == 0) nloop = 1000;

else nloop = 1000/n;

if (nloop < 1) nloop = 1;

buf = (double *) malloc( n * sizeof(double) );

tmin = 1000;

for (k=0; k<NUMBER_OF_TESTS; k++) {

if (rank == 0) {

t1 = MPI_Wtime();

for (j=0; j<nloop; j++) {

MPI_Ssend( buf, n, MPI_DOUBLE, 1, k, MPI_COMM_WORLD );

MPI_Recv( buf, n, MPI_DOUBLE, 1, k, MPI_COMM_WORLD,

&status );

}

t2 = (MPI_Wtime() - t1) / nloop;

if (t2 < tmin) tmin = t2;

}

else if (rank == 1) {

for (j=0; j<nloop; j++) {

MPI_Recv( buf, n, MPI_DOUBLE, 0, k, MPI_COMM_WORLD,

&status );

MPI_Ssend( buf, n, MPI_DOUBLE, 0, k, MPI_COMM_WORLD );

}

}

}

if (rank == 0) {

double rate;

if (tmin > 0) rate = n * sizeof(double) * 1.0e-6 /tmin;

else rate = 0.0;

printf( "Send/Recv\t%d\t%f\t%f\n", n, tmin, rate );

}

free( buf );

}

MPI_Finalize( );

return 0;

}

その操作には、2つのMPIプロセスが必要です。その間に、MPI_Recv()およびMPI_Ssendコマンドを使用して、サイズが1から1048576のdouble要素の配列を交換します。 前述のMPI欠陥の影響に注目する価値があります。

- 両方のプロセスの機能の分離は、プロセスの数のみに基づいており、プログラムをリストするという認識を複雑にします。

- データ(MPI_Ssend)を送信する前に、受信側が受信(MPI_Recv)を明示的に初期化したことを確認する必要があります。これにより、開発プロセスが複雑になります。

- 送信されたデータのタイプ(MPI_DOUBLE)をデータ自体と一緒に指定することは、合理的な観点からは不要であり、プログラムの論理エラーにつながる可能性もあります。

- さらに、プログラミング言語の編成に関連する不快な瞬間は、メモリを手動で割り当てたり解放したりする必要があることです。

次に、同じ問題の解決策を検討しますが、C#ではWCFテクノロジを使用します。 まず、コンピューティングノード間で情報を交換するためのインターフェースのペアを定義する必要があります。 2番目のインターフェイスであるIClientCallbackの必要性は、操作の非同期的な性質によるものです。

[ServiceContract(CallbackContract = typeof(IClientCallback))] public interface IServerBenchmark

{

[OperationContract(IsOneWay = true)] void SendArray(double[] array);

}

public interface IClientCallback

{

[OperationContract(IsOneWay = true)] void SendArrayFromServer(double[] array);

}

以下は、クライアントアプリケーションから実数の配列を受信して送信するサーバーアプリケーションのロジックを実装するクラスについて説明しています。

public class ServerBenchmark : IServerBenchmark

{

public void SendArray(double[] array)

{

OperationContext.Current.GetCallbackChannel<IClientCallback>().SendArrayFromServer(array);

}

}

農業産業複合体を登録するサーバーアプリケーションのメインメソッドが実装されます。 この場合、サーバーアプリケーションの動作は、コードとアプリケーションの.configファイルの両方の設定に従って構成できます。

class Program

{

static void Main(string[] args)

{

ServiceHost serviceHost = new ServiceHost();

NetTcpBinding binding = new NetTcpBinding();

serviceHost.AddServiceEndpoint(typeof(IServerBenchmark), binding, "");

serviceHost.Open();

Console.ReadLine();

serviceHost.Close();

}

}

クライアントアプリケーションは次のとおりです。CallBackHandlerクラスは前述の対応するインターフェイスを実装し、Clientクラスはエントリポイントとして機能する静的メソッドを提供します。

public class CallbackHandler : IServerBenchmarkCallback

{

private static EventWaitHandle _waitHandle = new EventWaitHandle(false, EventResetMode.AutoReset);

static int _totalIterations = 10;

public static DateTime _dateTime;

public void SendArrayFromServer(double[] array)

{

_waitHandle.Set();

}

class Client

{

private static InstanceContext _site;

static void Main(string[] args)

{

_site = new InstanceContext(new CallbackHandler());

ServerBenchmarkClient client = new ServerBenchmarkClient(_site);

double[] arr = new double[Convert.ToInt32(args[0])];

for (int index = 0; index < arr.Length;index++ )

arr[index] = index;

_dateTime = DateTime.Now;

for (int index = 0; index < _totalIterations; index++)

{

client.SendArray(arr);

_waitHandle.WaitOne();

}

Console.WriteLine((DateTime.Now - _dateTime).TotalMilliseconds / _totalIterations);

Console.ReadKey();

}

}

}

プログラムは、データ配列を渡してリモートSendArrayメソッドを呼び出し、サーバーから返されたデータを受信するSendArrayFromServerメソッドへの呼び出しを待機する、いくつかの反復を実行します。

提示されたコードには、MPIに関するいくつかの重要な利点があります。

- インターフェース(契約)に実装された、送信データのフォーマットの統一された1回限りの記述。

- リモートメソッド呼び出しの簡単な実装。

- オブジェクト指向の開発アプローチを使用します。

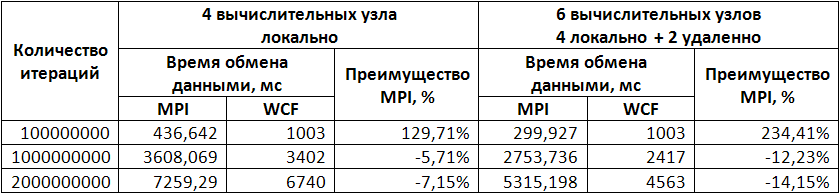

したがって、WCFを使用すると、分散アプリケーションを作成するタスクが大幅に簡素化されると言えます。 パフォーマンステストの結果は以下のとおりです。

この表から、残念ながら、WCFテクノロジは、小さなデータの頻繁なプロセス間交換を必要とするプログラムの開発には適していません。

分散コンピューティングの例

次に、ノード間のアクティブなデータ交換を必要としない分散アプリケーションを構築する可能性を検討します。 基礎として、リソース[6]から別の例を取り上げます-数Piの計算。 この例では、Piは次のように計算されます

。 このアルゴリズムの並列性は非常に簡単に検出できます。積分区間は、計算に関与する計算ノードと同じ数の部分に分割されます。 問題を解決するMPI用のC ++プログラムは次のとおりです。

int main(argc,argv)

int argc;

char *argv[];

{

int done = 0, n, myid, numprocs, i;

double PI25DT = 3.141592653589793238462643;

double mypi, pi, h, sum, x;

MPI_Init(&argc,&argv);

MPI_Comm_size(MPI_COMM_WORLD,&numprocs);

MPI_Comm_rank(MPI_COMM_WORLD,&myid);

while (!done)

{

if (myid == 0) {

printf("Enter the number of intervals: (0 quits) ");

scanf("%d",&n);

}

MPI_Bcast(&n, 1, MPI_INT, 0, MPI_COMM_WORLD);

if (n == 0) break;

h = 1.0 / (double) n;

sum = 0.0;

for (i = myid + 1; i <= n; i += numprocs) {

x = h * ((double)i - 0.5);

sum += 4.0 / (1.0 + x*x);

}

mypi = h * sum;

MPI_Reduce(&mypi, &pi, 1, MPI_DOUBLE, MPI_SUM, 0,

MPI_COMM_WORLD);

if (myid == 0)

printf("pi is approximately %.16f, Error is %.16f\n",

pi, fabs(pi - PI25DT));

}

MPI_Finalize();

return 0;

}

コードは非常に簡潔ですが、上記のMPIのすべての欠陥が特徴です。 WCFの場合、C#のサーバー部分は次のとおりです。

[ServiceContract] public interface IPiService

{

[OperationContract] double CalculatePiChunk(int intervals, int processId, int processesCount);

}

public class PiService : IPiService

{

public double CalculatePiChunk(int intervals, int processId, int processesCount)

{

double h = 1.0 / (double)intervals;

double sum = 0.0;

double x;

for (int i = processId + 1; i <= intervals; i += processesCount)

{

x = h * (i - 0.5);

sum += 4.0 / (1.0 + x * x);

}

return h * sum;

}

}

public class Service

{

public static void Main(string[] args)

{

ServiceHost serviceHost = new ServiceHost(typeof(PiService));

serviceHost.AddServiceEndpoint(typeof(IPiService), new NetTcpBinding(), "");

serviceHost.Open();

Console.ReadLine();

serviceHost.Close();

}

}

サーバー部分の割り当ては、コードの理解を容易にするだけでなく、特定のクライアントを参照せずにコードを再利用することも可能にします。 クライアント自体は、次のように実装できます(リモートメソッドCalculatePiChunkは、各コンピューティングノードで独自のパラメーターセットを使用して非同期的に呼び出されます)。

class Client

{

private static double _pi;

private static DateTime _startTime;

static int _inProcess = 0;

static void Main(string[] args)

{

_pi = 0;

int intervals = Convert.ToInt32(args[0]);

List<String> endPoints = new List<string>();

for (int index = 1; index<args.Length;index++)

endPoints.Add(args[index]);

double pi = 0;

_inProcess = endPoints.Length;

PiServiceClient[] clients = new PiServiceClient[endPoints.Length];

for (int index = 0; index < endPoints.Length; index++)

clients[index] = new PiServiceClient("NetTcpBinding_IPiService", "net.tcp://" + endPoints[index] + "/EssentialWCF");

_startTime = DateTime.Now;

for (int index = 0; index< endPoints.Length; index++)

clients[index].BeginCalculatePiChunk(intervals, index, endPoints.Length, GetPiCallback, clients[index]);

Console.ReadKey();

}

static void GetPiCallback(IAsyncResult ar)

{

double d = ((PiServiceClient)ar.AsyncState).EndCalculatePiChunk(ar);

lock(ar)

{

_pi += d;

_inProcess--;

if (_inProcess == 0)

{

Console.WriteLine(_pi);

Console.WriteLine("Calculation ms elasped: " + (DateTime.Now - _startTime).TotalMilliseconds);

}

}

}

}

パフォーマンスの測定値は次のとおりです。

これらの結果に基づいて、少数のプロセス間通信で分散コンピューティングアプリケーションを構築するための.NET Framework WCFテクノロジーの使用は良い結果を示すと判断できます。比較的低いデータ交換率は、.NETを管理する方法でのJITコードの定性的最適化[3]によって補われます多くの状況でプログラムはより生産的です。

提示された簡単なテストの結果に基づいて、次の結論を導き出すことができます。

- プラットフォームでのアプリケーション開発:分散メモリを備えたシステムで計算上の問題を解決するためのNET Frameworkが可能です。

- この種のアプリケーションを構築するために設計されたWCFテクノロジは、MPIで実装されるよりもはるかに簡単なプロセス間通信の方法を提供します。

- 同様に、この単純さにより、データ交換プロセスのパフォーマンスが大幅に低下します。場合によっては、MPIはWCFよりも2.5倍以上高速です。

- したがって、WCFは、コンピューティングノード間で小さなデータグループを集中的に交換する必要がある問題の解決には適していません。

- ただし、まれなプロセス間通信の場合、このテクノロジーの使用は非常に正当化されます.MPIと比較して単純な開発方法に加えて、.NET Frameworkは、結果のプログラムの相互運用性、自動メモリ管理、言語間の相互作用、機能のサポートなど、科学計算を編成するためのその他の利点を提供しますプログラミング。 [3]

文学

1. OpenMPリファレンス。 OpenMPアーキテクチャレビューボード、2008 r。

2. MPI 2.1リファレンス。 テネシー大学、2008 r。

3. .NETでの並列プログラミング。 ティホノフ、I。V.イルクーツク、2009年。XIVバイカル全ロシア会議「科学と管理における情報と数学技術」の議事録。

4.アントノフ、A。S. MPIテクノロジーを使用した並列プログラミング。 M。:MSU出版社。

5.レスニック、スティーブ、クレーン、リチャード、ボーエン、クリス。 .NET Framework 3.5のWindows Communication Foundationの基本。 M。:DMK Press、2008年。

6. Message Passing Interface(MPI)標準。

www.mcs.anl.gov/research/projects/mpi7. PelicanHPC GNU Linux。

pareto.uab.es/mcreel/PelicanHPC